Introduktion till enkel linjär regression

Från ordbok : En återgång till ett tidigare eller mindre utvecklat tillstånd.

I statistik: Ett mått på förhållandet mellan medelvärdet för en variabel och motsvarande värden för de andra variablerna.

Regressionen, i vilken förhållandet mellan inmatningsvariabeln (oberoende variabel) och målvariabeln (beroende variabel) betraktas som linjär kallas Linjär regression. Enkel linjär regression är en typ av linjär regression där vi bara har en oberoende variabel för att förutsäga den beroende variabeln. Enkel linjär regression är en av maskininlärningsalgoritmerna. Enkel linjär regression tillhör familjen Supervised Learning. Regression används för att förutsäga kontinuerliga värden.

Modell för enkel linjär regression

Låt oss göra det enkelt. Hur allt började?

Det hela började 1800 med Francis Galton. Han studerade förhållandet i höjd mellan fäder och deras söner. Han observerade ett mönster: Antingen sonens höjd skulle vara lika hög som hans fars höjd eller sonens höjd tenderar att vara närmare den totala genomsnittliga höjden för alla människor. Detta fenomen är inget annat än regression.

Till exempel är Shaq O'Neal en mycket berömd NBA-spelare och är 2, 16 meter lång. Hans söner Shaqir och Shareef O'neal är 1, 96 meter respektive 2, 06 meter höga. Den genomsnittliga befolkningshöjden är 1, 76 meter. Son's höjd regress (drift mot) medelhöjden.

Hur gör vi regression?

Beräkna en regression med endast två datapunkter:

Allt vi vill göra för att hitta den bästa regressionen är att rita en linje som är så nära varje punkt som möjligt. När det gäller två datapunkter är det enkelt att rita en linje, bara gå med dem.

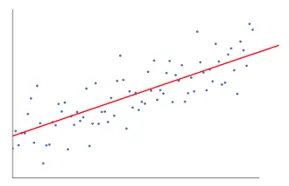

Om vi nu har ett antal datapunkter nu hur ska vi rita linjen som är så nära som möjligt för varje datapunkt.

I detta fall är vårt mål att minimera det vertikala avståndet mellan linjen och alla datapunkter. På detta sätt förutsäger vi den bästa linjen för vår linjära regressionsmodell.

Vad enkel linjär regression gör är?

Nedan är detaljförklaringen av Simple Linear Regression:

- Det ritar massor av möjliga linjer och gör sedan någon av denna analys.

- Summan av kvadratiska fel.

- Summan av absoluta fel.

- minsta kvadratmetod … osv

- För vår analys kommer vi att använda den minst kvadratiska metoden.

- Vi kommer att göra skillnad mellan alla poäng och beräkna kvadratet på summan av alla poäng. Oavsett vilken linje som ger minimisumman blir vår bästa linje.

Till exempel: Genom att göra detta kan vi ta flera män och deras sons höjd och göra saker som att berätta för en man hur lång hans son kunde vara. innan han till och med föddes.

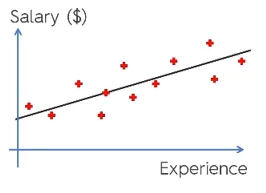

Google bild

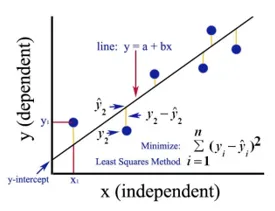

Figuren ovan visar en enkel linjär regression. Linjen representerar regressionslinjen. Anges av: y = a + b * x

Där y är den beroende variabeln (DV): Till exempel hur en persons lön förändras beroende på antalet års erfarenhet som den anställda har. Så här är lönen för en anställd eller person din beroende variabel.

Den beroende variabeln är vår målvariabel, den vi vill förutsäga med hjälp av linjär regression.

x är vår oberoende variabel (IV): Den beroende variabeln är orsaken till den oberoende variabeln. I exemplet ovan är antalet års erfarenhet vår beroende variabel, eftersom antalet års erfarenhet orsakar den anställdas löneförändring.

- b är koefficientvariabeln för vår oberoende variabel x. Denna koefficient spelar en avgörande roll. Den säger hur en enhetsförändring i x (IV) kommer att påverka y (DV). Det kallas också proportionella koefficienten. När det gäller matematik, är det upp till dig är linjen lutning eller så kan du säga brant av linjen.

- I vårt exempel, om lutningen (b) är mindre, vilket betyder att antalet år kommer att ge mindre lönekvot å andra sidan om lutningen (b) är mer kommer att ge en hög löneförhöjning med en ökning av antalet År av erfarenhet.

- a är ett konstant värde. Det kallas också avlyssning, det är där linjen korsar y-axeln eller DV-axeln. På ett annat sätt kan vi säga att när en anställd har noll års erfarenhet (x) kommer lönen (y) för den anställda att vara konstant (a).

Hur fungerar Least Square?

Nedan är poäng för minst fyrkantigt arbete:

- Det drar en godtycklig linje enligt datatrenderna.

- Den tar datapunkter och ritar vertikala linjer. Den betraktar vertikalt avstånd som en parameter.

- Dessa vertikala linjer kommer att klippa regressionslinjen och ger motsvarande punkt för datapunkter.

- Den kommer sedan att hitta den vertikala skillnaden mellan varje datapunkt och dess motsvarande datapunkt på regressionslinjen.

- Det kommer att beräkna felet som är kvadrat med skillnaden.

- Därefter beräknas summan av fel.

- Återigen kommer det att rita en linje och upprepa ovanstående procedur igen.

- Det ritar ett antal rader på detta sätt och den linje som ger den minsta summan av fel väljs som den bästa linjen.

- Den här bästa linjen är vår enkla linjära regressionslinje.

Användning av enkel linjär regression

Regressionsanalys utförs för att förutsäga den kontinuerliga variabeln. Regressionsanalysen har en mängd olika tillämpningar. Några exempel är följande:

- Predictive Analytics

- Effektivitet av marknadsföring,

- prissättning av en lista

- marknadsföringsprognos för en produkt.

Här kommer vi att diskutera en tillämpning av linjär regression för prediktiv analys. Vi kommer att göra modellering med python.

Stegen vi kommer att följa för att bygga vår modell är följande:

- Vi kommer att importera bibliotek och datasätt.

- Vi kommer att förbereda data.

- Vi delar upp data i testuppsättningen och träningsuppsättningen.

- Vi kommer att skapa en modell som kommer att försöka förutsäga målvariabeln baserat på vår träningsuppsättning

- Vi kommer att förutsäga målvariabeln för testuppsättningen.

- Vi kommer att analysera de resultat som förutses av modellen

För vår analys kommer vi att använda en lönesats med 30 anställdas data.

# Importera biblioteken

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Importera datasatsen (Exempel på data visas i tabellen)

dataset = pd.read_csv('Salary_Data.csv')

| År av erfarenhet | Lön |

| 1, 5 | 37731 |

| 1, 1 | 39343 |

| 2, 2 | 39891 |

| 2 | 43525 |

| 1, 3 | 46205 |

| 3, 2 | 54.445 |

| 4 | 55.749 |

# Förbehandla datasatsen, här kommer vi att dela upp datauppsättningen i den beroende variabeln och oberoende variabel. x som oberoende och y som beroende eller målvariabel

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Dela upp datasatsen i träningsuppsättningen och testuppsättningen:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Här visar teststorlek 1/3 att från total data 2/3 del är för att träna modellen och resten 1/3 används för att testa modellen.

# Låt oss anpassa vår enkla linjära regressionsmodell till träningsuppsättningen

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Linjär regressionsmodell är utbildad nu. Denna modell kommer att användas för att förutsäga den beroende variabeln.

# Förutsäga testuppsättningsresultaten

y_pred = regressor.predict(X_test)

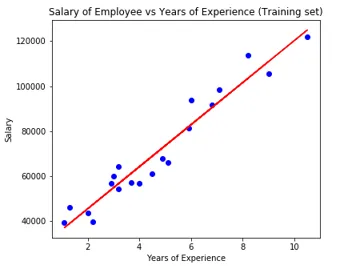

# Visualisera testuppsättningsresultaten

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Parameter för modell

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Så interceptor (a) -värdet är 26816. Det tyder på att alla fräschare (noll erfarenhet) skulle få cirka 26816 belopp som lön.

Koefficienten för vår modell kom ut som 9345, 94. Det antyder att om alla andra parametrar är konstanta, kommer förändringen i en enhet i den oberoende variabeln (exp. År) att ge en förändring på 9345 enheter i lön.

Metoder för regression utvärdering

Det finns i princip tre viktiga utvärderingsmetoder som finns tillgängliga för regressionsanalys:

- Genomsnittligt absolut fel (MAE): Det visar medelvärdet för de absoluta felen, vilket är skillnaden mellan förutsagda och faktiska.

- Medelkvadratfel (MSE): Det visar medelvärdet på kvadratfel.

- Root Mean Squared Error (RMSE): Det visar kvadratroten av medelvärdet för de kvadratiska felen.

Vi kan jämföra ovanstående metoder:

- MAE: Det visar det genomsnittliga felet och det enklaste av alla tre metoder.

- MSE: Den här är mer populär än MAE eftersom den förbättrar de större felen, vilket i resultat visar mer insikter.

- RMSE: Den här är bättre än MSE eftersom vi kan tolka felet i termer av y.

Dessa 3 är inget annat än förlustfunktionerna.

# Utvärdering av modell

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Slutsats

Linjär regressionsanalys är ett kraftfullt verktyg för maskininlärningsalgoritmer, som används för att förutsäga kontinuerliga variabler som lön, försäljning, prestanda etc. Linjär regression beaktar den linjära relationen mellan oberoende och beroende variabler. Enkel linjär regression har bara en oberoende variabel baserad på vilken modellen förutsäger målvariabeln. Vi har diskuterat modellen och tillämpningen av linjär regression med ett exempel på prediktiv analys för att förutsäga anställdas lön.

Rekommenderade artiklar

Detta är en guide till enkel linjär regression. Här diskuterar vi modellen och tillämpningen av linjär regression med hjälp av ett prediktivt analysexempel för att förutsäga anställdas löner. Du kan också gå igenom våra andra relaterade artiklar för att lära dig mer-

- Linjär regressionsanalys

- Linjär regression i R

- Linjär regressionsmodellering

- Verktyg för regressionstest

- Matplotlib I Python | Topp 14 tomter i Matplotlib

- Ordbok i Python | Metoder och exempel

- Exempel på Square Root i PHP

- Linjär regression vs logistisk regression | Topp skillnader