Vad är Hadoop?

Fem mätningar av Hadoop är volym, variation, hastighet, veracitet och värde. Data ökar snabbt och de kommer i ett strukturerat, ostrukturerat och semistrukturerat format. Data ökar med hög hastighet och vi borde få en viss meningsfull insikt från uppgifterna. Data måste ha ett visst värde, men det finns vissa inkonsekvenser och osäkerhet i uppgifterna. Traditionella system som lagrar data kan inte lagra dessa snabbt ökande data på grund av lagringsutrymme. Det traditionella systemet kan inte bearbeta data finns i komplex datastruktur och det tar enormt mycket tid att bearbeta data. Hadoop skulle lösa frågan om det traditionella databassystemet. Hadoop är ett ramverk som behandlar en enorm mängd data parallellt och lagrar dem i en distribuerad miljö. Hadoop har två komponenter 1) HDFS (lagra data över ett kluster) 2) MapReduce (bearbeta data parallellt). HDFS kommer att lagra data i form av olika block. Standardblockstorleken är 128MB.

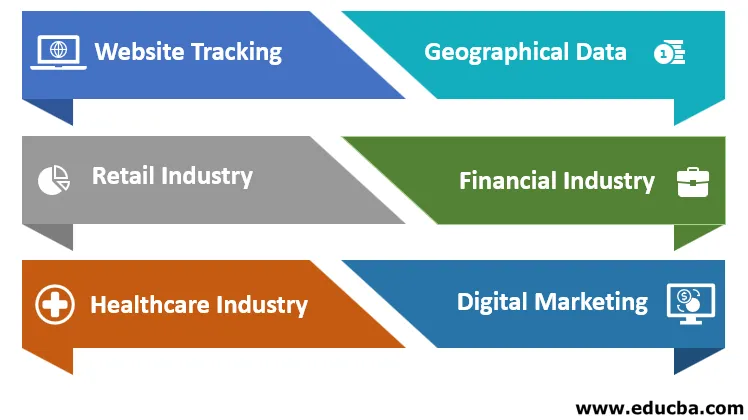

Ansökningar från Hadoop

Tillämpningarna av Hadoop förklaras nedan:

a. Webbspårning

Anta att du har skapat en webbplats, vill veta om besökarnas detaljer. Hadoop kommer att fånga en enorm mängd data om detta. Det kommer att ge information om besökarens plats, vilken sid besökare besökte först och mest, hur mycket tid som spenderas på webbplatsen och på vilken sida, hur många gånger en besökare har besökt sidan, vad besökaren gillar mest om. Detta ger en prediktiv analys av besökarnas intresse, webbplatsens prestanda kommer att förutsäga vad som skulle vara användarnas intresse. Hadoop accepterar data i flera format från flera källor. Apache HIVE kommer att användas för att bearbeta miljontals data.

b. Geografiska data

När vi köper produkter från en e-handelswebbplats. Webbplatsen kommer att spåra användarens placering, förutsäga kundköp med smartphones, surfplattor. Hadoop-kluster hjälper till att ta reda på affärer på geolokalisering. Detta hjälper branscherna att visa affärsgrafen inom varje område (positivt eller negativt).

c. Detaljhandel

Återförsäljare kommer att använda data från kunder som finns i strukturerat och ostrukturerat format för att förstå, analysera uppgifterna. Detta hjälper en användare att förstå kundernas krav och tjäna dem med bättre fördelar och förbättrade tjänster.

d. Finansiell industri

Finansiella företag och finansiella företag kommer att bedöma den finansiella risken, marknadsvärdet och bygga modellen som ger kunder och industrin bättre resultat när det gäller investeringar som aktiemarknaden, FD, etc. Förstå handelsalgoritmen. Hadoop kommer att köra byggmodellen.

e. Sjukvårdsindustri

Hadoop kan lagra stora mängder data. Medicinska uppgifter finns i ett ostrukturerat format. Detta hjälper läkaren för en bättre diagnos. Hadoop lagrar en patientläkarhistoria på mer än 1 år, kommer att analysera symtomen på sjukdomen.

f. Digital marknadsföring

Vi befinner oss i 20-talets era, varje person är ansluten digitalt. Information nås till användaren via mobiltelefoner eller bärbara datorer och människor blir medvetna om varje enskild detalj om nyheter, produkter etc. Hadoop kommer att lagra massivt online genererade data, lagra, analysera och ge resultatet till de digitala marknadsföringsföretagen.

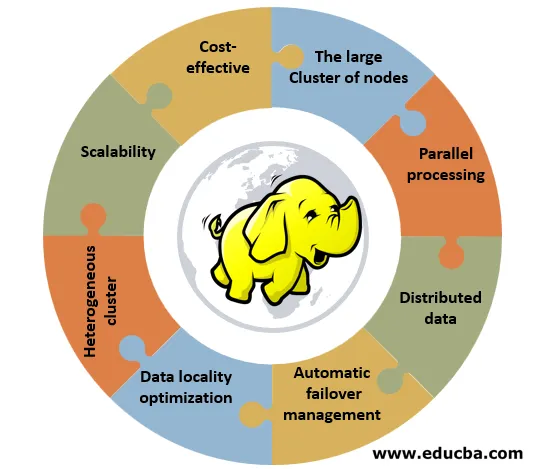

Funktioner hos Hadoop

Nedan visas funktionerna i Hadoop:

1. Kostnadseffektivt: Hadoop kräver ingen specialiserad eller effektiv hårdvara för att implementera den. Det kan implementeras på enkel hårdvara som kallas community hardware.

2. Den stora kluster av noder: Ett kluster kan bestå av 100-tal eller 1000-tal noder. Fördelen med att ha ett stort kluster är att det erbjuder mer datorkraft och ett enormt lagringssystem för kunderna.

3. Parallell behandling: Data kan behandlas samtidigt över alla kluster och denna process kommer att spara mycket tid. Det traditionella systemet kunde inte utföra denna uppgift.

4. Distribuerad data: Hadoop-ramverket tar hand om delning och distribution av data över alla noder inom ett kluster. Den replikerar data över alla kluster. Replikeringsfaktorn är 3.

5. Automatisk failoverhantering: Antag att om någon av noderna i ett kluster misslyckas kommer Hadoop-ramverket att ersätta felmaskinen med en ny maskin. Replikeringsinställningar för den gamla maskinen flyttas automatiskt till den nya maskinen. Admin behöver inte oroa sig för det.

6. Optimering av datalokalisering: Antag att programmeraren behöver data för noden från en databas som finns på en annan plats, programmeraren skickar en byte med kod till databasen. Det sparar bandbredd och tid.

7. Heterogent kluster: Den har en annan nod som stöder olika maskiner med olika versioner. IBM-maskin stöder Red Hat Linux.

8. Skalbarhet: Lägga till eller ta bort noder och lägga till eller ta bort hårdvarukomponenter till eller från klustret. Vi kan utföra denna uppgift utan att störa klusterfunktionen. RAM eller hårddisk kan läggas till eller tas bort från klustret.

Fördelar med Hadoop

Fördelarna med Hadoop förklaras nedan:

- Hadoop kan hantera stor datavolym och kunna skala uppgifterna baserat på datakravet. Nu finns en dags data i 1 till 100 tera-byte.

- Det kommer att skala en enorm mängd data utan att ha många utmaningar Låt oss ta ett exempel på Facebook - miljontals människor ansluter, delar tankar, kommentarer osv. Det kan hantera programvara och maskinvarufel smidigt.

- Om ett system misslyckas kommer data inte att gå förlorade eller ingen förlust av information eftersom replikationsfaktorn är 3, data kopieras 3 gånger och Hadoop flyttar data från ett system till ett annat. Den kan hantera olika typer av data som strukturerade, ostrukturerade eller semistrukturerade.

- Strukturera data som en tabell (vi kan enkelt hämta rader eller kolumner), ostrukturerade data som videor och foton och semistrukturerade data som en kombination av strukturerad och semistrukturerad.

- Kostnaden för att implementera Hadoop med bigdata-projektet är låg eftersom företag köper lagrings- och bearbetningstjänster från leverantörer av molntjänster eftersom kostnaden för lagring per byte är låg.

- Det ger flexibilitet och genererar värde från data som strukturerat och ostrukturerat. Vi kan hämta värdefull information från datakällor som sociala medier, underhållningskanaler, shoppingwebbplatser.

- Hadoop kan bearbeta data med CSV-filer, XML-filer etc. Data behandlas parallellt i distributionsmiljön, vi kan kartlägga data när de finns i klustret. Server och data är belägna på samma plats så att behandlingen av data går snabbare.

- Om vi har en enorm uppsättning ostrukturerade data, kan vi fortsätta terabyte data inom en minut. Utvecklare kan koda för Hadoop med hjälp av olika programmeringsspråk som python, C, C ++. Det är en öppen källkodsteknik. Källkod är lätt tillgänglig online. Om data ökar dag för dag kan vi lägga till noder i klustret. Vi behöver inte lägga till fler kluster. Varje nod utför sitt jobb med sina egna resurser.

Slutsats

Hadoop kan utföra stora databeräkningar. För att bearbeta detta har Google utvecklat en Map-Reduce-algoritm, Hadoop kommer att köra algoritmen. Detta kommer att spela en viktig roll i statistisk analys, business intelligence och ETL-behandling. Lätt att använda och billigare tillgängligt. Den kan hantera tera-byte av data, analysera den och ge värde från data utan några svårigheter utan förlust av information.

Rekommenderade artiklar

Detta är en guide till Vad är Hadoop ?. Här diskuterar vi tillämpningen av Hadoop och funktioner tillsammans med fördelarna. Du kan också gå igenom våra andra artiklar som föreslås för att lära dig mer–

- Clustering Methods

- IoT-programvara

- Hadoop FS-kommandolista

- Fördelar med Hadoop

- Hur fungerar kommentarer i PHP?