Introduktion till beslutsträd i maskinlärande

Decision Tree in Machine Learning har fått ett brett fält i den moderna världen. Det finns många algoritmer i ML som används i vårt dagliga liv. En av de viktiga algoritmerna är Decision Tree som används för klassificering och även en lösning för regressionsproblem. Eftersom det är en prediktiv modell görs beslutsträdanalys via algoritmisk strategi där en datamängd delas upp i delmängder enligt villkor. Själva namnet säger att det är en trädliknande modell i form av om-då-annars uttalanden. Ju djupare är trädet och fler är noderna, desto bättre är modellen.

Typer av beslutsträd i maskininlärning

Decision Tree är ett trädliknande diagram där sorteringen startar från rotnoden till bladnoden tills målet uppnås. Det är den mest populära för beslut och klassificering baserad på övervakade algoritmer. Det är konstruerat genom rekursiv partitionering där varje nod fungerar som ett testfall för vissa attribut och varje kant, härledd från noden, är ett möjligt svar i testfallet. Både rot- och bladnoderna är två enheter i algoritmen.

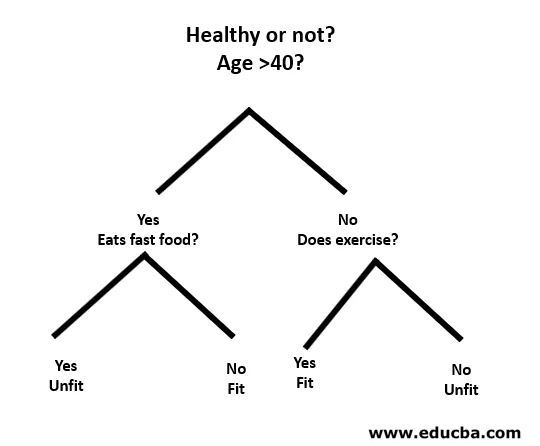

Låt oss förstå med hjälp av ett litet exempel på följande sätt:

Här är rotnoden oavsett om du är färre än 40 eller inte. Om så är fallet, äter du snabbmat? Om ja, så är du otyg, annars är du i form. Och om du är mer än 40, gör du träning? Om så är fallet, så är du i form, annars är du olämplig. Detta var i princip en binär klassificering.

Det finns två typer av beslutsträd:

- Klassificeringsträd: Exemplet ovan är ett kategoriskt baserat klassificeringsträd.

- Regressionsträd : I denna typ av algoritm är beslutet eller resultatet kontinuerligt. Den har en enda numerisk utgång med fler ingångar eller prediktorer.

I beslutsträdet är den typiska utmaningen att identifiera attributet vid varje nod. Processen kallas attributval och har några åtgärder att använda för att identifiera attributet.

a. Information Gain (IG)

Information Gain mäter hur mycket information en individuell funktion ger om klassen. Det fungerar som huvudnyckeln för att konstruera ett beslutsträd. Ett attribut med den högsta informationsförstärkningen delas först. Så beslutsträdet maximerar alltid informationsvinsterna. När vi använder en nod för att dela upp instansen i mindre delmängder, förändras entropin.

Entropi: Det är måttet på osäkerhet eller orenhet i en slumpmässig variabel. Entropy bestämmer hur ett beslutsträd delar upp data i delmängder.

Ekvationen för informationsförstärkning och entropi är följande:

Informationsvinster = entropi (förälder) - (viktat genomsnitt * entropi (barn))

Entropi: ∑p (X) log p (X)

P (X) här är fraktionen av exempel i en given klass.

b. Gini-index

Gini-index är ett värde som avgör hur ofta ett slumpmässigt valt element skulle identifieras felaktigt. Det står tydligt att attribut med ett lågt Gini-index ges första företräde.

Gini-index: 1-∑ p (X) 2

Dela skapandet

- För att skapa en split måste vi först beräkna Gini-poängen.

- Data delas med hjälp av en lista med rader med ett index för ett attribut och ett delat värde för attributet. När det högra och vänstra datasætet hittas kan vi få delad värde med Gini-poängen från den första delen. Nu är det delade värdet avgöraren där attributet kommer att ligga.

- Nästa del är att utvärdera alla delningar. Bäst möjliga värde beräknas genom att utvärdera kostnaden för splittringen. Den bästa delningen används som en nod i beslutsträdet.

Bygga ett träd - beslutsträd i maskinlärande

Det finns två steg för att bygga ett beslutsträd.

1. Skapa terminalnod

När vi skapar terminalnoden är det viktigaste att notera om vi behöver sluta växa träd eller gå vidare. Följande sätt kan användas för detta:

- Maximalt träddjup: När trädet når det maximala antalet noder stoppas exekveringen där.

- Minsta nodposter: Det kan definieras som ett minimum av mönster som en nod kräver. Då kan vi sluta lägga till terminalnoder omedelbart så får vi dessa minimikoderposter.

2. Rekursiv delning

En gång skapas noden, vi kan skapa en barnnod rekursivt genom att dela upp datauppsättningen och ringa samma funktion flera gånger.

Förutsägelse

När ett träd har byggts görs förutsägelsen med en rekursiv funktion. Samma förutsägelsesprocess följs igen med vänster eller höger barnnoder och så vidare.

Fördelar och nackdelar med beslutsträdet

Nedan ges några fördelar och nackdelar:

fördelar

Beslutsträdet har några fördelar med maskininlärning enligt följande:

- Omfattande: Det tar hänsyn till varje möjligt resultat av ett beslut och spårar varje nod till slutsatsen i enlighet därmed.

- Specifikt: Beslutsträd tilldelar ett specifikt värde till varje problem, beslut och resultat. Det minskar osäkerheten och tvetydigheten och ökar också tydligheten.

- Enkelhet: Decision Tree är en av de enklare och pålitliga algoritmerna eftersom det inte har några komplexa formler eller datastrukturer. Endast enkel statistik och matematik krävs för beräkning.

- Mångsidig: Beslutsträd kan manuellt konstrueras med matematik och användas tillsammans med andra datorprogram.

nackdelar

Beslutsträdet har några nackdelar med maskininlärning enligt följande:

- Beslutsträd är mindre lämpliga för uppskattning och ekonomiska uppgifter där vi behöver ett lämpligt värde.

- Det är en felutsatt klassificeringsalgoritm jämfört med andra beräkningsalgoritmer.

- Det är beräkningsvärt dyrt. Vid varje nod måste kandidatdelningen sorteras innan den bedöms bäst. Det finns andra alternativ som många affärsenheter följer för ekonomiska uppgifter eftersom beslutsträdet är för dyrt för utvärdering.

- Samtidigt som man arbetar med kontinuerliga variabler, är beslutsträdet inte lämpligt som den bästa lösningen eftersom det tenderar att förlora information när man kategoriserar variabler.

- Det är ibland instabilt eftersom små variationer i datauppsättningen kan leda till bildandet av ett nytt träd.

Slutsats - Beslutsträd i maskininlärning

Som en av de viktigaste och övervakade algoritmerna spelar Decision Tree en viktig roll i beslutsanalysen i verkligheten. Som en prediktiv modell används den inom många områden för sin delade strategi som hjälper till att identifiera lösningar baserade på olika förhållanden med antingen klassificering eller regressionsmetod.

Rekommenderade artiklar

Detta är en guide till Decision Tree in Machine Learning. Här diskuterar vi introduktionen, typer av beslutsträd i maskininlärning, delning av skapande och byggande av ett träd. Du kan också gå igenom våra andra artiklar som föreslås för att lära dig mer–

- Python-datatyper

- Tableau-datauppsättningar

- Cassandra Data Modeling

- Testtabell för beslut

- Topp 8 stadier av maskinlärande livscykel