Vad är Big Data Technology?

Som vi vet utvecklas data ständigt. Tillväxten av data har utmanat mänskliga sinnen att extrahera, analysera och hantera det. Detta beror på att traditionella sätt att hantera data inte stöder denna big data. Big data beskrivs av vanligtvis tre begrepp: volym, variation och hastighet.

Data har nu blivit varje företags viktigaste tillgång. Genom att analysera denna big data hjälper företaget att analysera sina kunders beteende och förutsäga relevanta saker som är förknippade med de datadrivna besluten gör organisationen, ta mer säkra drag och bygga starkare strategier.

Genom att veta i vilken takt data ökar i dagens tid kommer big data att vara ett gigantiskt fält inom en snar framtid att arbeta för. Alla studenter, nybörjare, proffs kommer att behövas för att hålla sig uppdaterade med den nya big data-teknologin. Att hålla sig uppdaterad kommer att leda till en stor och framgångsrik karriär inom sin professionella väg.

Big Data Technologies

Här listar jag några stora datateknologier med en klar förklaring till det, för att göra dig medveten om de kommande trenderna och tekniken:

-

Apache Spark:

Det är en snabb motor för databehandling. Detta är byggt med tanke på realtidsbehandlingen för data. Dess rika bibliotek med maskininlärning är bra att arbeta på AI och ML. Den bearbetar data parallellt och på grupperade datorer. Den grundläggande datatyp som används av Spark är RDD (elastisk distribuerad datamängd).

-

NoSQL-databaser:

Det är icke-relationella databaser som ger snabb lagring och hämtning av data. Dess förmåga att hantera alla typer av data som strukturerade, semistrukturerade, ostrukturerade och polymorfa data gör är unik. Inga SQL-databaser är av följande typer:

- Dokumentdatabaser : Den lagrar data i form av dokument som kan innehålla många olika nyckelvärdespar.

- Graflagrar : Det lagrar data som vanligtvis lagras i form av nätverket, t.ex. sociala mediedata.

- Nyckelvärden : Dessa är de enklaste NoSQL-databaserna. Varje objekt i databasen lagras som ett attributnamn (eller 'nyckel') tillsammans med dess värde.

- Bred kolumnlagrar : Denna databas lagrar data i kolumnformatet snarare än radbaserat format. Cassandra och HBase är bra exempel på det.

-

Apache Kafka:

Kafka är en distribuerad händelseströmningsplattform som hanterar många evenemang varje dag. Eftersom det är snabbt och skalbart kan detta hjälpa till att skapa realtidsströmningsdata-rörledningar som tillförlitligt hämtar data mellan system eller applikationer.

-

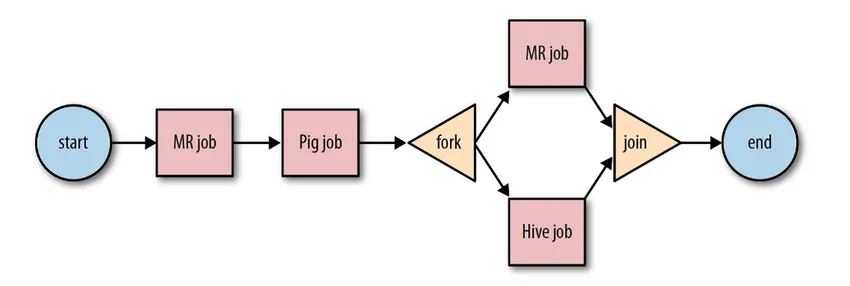

Apache Oozie:

Det är ett arbetsflödesplaneringssystem för att hantera Hadoop-jobb. Dessa arbetsflödesjobb är schemalagda i form av Directed Acyclical Graphs (DAGs) för åtgärder.

Källa: Google

Dess skalbara och organiserade lösning för big data-aktiviteter.

-

Apache-luftflöde:

Detta är en plattform som planerar och övervakar arbetsflödet. Smart schemaläggning hjälper till att organisera slutförandet av projektet effektivt. Luftflödet har förmågan att återköra en DAG-instans när det finns ett fall av fel. Det rika användargränssnittet gör det enkelt att visualisera rörledningar som körs i olika stadier gillar produktion, övervaka framsteg och felsöka problem vid behov.

-

Apache Beam:

Det är en enhetlig modell för att definiera och genomföra databehandlingsrörledningar som inkluderar ETL och kontinuerlig strömning. Apache Beam-ramverket ger en abstraktion mellan din applikationslogik och big data-ekosystem, eftersom det inte finns något API som binder alla ramverk som Hadoop, gnista, etc.

-

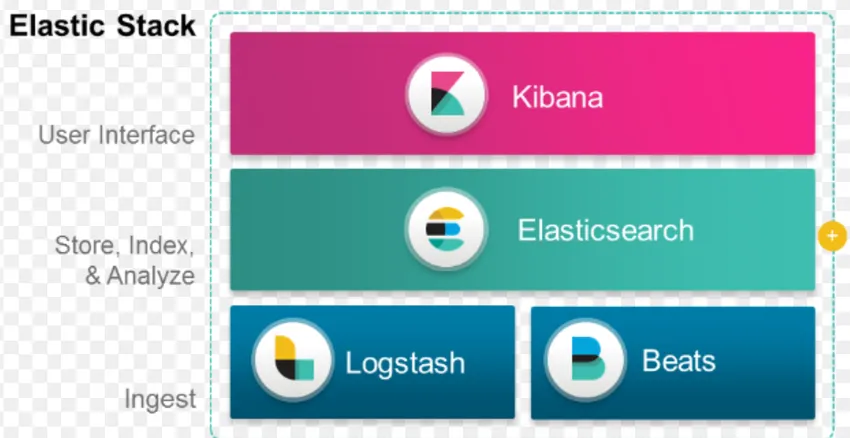

ELK Stack:

ELK är känd för Elasticsearch, Logstash och Kibana.

Elasticsearch är en schemalös databas (som indexerar varje fält) som har kraftfulla sökfunktioner och lätt skalbar.

Logstash är ett ETL-verktyg som gör att vi kan hämta, omvandla och lagra händelser i Elasticsearch.

Kibana är ett instrument för instrumentpaneler för Elasticsearch, där du kan analysera all lagrad data. De handlingsbara insikter som härrör från Kibana hjälper till att bygga strategier för en organisation. Från att fånga förändringar till förutsägelse har Kibana alltid visat sig vara mycket användbart.

-

Docker & Kubernete:

Det här är den nya tekniken som hjälper applikationer att köra i Linux-containrar. Docker är en öppen källkodssamling av verktyg som hjälper dig att "bygga, skicka och köra valfri app, var som helst".

Kubernetes är också en open source container / orchestration plattform, vilket gör att ett stort antal containrar kan arbeta tillsammans i harmoni. Detta minskar slutligen den operativa bördan.

-

TensorFlow:

Det är ett öppen källkodsmaskinbibliotek som används för att designa, bygga och utbilda modeller för djup inlärning. Alla beräkningar görs i TensorFlow med dataflödesdiagram. Grafer omfattar noder och kanter. Noder representerar matematiska operationer, medan kanterna representerar data.

TensorFlow är användbart för forskning och produktion. Det har byggts med tanke på att det kan köras på flera processorer eller GPU och till och med mobila operativsystem. Detta kan implementeras i Python, C ++, R och Java.

-

Presto:

Presto är en open source SQL-motor utvecklad av Facebook, som kan hantera petabytar med data. Till skillnad från Hive är Presto inte beroende av MapReduce-tekniken och därmed snabbare i att hämta data. Dess arkitektur och gränssnitt är tillräckligt enkla för att interagera med andra filsystem.

På grund av låg latens och enkel interaktiv fråga blir det mycket populärt för närvarande för att hantera big data.

-

Polybase:

Polybase fungerar ovanpå SQL Server för att få åtkomst till data från lagrad i PDW (Parallel Data Warehouse). PDW byggd för att behandla alla volymer av relationsdata och ger integration med Hadoop.

-

Bikupa:

Hive är en plattform som används för datafråga och dataanalys över stora datamängder. Det tillhandahåller ett SQL-liknande frågespråk som heter HiveQL, som internt konverteras till MapReduce och sedan behandlas.

Med den snabba tillväxten av data och organisationens enorma strävan efter att analysera big data Tekniken har tagit in så många mogna tekniker på marknaden att det är en stor fördel att känna till dem. I dag hanterar Big data Technology många affärsbehov och problem genom att öka effektiviteten och förutsäga det relevanta beteendet. En karriär inom big data och dess relaterade teknik kan öppna många dörrar till möjligheter för såväl personen som för företag.

Hittills är det hög tid att anta big data-teknologier.

Rekommenderade artiklar

Detta har varit en guide till Vad är Big Data Technology. Här har vi diskuterat några stora datateknologier som Hive, Apache Kafka, Apache Beam, ELK Stack, etc. Du kan också titta på följande artikel för att lära dig mer -

- Vad är djupt lärande?

- Guide till Minitab?

- Vad är Salesforce-teknik?

- Vad är Big data analytics?