Översikt över Install Hadoop

Följande artikel, Install Hadoop, innehåller en översikt över de vanligaste Hadoop-ramnyckelmodulerna och stegvis installation för Hadoop. Apache Hadoop är en samling programvara som möjliggör behandling av stora datasätt och distribuerad lagring över ett kluster av olika typer av datorsystem. För närvarande förblir Hadoop den mest använda analysplattformen för big data ("Sanchita Lobo, författare på Analytics Training Blog", nd).

Hadoop Framework

Apache Hadoop-ramverket består av följande nyckelmoduler.

- Apache Hadoop Common.

- Apache Hadoop Distribuerat filsystem (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (ännu en resurschef).

Apache Hadoop Common

Apache Hadoop Common-modulen består av delade bibliotek som konsumeras över alla andra moduler inklusive nyckelhantering, generiska I / O-paket, bibliotek för metrisk insamling och verktyg för register, säkerhet och strömning.

HDFS

HDFS är baserat på Googles filsystem och är strukturerat för att köras på lågkostnadshårdvara. HDFS är tolerant mot fel och är utformad för applikationer med stora datasätt.

MapReduce

MapReduce är en inneboende parallell programmeringsmodell för databehandling och Hadoop kan köra MapReduce-program skrivna på olika språk som Java. MapReduce fungerar genom att dela upp behandlingen i kartfasen och minska fasen.

Apache Hadoop YARN

Apache Hadoop YARN är en kärnkomponent och är resurshanterings- och jobbschemaläggningsteknik i Hadoops distribuerade behandlingsram.

I den här artikeln kommer vi att diskutera installationen och konfigurationen av Hadoop 2.7.4 på ett enda nodkluster och testa konfigurationen genom att köra MapReduce-programmet som heter wordcount för att räkna antalet ord i filen. Vi kommer vidare att titta på några viktiga Hadoop File System-kommandon.

Steg för att installera Hadoop

Följande är en sammanfattning av de uppgifter som är involverade i konfigurationen av Apache Hadoop.

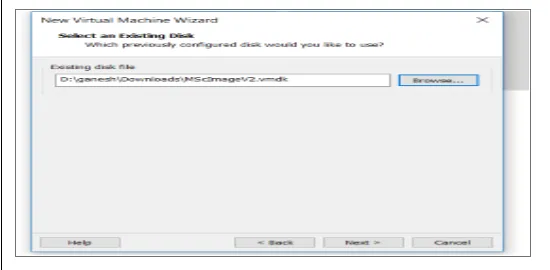

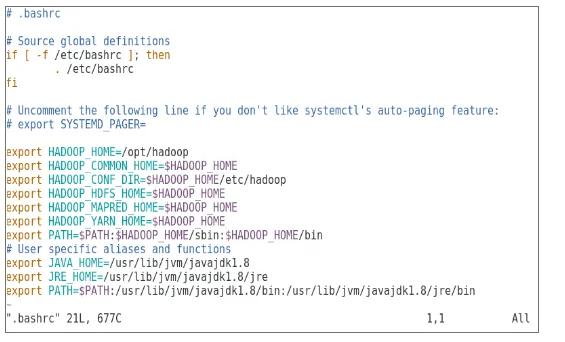

Uppgift 1: Den första uppgiften i Hadoop-installationen inkluderade att installera en virtuell maskinmall som konfigurerades med Cent OS7. Paket som Java SDK 1.8 och Runtime Systems som krävs för att köra Hadoop laddades ner och Java-miljövariabeln för Hadoop konfigurerades genom redigering av bash_rc.

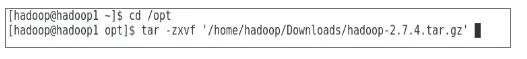

Uppgift 2: paketet Hadoop Release 2.7.4 laddades ner från apache-webbplatsen och extraherades i optmappen. Som sedan döptes till Hadoop för enkel åtkomst.

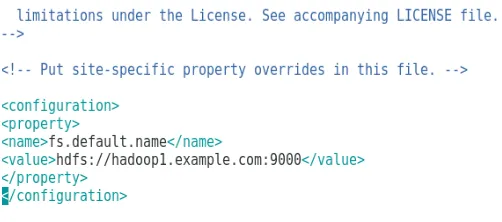

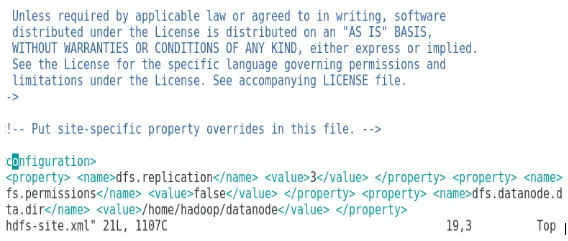

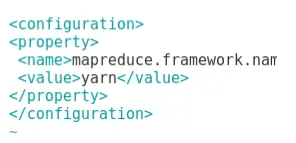

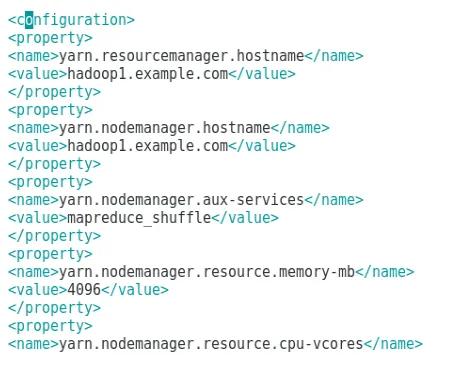

Uppgift 3: När Hadoop-paketen hade extraherats inkluderade nästa steg konfigurering av miljövariabeln för Hadoop-användare följt av konfigurering av Hadoop-nod XML-filer. I detta steg konfigurerades NameNode inom core-site.xml och DataNode konfigurerades inom hdfs-site.xml. Resurshanteraren och nodhanteraren konfigurerades inom yarn-site.xml.

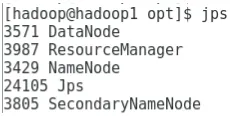

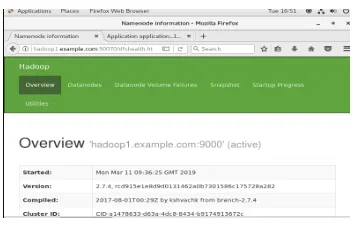

Uppgift 4: Brandväggen inaktiverades för att starta YARN och DFS. JPS-kommando användes för att verifiera om relevanta demoner körs i bakgrunden. Portnumret för åtkomst till Hadoop konfigurerades till http: // localhost: 50070 /

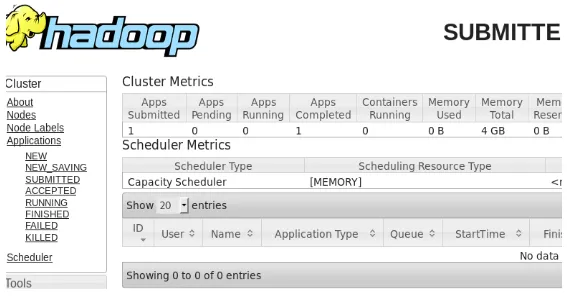

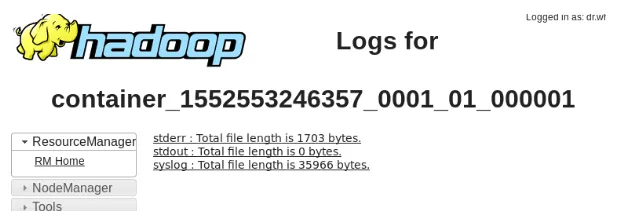

Uppgift 5: De följande stegen användes för att verifiera och testa Hadoop. För detta har vi skapat en tillfällig testfil i inmatningskatalogen för WordCount-programmet. Kartdämpande program Hadoop-MapReduce-exempel2.7.4.jar användes för att räkna antalet ord i filen. Resultaten utvärderades på localhost och loggar för den inlämnade ansökan analyserades. Alla MapReduce-ansökningar som skickas in kan ses på online-gränssnittet, standardportnummer är 8088.

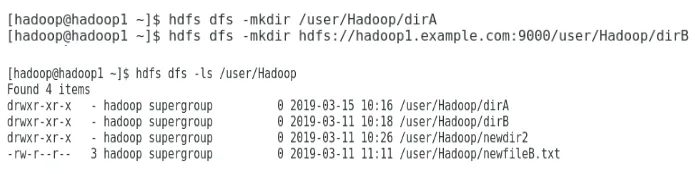

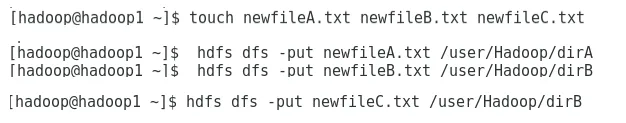

Uppgift 6: I den slutliga uppgiften introducerar vi några grundläggande Hadoop File System-kommandon och kontrollerar deras användning. Vi kommer att se hur en katalog kan skapas i Hadoop-filsystemet, för att lista innehållet i en katalog, dess storlek i byte. Vi kommer vidare att se hur man tar bort en specifik katalog och fil.

Resultat i Hadoop Installation

Följande visar resultaten av var och en av ovanstående uppgifter:

Resultat av uppgift 1

En ny virtuell maskin med en cenOS7-bild har konfigurerats för att köra Apache Hadoop. Figur 1 visar hur CenOS 7-bilden konfigurerades i den virtuella maskinen. Figur 1.2 visar JAVA-miljövariabelkonfigurationen inom .bash_rc.

Bild 1: Konfiguration av virtuell maskin

Bild 1.2: Java-miljövariabelkonfiguration

Resultat av uppgift 2

Figur 2 visar uppgiften som utförs för att extrahera Hadoop 2.7.4-paketet för att välja mapp.

Bild 2: Extraktion av Hadoop 2.7.4-paketet

Resultat av uppgift 3

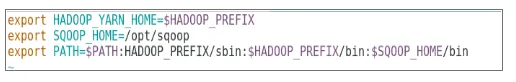

Figur 3 visar konfigurationen för miljövariabeln för Hadoop-användare, figur 3.1 till 3.4 visar konfigurationen för XML-filer som krävs för Hadoop-konfiguration.

Bild 3: Konfigurera miljövariabeln för Hadoop-användare

Bild 3.1: Konfiguration av core-site.xml

Bild 3.2: Konfiguration av hdfs-site.xml

Bild 3.3: Konfiguration av mapred-site.xml-fil

Bild 3.4: Konfiguration av filen garn-site.xml

Resultat av uppgift 4

Figur 4 visar användningen av jps-kommandot för att kontrollera att relevanta demoner körs i bakgrunden och följande figur visar Hadoops användargränssnitt online.

Figur 4: jps-kommando för att verifiera körda demoner.

Bild 4.1: Få åtkomst till Hadoop online-gränssnitt i hamn http://hadoop1.example.com:50070/

Resultat av uppgift 5

Figur 5 visar resultatet för MapReduce-programmet som heter wordcount som räknar antalet ord i filen. Nästa par siffror visar YARN-resurschefens online användargränssnitt för den skickade uppgiften.

Bild 5: MapReduce programresultat

Bild 5.1: Inlämnad applikation för kartminskning.

Bild 5.2: Loggar för inlämnad MapReduce-ansökan.

Resultat av uppgift 6

Figur 6 visar hur man skapar en katalog i Hadoop-filsystemet och utför en lista med hdfs-katalogen.

Bild 6: Skapa en katalog i Hadoop-filsystemet

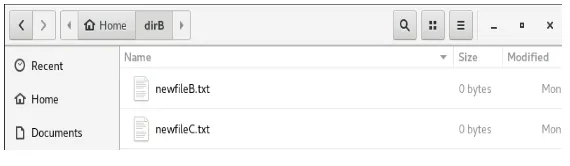

Figur 6.1 visar hur man lägger en fil till Hadoop distribuerade filsystem och figur 6.2 visar den skapade filen i dirB-katalogen.

Bild 6.1: Skapa en fil i HDFS.

Bild 6.2: Ny fil skapad.

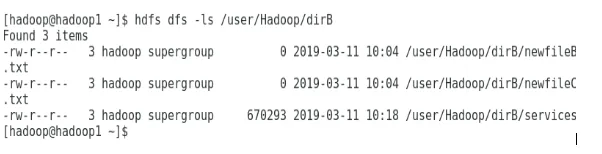

De följande siffrorna visar hur man listar innehållet i vissa kataloger:

Bild 6.3: Innehåll i dirA

Bild 6.4: Innehåll i dirB

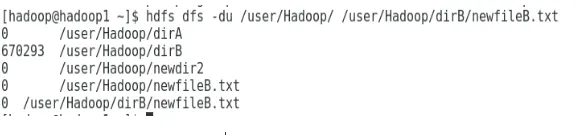

Nästa figur visar hur fil- och katalogstorlek kan visas:

Bild 6.5: Visa en fil- och katalogstorlek.

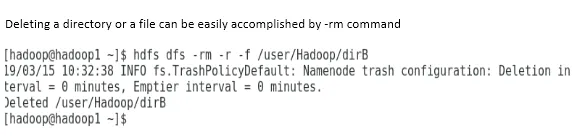

Att ta bort en katalog eller en fil kan enkelt utföras med -rm-kommandot.

Bild 6.6: Ta bort en fil.

Slutsats

Big Data har spelat en mycket viktig roll i utformningen av dagens världsmarknad. Hadoop-ramverket gör dataanalytiker lätt under arbetet med stora datasätt. Konfigurationen av Apache Hadoop var ganska enkel och online-användargränssnittet gav användaren flera alternativ för att ställa in och hantera applikationen. Hadoop har använts massivt i organisationer för datalagring, maskininlärningsanalys och säkerhetskopiering av data. Att hantera en stor mängd data har varit ganska praktiskt på grund av Hadoop distribuerad miljö och MapReduce. Hadoop-utvecklingen var ganska fantastisk jämfört med relationsdatabaser eftersom de saknar inställnings- och prestationsalternativ. Apache Hadoop är en användarvänlig och låg kostnadslösning för att hantera och lagra stora data effektivt. HDFS går också långt med att lagra data.

Rekommenderade artiklar

Detta är en guide för att installera Hadoop. Här diskuterar vi introduktionen till Instal Hadoop, steg för steg installation av Hadoop tillsammans med resultaten från Hadoop Installation. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Introduktion till Hadoop Streaming

- Vad är Hadoop Cluster och hur fungerar det?

- Apache Hadoop Ecosystem och dess komponenter

- Vad är Hadoop-alternativen?