Introduktion till Hadoop Framework

Innan vi djupt dyker in i det tekniska ramverket för Hadoop kommer vi att börja med ett enkelt exempel.

Det finns en gård som skördar tomater och lagrar dem i ett enda lagerområde, nu med den ökande efterfrågan på grönsaker började gården skörda potatis, morötter - med ökande efterfrågan var det en brist på jordbrukare så de anställde fler bönder. Efter en tid insåg de att det var brist i lagringsområdet - så de fördelade grönsakerna i olika lagringsområden. När det gäller att hämta informationen fungerar alla parallellt med sitt eget lagringsutrymme.

Så hur den här historien är relaterad till big data?

Tidigare hade vi begränsade data, med den begränsade processorn och en lagringsenhet. Men sedan ökade genereringen av data vilket ledde till hög volym och olika sorter - strukturerad, halvstrukturerad och ostrukturerad. Så lösningen var att använda distribuerad lagring för varje processor, vilket möjliggjorde enkel åtkomst till lagring och åtkomstdata.

Så nu kan vi ersätta grönsakerna som olika typer av data och lagringsplats som de distribuerade platserna för att lagra informationen och olika arbetare som är varje processor.

Så Big data är utmaningen och Hadoop spelar rollen i lösningen.

Hadoop

1. Lösning för STORA DATA: eftersom det handlar om komplexiteter av hög volym, hastighet och olika data.

2. Uppsättning av öppen källkodsprojekt.

3. Lagrar en enorm datamängd pålitligt och tillåter enorma distribuerade beräkningar.

4. Hadoops huvudattribut är redundans och tillförlitlighet (absolut ingen dataförlust).

5. Fokuserar främst på batchbehandling.

6. Kör på varuhårdvara - du behöver inte köpa någon speciell dyr maskinvara.

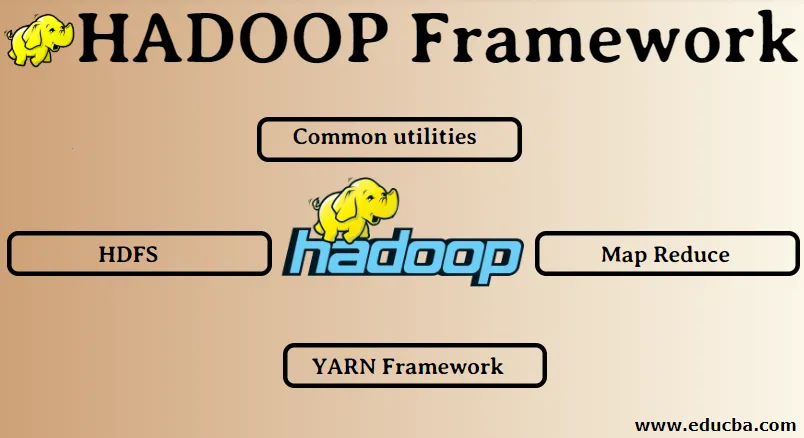

Hadoop Framework:

1. Gemensamma verktyg

2. HDFS

3. Kartminska

4. YARN-ramverk

1. Vanliga verktyg:

Kallas också Hadoop-vanliga. Det här är ingenting annat än JAVA-bibliotek, filer, skript och verktyg som faktiskt krävs av de andra Hadoop-komponenterna för att utföra.

2. HDFS: Hadoop Distribuerat filsystem

Varför Hadoop har valt att integrera ett distribuerat filsystem?

Låt oss förstå detta med ett exempel: Vi måste läsa 1 TB data och vi har en maskin med 4 I / O-kanaler varje kanal med 100 MB / s, det tog 45 minuter att läsa hela data. Nu läses samma mängd data av 10 maskiner vardera med 4 I / O-kanaler varje kanal som har 100 MB / s. Gissa hur lång tid det tog att läsa informationen? 4, 3 minuter. HDFS löser problemet med att lagra big data. De två huvudkomponenterna i HDFS är NAME NODE och DATA NODE. Namnnoden är befälhavaren, vi kan ha en sekundär namnnod också om primärnamnoden slutar fungera kommer den sekundära namnnoden att fungera som en säkerhetskopia. Namnnoden upprätthåller och hanterar i princip datanoder genom att lagra metadata. Datanoden är slaven som i princip är den låga kostnadshårdvaran. Vi kan ha flera datanoder. Datanoden lagrar faktiska data. Den här datanoden stöder replikeringsfaktorn, antag att om en datanod går ner kan informationen nås av den andra replikerade datanoden, därför förbättras datatillgängligheten och förlust av data.

3. Kartminskning:

Det löser problemet med att behandla big data. Låt oss förstå begreppet kartminskningar genom att lösa detta verkliga problem. ABC-företaget vill beräkna sin totala försäljning, stadsmässigt. Nu här fungerar hash-tabellkonceptet inte eftersom uppgifterna finns i terabyte, så vi kommer att använda Map-Reduce-konceptet.

Det finns två faser: a) MAP. b) MINSKA

a) Karta : Först kommer vi att dela upp data i mindre bitar som kallas mapparna på grundval av nyckel- / värdeparet. Så här kommer nyckeln att vara stadens namn och värdet är total försäljning. Varje mapper får varje månads data som ger ett stadnamn och motsvarande försäljning.

b) Minska: Det kommer att få dessa högar med data och varje reducerande ansvarar för Nord / Väst / Öst / Sydstäder. Så arbetet i reduceraren kommer att samla dessa små bitar och konvertera till större mängder (genom att lägga till dem) för en viss stad.

4.YARN-ramverk: ännu en resurförhandlare.

Den ursprungliga versionen av Hadoop hade bara två komponenter: Map Reduce och HDFS. Senare insåg man att Map Reduce inte kunde lösa många stora dataproblem. Tanken var att ta resurshanterings- och jobbplaneringsansvaret bort från den gamla kartminskningsmotorn och ge den till en ny komponent. Så det här är hur YARN kom in i bilden. Det är mittlagret mellan HDFS och Map Reduce som ansvarar för att hantera klusterresurser.

Det har två viktiga roller att utföra: a) Jobbplanering. b) Resurshantering

a) Jobbschemaläggning: När en stor mängd data ges för bearbetning måste den distribueras och delas upp i olika uppgifter / jobb. Nu beslutar JS vilket jobb som ska prioriteras högst, tidsintervallet mellan två jobb, beroende mellan jobb, kontrollerar att det inte finns någon överlappning mellan de jobb som körs.

b) Resurshantering: För bearbetning av data och för lagring av data behöver vi resurser rätt? Så resurschefen tillhandahåller, hanterar och underhåller resurserna för att lagra och bearbeta data.

Så nu är vi tydliga med begreppet Hadoop och hur det löser de utmaningar som skapas av STORA DATA !!!

Rekommenderade artiklar

Detta har varit en guide till Hadoop Framework. Här har vi också diskuterat de 4 främsta Hadoop-ramarna. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Hadoop-databas

- Hadoop ekosystem

- Användningar av Hadoop

- Hadoop Administratör Jobb

- Hadoop Administrator | Färdigheter och karriärväg