Introduktion till Begränsad Boltzmann-maskin

Begränsad Boltzmann-maskin är en metod som automatiskt kan hitta mönster i data genom att rekonstruera vår input. Geoff Hinton är grundaren av djup inlärning. RBM är ett ytligt tvåskiktsnätverk där det första är det synliga och det nästa är det dolda lagret. Varje enskild nod i det synliga lagret kopplas till varje enskild nod i det dolda lagret. Begränsad Boltzmann-maskin anses vara begränsad eftersom två noder i samma lager inte bildar en anslutning. En RBM är den numeriska ekvivalenten för tvåvägsöversättare. På framvägen tar emot en RBM ingången och konverterar den till en uppsättning nummer som kodar ingången. I den bakåtgående vägen tar det detta som ett resultat och bearbetar denna uppsättning ingångar och översätter dem i omvänd riktning för att bilda de återstående ingångarna. Ett supertränat nätverk kommer att kunna utföra denna omvända övergång med hög sannhet. I två steg har vikt och värden en mycket viktig roll. De tillåter RBM att avkoda interrelationer mellan ingångarna och hjälper också RBM att avgöra vilka ingångsvärden som är viktigast för att upptäcka korrekta utgångar.

Arbetar med begränsad Boltzmann-maskin

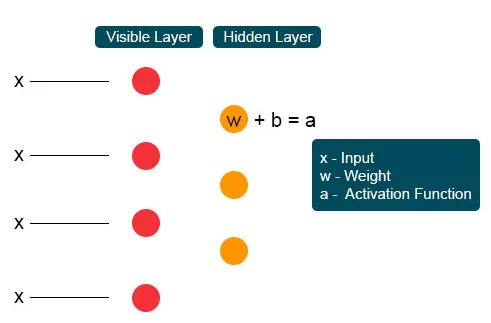

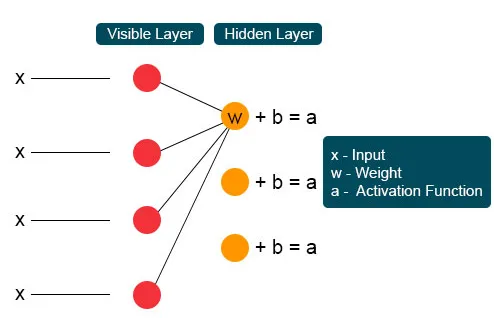

Varje synlig nod får ett lågnivåvärde från en nod i datasatsen. Vid den första noden i det osynliga skiktet bildas X av en produkt av vikt och tillsätts till en förspänning. Resultatet av denna process matas till aktivering som producerar kraften hos den givna insignalen eller nodens utgång.

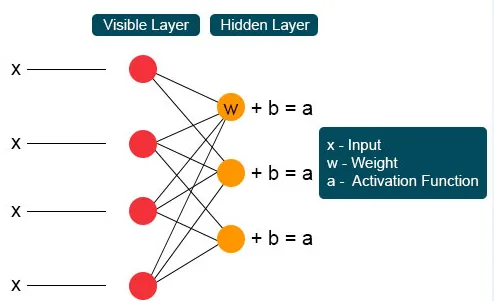

I nästa process skulle flera ingångar gå samman vid en enda dold nod. Varje X kombineras av den individuella vikten, tillsatsen av produkten är förankrad i värden och återigen passeras resultatet genom aktivering för att ge nodens utgång. Vid varje osynlig nod kombineras varje ingång X med individuell vikt W. Ingång X har tre vikter här, vilket gör tolv tillsammans. Vikten som bildas mellan skiktet blir en matris där raderna är korrekta för att mata in noder och kolumner är nöjda med utgångsnoder.

Varje osynlig nod får fyra svar multiplicerad med sin vikt. Tillägget av denna effekt läggs åter till värdet. Detta fungerar som en katalysator för att någon aktiveringsprocess ska hända och resultatet matas igen till aktiveringsalgoritmen som producerar varje enskild utgång för varje osynlig ingång.

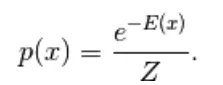

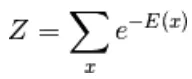

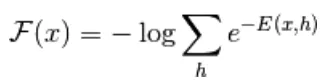

Den första modellen härledd är den energibaserade modellen. Denna modell kopplar skalenergi till varje konfiguration av variabeln. Denna modell definierar sannolikhetsfördelningen genom en energifunktion enligt följande,

(1)

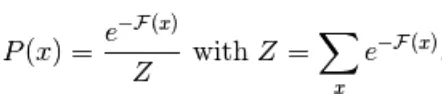

Här är Z den normaliserande faktorn. Det är partitionsfunktionen när det gäller fysiska system

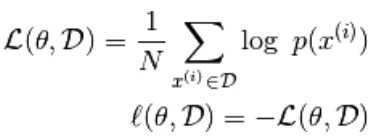

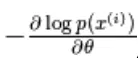

I denna energibaserade funktion följer en logistisk regression att det första steget definierar loggen. sannolikhet och den nästa kommer att definiera förlustfunktion som en negativ sannolikhet.

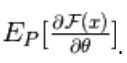

med hjälp av den stokastiska lutningen,  var

var  är parametrarna,

är parametrarna,

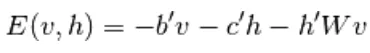

den energibaserade modellen med en dold enhet definieras som "h"

Den observerade delen benämns 'x'

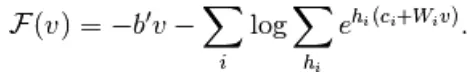

Från ekvation (1) definieras ekvationen av fri energi F (x) enligt följande

(2)

(3)

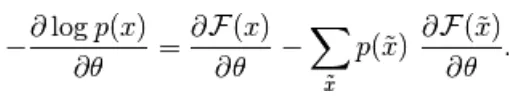

Den negativa lutningen har följande form,

(4)

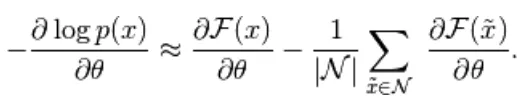

Ovanstående ekvation har två former, den positiva och negativa formen. Termen positiv och negativ representeras inte av tecken på ekvationerna. De visar effekten av sannolikhetsdensiteten. Den första delen visar sannolikheten för att minska motsvarande fri energi. Den andra delen visar reducerar sannolikheten för genererade prover. Därefter bestäms lutningen enligt följande,

(5)

Här är N negativa partiklar. I denna energibaserade modell är det svårt att identifiera gradienten analytiskt, eftersom den inkluderar beräkningen av

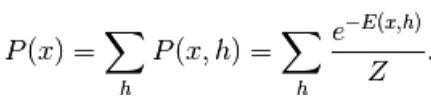

Därför har vi i denna EBM-modell linjär observation som inte kan beskriva uppgifterna noggrant. Så i nästa modell Restricted Boltzmann Machine är det dolda lagret mer att ha hög noggrannhet och förhindra dataförlust. RBM-energifunktionen definieras som,

(6)

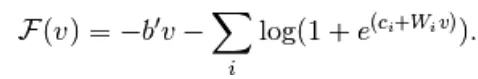

Här är W viktanslutning mellan synliga och dolda lager. b är förskjuten av det synliga lagret. c förskjuts av det dolda lagret. genom att konvertera till fri energi,

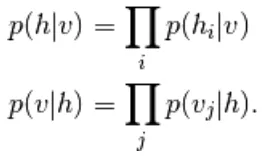

I RBM är enheterna för det synliga och dolda lagret helt oberoende vilket kan skrivas på följande sätt,

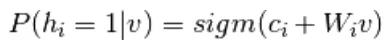

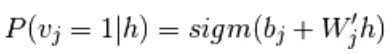

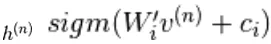

Från ekvation 6 och 2, en probabilistisk version av neuronaktiveringsfunktion,

(7)

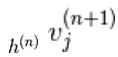

(8)

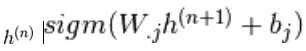

Det förenklas ytterligare till

(9)

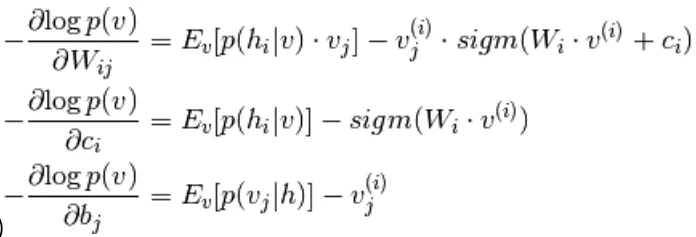

Kombination av ekvation 5 och 9,

(10)

Provtagning i Begränsad Boltzmann-maskin

Gibbs-sampling av ledet av N slumpmässiga variabler  görs genom en sekvens av N-samplingsunderstegen i formen

görs genom en sekvens av N-samplingsunderstegen i formen  var

var

innehåller  de andra slumpmässiga variablerna i

de andra slumpmässiga variablerna i  exklusive.

exklusive.

I RBM är S en uppsättning synliga och dolda enheter. De två delarna är oberoende som kan utföra eller blockera Gibbs-sampling. Här utför den synliga enheten sampling och ger fast värde till dolda enheter, samtidigt som dolda enheter tillhandahåller fasta värden till den synliga enheten genom sampling

här,  är uppsatt av alla dolda enheter.

är uppsatt av alla dolda enheter.  Ett exempel

Ett exempel  väljs slumpmässigt till 1 (mot 0) med sannolikhet,

väljs slumpmässigt till 1 (mot 0) med sannolikhet,  och på liknande sätt

och på liknande sätt  väljs slumpmässigt att vara 1 (mot 0) med sannolikhet

väljs slumpmässigt att vara 1 (mot 0) med sannolikhet

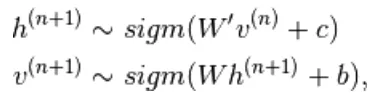

Kontrast avvikelse

Det används som katalysator för att påskynda provtagningsprocessen

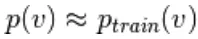

Eftersom vi förväntar oss att vara sanna, förväntar vi oss  fördelningsvärdet för att vara nära P så att det bildar en konvergens till den slutliga fördelningen av P

fördelningsvärdet för att vara nära P så att det bildar en konvergens till den slutliga fördelningen av P

Men kontrastiv avvikelse väntar inte på att kedjan ska konvergera. Prov erhålls först efter Gibbs process så vi ställer här k = 1 där det fungerar förvånansvärt bra.

Persistent kontrastiv divergens

Detta är en annan metod för tillnärmningsprövningsform. Det är ett ihållande tillstånd för varje provtagningsmetod det extraherar nya prover genom att helt enkelt ändra parametrarna för K.

Lager av begränsad Boltzmann-maskin

Begränsad Boltzmann-maskin har två lager, grunt neurala nätverk som kombineras för att bilda ett block av djupa tronätverk. Det första lagret är det synliga lagret och det andra lagret är det dolda lagret. Varje enhet hänvisar till en neuronliknande cirkel som kallas en nod. Noderna från det dolda lagret är anslutna till noder från det synliga lagret. Men två noder med samma lager är inte anslutna. Här hänvisar termen Begränsad till ingen intralaykommunikation. Varje nod bearbetar ingången och fattar det stokastiska beslutet om att sända ingången eller inte.

exempel

Den viktiga rollen för RBM är en sannolikhetsfördelning. Språk är unika i sina bokstäver och ljud. Brevens sannolikhetsfördelning kan vara hög eller låg. På engelska används bokstäverna T, E och A i stor utsträckning. Men på isländska är de vanliga bokstäverna A och N. vi kan inte försöka rekonstruera isländska med en vikt baserad på engelska. Det kommer att leda till divergens.

Nästa exempel är bilder. Sannolikfördelningen för deras pixelvärde skiljer sig åt varje bildsort. Vi kan överväga att det finns två bilder Elephant and Dog for tow input nodes, framåtpasset för RBM kommer att generera fråga som ska jag generera en stark pixelnod för elefantnod eller hundnod ?. Sedan kommer bakåtpassera att generera frågor som för elefant, hur ska jag förvänta mig en distribution av pixlar? Sedan med gemensam sannolikhet och aktivering som produceras av noder, kommer de att konstruera ett nätverk med gemensam förekomst som stora öron, grått icke-linjärt rör, floppy öron, rynkor är elefanten. Därför är RBM processen för djup inlärning och visualisering de bildar två huvudsakliga fördomar och verkar på deras aktiverings- och återuppbyggnadssans.

Fördelar med Begränsad Boltzmann-maskin

- Begränsad Boltzmann-maskin används algoritm som används för klassificering, regression, ämnesmodellering, samarbetsfiltrering och inlärning av funktioner.

- Begränsad Boltzmann-maskin används för neuroimaging, Sparse image rekonstruktion i gruvplanering och även för radarmåligenkänning

- RBM kan lösa obalanserad dataproblem med SMOTE-procedur

- RBM hittar saknade värden med Gibbs sampling som används för att täcka de okända värdena

- RBM övervinner problemet med bullriga etiketter genom okorrigerade etikettdata och dess rekonstruktionsfel

- Problemen med ostrukturerad data korrigeras av funktionsextraktorn som omvandlar rådata till dolda enheter.

Slutsats

Djupt lärande är mycket kraftfullt vilket är konsten att lösa komplexa problem, det är fortfarande ett rum för förbättringar och komplexa att genomföra. Gratis variabler måste konfigureras med omsorg. Idéerna bakom det neurala nätverket var svåra tidigare, men idag är djup inlärning foten av maskininlärning och konstgjord intelligens. Därför ger RBM en glimt av de enorma djupa inlärningsalgoritmerna. Det handlar om den grundläggande kompositionenheten som successivt växte till många populära arkitekturer och användes i många storskaliga industrier.

Rekommenderad artikel

Detta har varit en guide till den begränsade Boltzmann-maskinen. Här diskuterar vi dess bearbetning, sampling, fördelar och lager av begränsad Boltzmann-maskin. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer _

- Maskininlärningsalgoritmer

- Maskininlärningsarkitektur

- Typer av maskininlärning

- Maskininlärningsverktyg

- Implementering av nervnätverk