Introduktion till maskininlärningsmetoder

Följande artikel, Machine Learning Methods, ger en översikt över de mest använda metoderna för maskininlärning. Maskininlärning är en teknik som gör att en dator kan 'lära' saker på egen hand. Algoritmerna förbättrar adaptivt deras prestanda när de tillgängliga uppgifterna för lärande ökar. Det är mer data, desto mer exakt skulle vår modell vara.

Hur lär sig maskiner?

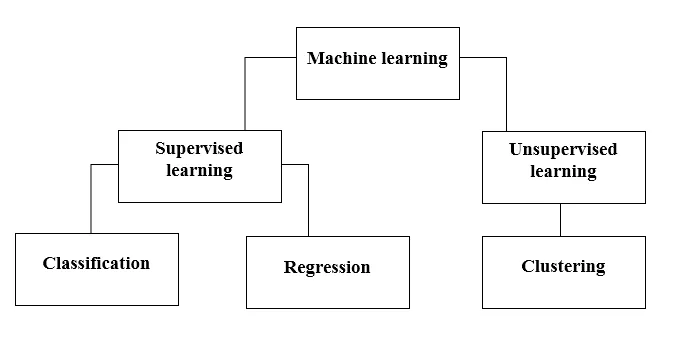

Det finns olika metoder för att göra det. Vilken metod som ska följas helt beror på problemet. Beroende på datasättet och vårt problem finns det två olika sätt att gå djupare. Den ena är övervakad inlärning och den andra är oövervakad inlärning. Följande diagram förklarar den ytterligare klassificeringen av maskininlärningsmetoder. Vi kommer att diskutera dem en efter en.

Ta en titt på följande diagram!

Låt oss förstå vad betyder Supervised Learning.

Övervakad inlärning

Som namnet antyder, föreställ dig en lärare eller en handledare som hjälper dig att lära dig. Detsamma gäller för maskiner. Vi tränar eller lär ut maskinen med hjälp av data som är märkta.

Några av de coolaste övervakade applikationerna är:

- Sentimentanalys (Twitter, Facebook, Netflix, YouTube, etc)

- Naturlig språkbehandling

- Bildklassificering

- Prediktiv analys

- Mönsterigenkänning

- Spamdetektering

- Tal / sekvensbehandling

Nu är övervakat lärande ytterligare indelat i klassificering och regression. Låt oss förstå detta.

Klassificering

Klassificering är processen för att hitta en modell som hjälper till att separera uppgifterna i olika kategoriska klasser. I denna process kategoriseras data under olika etiketter enligt vissa parametrar som anges i input och sedan förutsägs etiketterna för data. Kategorisk betyder att utgångsvariabeln är en kategori, dvs. röd eller svart, skräppost eller inte skräppost, diabetiker eller icke-diabetiker, etc.

Klassificeringsmodeller inkluderar Support vektormaskin (SVM), K-närmaste granne (KNN), Naive Bayes etc.

a) SVM (Support Vector Machine Classifier)

SVM är en övervakad inlärningsmetod som tittar på data och sorterar dem i en av två kategorier. Jag använder ett hyperplan för att kategorisera data. En linjär diskriminerande klassificerare försöker rita en rak linje som separerar de två uppsättningarna av data och därmed skapa en modell för klassificering. Den försöker helt enkelt hitta en linje eller kurva (i två dimensioner) eller en grenrör (i flera dimensioner) som delar klasserna från varandra.

Obs - För multiklassklassificering använder SVM 'en vs vila', det betyder att beräkna olika SVM för varje klass.

b) K-närmaste grannklassificering (KNN)

- Om du läser noggrant föreslår själva namnet vad algoritmen gör. KNN anser att datapunkterna som är närmare, är mycket mer lika med avseende på funktioner och därmed mer sannolikt att tillhöra samma klass som grannen. För varje ny datapunkt beräknas avståndet till alla andra datapunkter och klassen bestäms utifrån K närmaste grannar. Ja, det kan låta halt, men för en del av klassificeringen fungerar det som vad som helst.

- En datapunkt klassificeras av det maximala antalet röster för sina grannar, sedan tilldelas datapunkten den klass som är närmast bland dess k-grannar.

- I KNN krävs ingen inlärning av modellen och allt arbete sker när en förutsägelse begärs. Det är därför KNN ofta kallas en lat inlärningsalgoritm.

c) Naïve Bayes klassificerare

- Naïve Bayes är en maskininlärningsalgoritm som rekommenderas starkt för textklassificeringsproblem. Det är baserat på Bayes sannolikhetssats. Dessa klassificerare kallas naiva eftersom de antar att funktionsvariabler är oberoende av varandra. Det betyder till exempel att vi har en fullständig mening för inmatning, då antar Naïve Bayes att varje ord i en mening är oberoende av de andra. Och klassificera dem därefter. Jag vet, det ser ganska naivt ut, men det är ett bra val för textklassificeringsproblem och det är ett populärt val för klassificering av skräppost.

- Det tillhandahåller olika typer av Naive Bayes-algoritmer som BernoulliNB, GaussianNB, MultinomialNB.

- Den anser att alla funktioner är inte relaterade, så det kan inte lära sig förhållandet mellan funktioner. Till exempel, låt oss säga, Varun gillar att äta hamburgare, han gillar också att äta pommes frites med koks. Men han gillar inte att äta en hamburgare och en kombination av pommes frites med koks tillsammans. Här kan Naïve Bayes inte lära sig förhållandet mellan två funktioner utan bara lära sig enskilda funktionsvikt.

Låt oss nu gå vidare till den andra sidan av vår övervakade inlärningsmetod, som är en regression.

regression

Regression är processen för att hitta en modell som hjälper till att differentiera data med hjälp av kontinuerliga värden. I detta ordnas arten av de förutsagda uppgifterna. Några av de mest använda regressionsmodellerna inkluderar linjär regression, slumpmässig skog (beslutsträd), neurala nätverk.

Linjär regression

- En av de enklaste metoderna i övervakad inlärning, vilket är användbart för att förutsäga det kvantitativa svaret.

- Linjär regression inkluderar att hitta den bäst passande raka linjen genom punkterna. Den bäst passande linjen kallas en regressionslinje. Den bästa passningslinjen passerar inte exakt genom alla datapunkter utan istället försöker det vara bäst att komma nära dem.

- Det är den allmänt använda algoritmen för kontinuerlig data. Men det fokuserar bara på medelvärdet för den beroende variabeln och begränsar sig till en linjär relation.

- Linjär regression kan användas för tidsserier, trendprognoser. Det kan förutsäga framtida försäljning, baserat på tidigare data.

Oövervakat lärande

- Oövervakat lärande är baserat på det tillvägagångssätt som kan tänkas vara frånvaron av en lärare och därför av absoluta misstag. Det är användbart när det krävs för att lära sig gruppering eller gruppering av element. Element kan grupperas (grupperas) beroende på deras likhet.

- I oövervakad inlärning är data ommärkta, inte kategoriserade och systemets algoritmer verkar på data utan föregående utbildning. Oövervakade inlärningsalgoritmer kan utföra mer komplexa uppgifter än övervakade inlärningsalgoritmer.

- Oövervakat inlärning inkluderar kluster som kan göras med hjälp av K betyder kluster, hierarkisk, gaussisk blandning, dold Markov-modell.

Oövervakade inlärningsprogram är:

- Likhetsdetektering

- Automatisk märkning

- Objektssegmentering (som person, djur, filmer)

Clustering

- Clustering är en oövervakad inlärningsteknik som används för dataanalys inom många områden. Klusteralgoritmen är praktiskt när vi vill få detaljerad insikt om våra data.

- Ett verkligt exempel på kluster kan vara Netflix genrekluster, som är uppdelade för olika målkunder inklusive intressen, demografi, livsstil osv. Nu kan du tänka på hur användbar kluster är när företag vill förstå sin kundbas och inrikta sig på ny potential kunder.

a) K betyder Clustering

- K betyder klusteralgoritm försöker dela upp givna okända data i kluster. Den väljer slumpmässigt 'k' kluster centroid, beräknar avståndet mellan datapunkter och kluster centroid och tilldelar sedan slutligen datapunkten till kluster centroid vars avstånd är minst av alla kluster centroids.

- I k-medel definieras grupper av den närmaste centroiden för varje grupp. Denna centroid fungerar som 'hjärna' av algoritmen, de förvärvar de datapunkter som är närmast dem och lägger sedan till dem i klustren.

b) Hierarkisk klustering

Hierarkisk gruppering liknar nästan den för normal klustering om du inte vill bygga en hierarki av kluster. Detta kan vara praktiskt när du vill bestämma antalet kluster. Anta till exempel att du skapar grupper av olika artiklar i online livsmedelsbutiken. På den första startsidan vill du ha några breda artiklar och när du klickar på ett av objekten öppnas specifika kategorier, det vill säga mer specifika kluster.

Dimensionalitetsminskning

Dimensionalitetsminskning kan betraktas som komprimering av en fil. Det betyder att ta ut den information som inte är relevant. Det minskar komplexiteten hos data och försöker behålla de meningsfulla uppgifterna. I bildkomprimering reducerar vi till exempel dimensionen i det utrymme som bilden förblir som den är utan att förstöra för mycket av det meningsfulla innehållet i bilden.

PCA för datavisualisering

Principal component analysis (PCA) är en metod för minskning av dimensioner som kan vara användbar för att visualisera dina data. PCA används för att komprimera högdimensionell data till lägre-dimensionell data, det vill säga vi kan använda PCA för att reducera en fyrdimensionell data till tre eller två dimensioner så att vi kan visualisera och få en bättre förståelse av data.

Rekommenderade artiklar

Detta är en guide till maskininlärningsmetoder. Här har vi diskuterat en introduktion, Hur lär sig maskiner? klassificeringar av maskininlärning och ett flödesschema tillsammans med en detaljerad förklaring. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Maskininlärningsarkitektur

- Maskininlärningsramar

- Maskininlärningsverktyg

- Maskininlärningstekniker

- Hyperparameter-maskininlärning

- Hierarkisk klusteralgoritm

- Hierarkisk klustering Agglomerativ & delande kluster