Introduktion till Big Data Architecture

När det gäller att hantera tunga data och utföra komplexa åtgärder på den massiva datan blir det ett behov av att använda big data-verktyg och tekniker. När vi säger att använda big data-verktyg och tekniker menar vi faktiskt att vi ber att använda olika programvara och procedurer som ligger i big data-ekosystemet och dess sfär. Det finns ingen generisk lösning som tillhandahålls för varje användningsfall och därför måste den utformas och göras på ett effektivt sätt enligt de specifika företagens krav. Således blir det ett behov av att använda olika big data-arkitektur eftersom kombinationen av olika tekniker kommer att resultera i att det resulterande användningsfallet uppnås. Genom att skapa en fast arkitektur kan det säkerställas att en livskraftig lösning tillhandahålls för det begärda användningsfallet.

Vad är Big Data Architecture?

- Denna arkitektur är utformad på ett sådant sätt att den hanterar förtäringsprocessen, bearbetning av data och analys av data görs vilket är alldeles för stort eller komplicerat för att hantera de traditionella databashanteringssystemen.

- Olika organisationer har olika trösklar för sina organisationer, vissa har det för några hundra gigabyte medan för andra till och med vissa terabyte inte är tillräckligt tröskelvärde.

- På grund av att denna händelse inträffar om du tittar på handelssystemen och varulagring har värdena och lagringskostnaderna minskat avsevärt. Det finns en enorm mängd data som kräver olika sätt att tillgodose.

- Vissa av dem är batchrelaterade data som kommer vid en viss tidpunkt och därför måste jobbet planeras på liknande sätt medan andra tillhör strömningsklassen där en realtidsströmningslinje måste byggas för att tillgodose alla krav. Alla dessa utmaningar löses med big data-arkitektur.

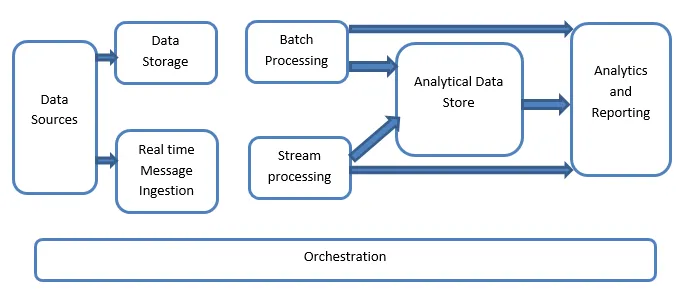

Förklaring av Big Data Architecture:

Big Data-system omfattar mer än en arbetsbelastningstyper och de klassificeras i stort sett enligt följande:

- Där de stora databaserade källorna är i vila är batchbehandling involverad.

- Stor databehandling i rörelse för realtidsbehandling.

- Utforskning av interaktiva big data-verktyg och teknik.

- Maskininlärning och prediktiv analys.

1. Datakällor

Datakällorna involverar alla de gyllene källorna från var datauttagsledningen är byggd och därför kan detta sägas vara utgångspunkten för stordatapipeline.

Exemplen inkluderar:

(i) Datastores av applikationer som sådana som relationsdatabaser

(ii) Filerna som produceras av ett antal applikationer och huvudsakligen utgör en del av statiska filsystem som webbaserade serverfiler som genererar loggar.

(iii) IoT-enheter och andra realtidsbaserade datakällor.

2. Datalagring

Detta inkluderar data som hanteras för de batchbyggda operationerna och lagras i fillagrarna som är distribuerade i naturen och också kan hålla stora volymer med stora format med stöd av stora format. Det kallas datasjön. Detta utgör i allmänhet den del där vår Hadoop-lagring som HDFS, Microsoft Azure, AWS, GCP-lager finns tillsammans med klumpbehållare.

3. Batchbehandling

All data är segregerad i olika kategorier eller bitar som använder sig av långvariga jobb som används för att filtrera och aggregera och också förbereda data o bearbetat tillstånd för analys. Dessa jobb använder vanligtvis källor, bearbetar dem och ger utdata från de bearbetade filerna till de nya filerna. Batchbehandlingen görs på olika sätt genom att använda Hive-jobb eller U-SQL-baserade jobb eller genom att använda Sqoop eller Pig tillsammans med de anpassade kartdämparen-jobb som vanligtvis är skrivna i någon av Java- eller Scala eller andra språk som Python.

4. Realtidsbaserad meddelandesintag

Detta inkluderar, i motsats till batchbehandlingen, alla realtidsströmningssystem som tillgodoser data som genereras sekventiellt och i ett fast mönster. Detta är ofta en enkel datormart eller butik som ansvarar för alla inkommande meddelanden som släpps i mappen som nödvändigtvis används för databehandling. Det finns emellertid majoritet av lösningar som kräver behov av ett meddelandebaserat förtäringslager som fungerar som en meddelandebuffert och också stöder den skalbaserade behandlingen, ger en relativt tillförlitlig leverans tillsammans med andra meddelandekössemantik. Alternativen inkluderar sådana som Apache Kafka, Apache Flume, Event hubs från Azure, etc.

5. Strömbehandling

Det är en liten skillnad mellan intag av realtidsmeddelanden och strömbearbetning. Den förstnämnda tar hänsyn till de intagna data som samlas in först och sedan används som ett publiceringsabonnemangs slag av ett verktyg. Å andra sidan används strömbearbetning för att hantera allt strömningsdata som förekommer i fönster eller strömmar och sedan skriver data till utgångsutloppet. Detta inkluderar Apache Spark, Apache Flink, Storm, etc.

6. Analytics-baserad datastore

Detta är datalagret som används för analytiska ändamål och därför ifrågasätts och analyseras sedan redan bearbetade data med hjälp av analysverktyg som kan motsvara BI-lösningarna. Uppgifterna kan också presenteras med hjälp av en NoSQL-datalagerteknik som HBase eller någon interaktiv användning av hive-databas som kan ge metadataabstraktion i datalageret. Verktyg inkluderar Hive, Spark SQL, Hbase, etc.

7. Rapportering och analys

Insikten måste genereras på bearbetade data och det görs effektivt av rapporterings- och analysverktygen som använder deras inbäddade teknik och lösning för att generera användbara grafer, analyser och insikter som är användbara för företagen. Verktyg inkluderar Cognos, Hyperion, etc.

8. Orkestrering

Stora databaserade lösningar består av datarelaterade operationer som är repetitiva till sin karaktär och är också inkapslade i arbetsflöden som kan förvandla källdata och också flytta data över källor samt sänkor och last i butiker och skjuta in i analytiska enheter. Exempel inkluderar Sqoop, oozie, datafabrik etc.

Slutsats

I det här inlägget läser vi om big data-arkitekturen som är nödvändig för att dessa tekniker ska kunna implementeras i företaget eller organisationen. Hoppas att du gillade vår artikel.

Rekommenderade artiklar

Detta har varit en guide till Big Data Architecture. Här diskuterar vi vad som är big data? och vi har också förklarat arkitekturen för big data tillsammans med blockdiagrammet. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Big Data Technologies

- Big Data Analytics

- Karriärer inom Big Data

- Big Data intervjufrågor

- Topp 8 enheter av IoT som du borde veta

- Typer av sammanfogningar i Spark SQL (exempel)