Vad är Hadoop?

Innan du förstår fördelarna med Hadoop först förstå Hadoop. Hadoop är ett stort databehandlingsparadigm som ger en pålitlig, skalbar plats för datalagring och bearbetning. Hadoop skapades av Doug Cutting och han betraktas som "Hadoop's Father". Hadoop var namnet på hans sons leksakselefant. Hadoop hade sina rötter i Nutch Search Engine Project. Hadoop är en behandlingsram som medförde enorma förändringar i hur vi bearbetar data, hur vi lagrar data. Jämfört med traditionella bearbetningsverktyg som RDBMS visade Hadoop att vi effektivt kan bekämpa utmaningarna med Big data som,

Mångfald av data: Hadoop kan lagra och bearbeta strukturerade samt semistrukturerade och ostrukturerade dataformat.

Volymen av data : Hadoop är speciellt utformad för att hantera den enorma datamängden i området petabytes.

Datahastigheten : Hadoop kan behandla petabytes med hög hastighet jämfört med andra bearbetningsverktyg som RDBMS, dvs. behandlingstiden i Hadoop är mycket mindre.

De viktigaste funktionerna hos Hadoop

- Hadoop är öppen källkod.

- Det fungerar på ett kluster av maskiner. Storleken på klustret beror på kraven.

- Den kan köras på normal varuhårdvara.

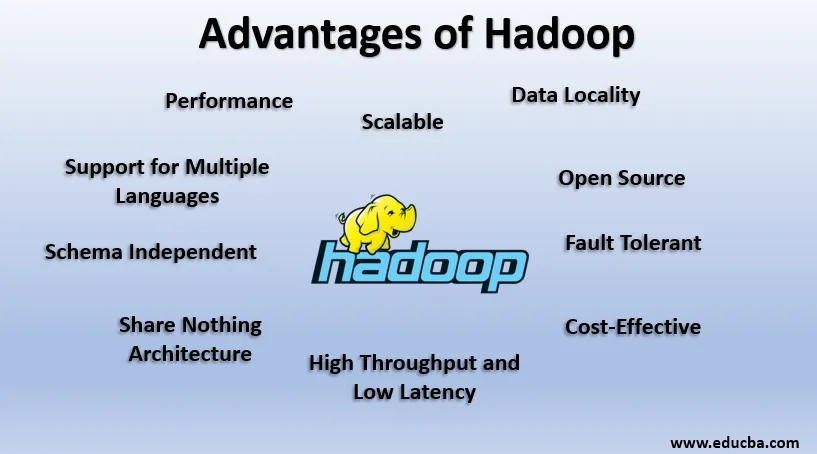

Fördelar med Hadoop

I detta avsnitt diskuteras fördelarna med Hadoop. Låt oss nu titta på dem en efter en:

1. Open Source

Hadoop är öppen källkod, det vill säga dess källkod är fritt tillgänglig. Vi kan ändra källkoden enligt våra affärskrav. Även proprietära versioner av Hadoop som Cloudera och Horton-verk är också tillgängliga.

2. Skalbar

Hadoop arbetar på kluster av maskiner. Hadoop är mycket skalbar. Vi kan öka storleken på vårt kluster genom att lägga till nya noder enligt krav utan driftstopp. Detta sätt att lägga till nya maskiner till klustret kallas Horisontell skalning, medan ökande komponenter som fördubblar hårddisk och RAM kallas Vertikal skalning.

3. Fel-tolerant

Feltolerans är den framträdande funktionen hos Hadoop. Som standard har varje block i HDFS en replikeringsfaktor på 3. För varje datablock skapar HDFS ytterligare två kopior och lagrar dem på en annan plats i klustret. Om något block försvinner på grund av maskinfel har vi fortfarande ytterligare två kopior av samma block och de används. På detta sätt uppnås Fault Tolerance i Hadoop.

4. Schema Oberoende

Hadoop kan arbeta med olika typer av data. Det är tillräckligt flexibelt för att lagra olika dataformat och kan arbeta med både data med schema (strukturerat) och schemalösa data (ostrukturerade).

5. Hög kapacitet och låg latens

Genomströmning innebär en mängd arbete som utförs per tidsenhet och låg latensmedel för att bearbeta data utan fördröjning eller mindre fördröjning. Eftersom Hadoop drivs av principen om distribuerad lagring och parallell behandling, sker bearbetningen samtidigt på varje datablock och oberoende av varandra. I stället för att flytta data flyttas koden till data i klustret. Dessa två bidrar till hög genomströmning och låg latens.

6. Datalokalitet

Hadoop fungerar enligt principen ”Flytta koden, inte data”. I Hadoop förblir data stationärt och för bearbetning av data flyttas kod till data i form av uppgifter, detta kallas Data Locality. Eftersom vi har att göra med data inom området petabytes blir det både svårt och dyrt att flytta data över nätverket, Data-lokalisering säkerställer att datarörelsen i klustret är minimal.

7. Prestanda

I Legacy-system som RDBMS behandlas data i följd men i Hadoop startar bearbetningen på alla block på en gång och ger därmed parallell bearbetning. På grund av parallella behandlingstekniker är prestandan hos Hadoop mycket högre än Legacy-system som RDBMS. År 2008 besegrade Hadoop till och med den snabbaste superdatorn närvarande.

8. Dela inget arkitektur

Varje nod i Hadoop-klustret är oberoende av varandra. De delar inte resurser eller lagring, den här arkitekturen kallas Share Nothing Architecture (SN). Om en nod i klustret misslyckas, kommer den inte att minska hela klustret eftersom varje nod fungerar oberoende, vilket eliminerar en enda misslyckande.

9. Stöd för flera språk

Även om Hadoop mest utvecklades i Java, utökar det stöd för andra språk som Python, Ruby, Perl och Groovy.

10. Kostnadseffektiv

Hadoop är väldigt ekonomisk. Vi kan bygga ett Hadoop-kluster med normal varuhårdvara och därmed minska hårdvarukostnaderna. Enligt Cloud-eraen är datahanteringskostnader för Hadoop, dvs både hårdvara och mjukvara och andra utgifter mycket minimal jämfört med traditionella ETL-system.

11. Abstraktion

Hadoop tillhandahåller abstraktion på olika nivåer. Det gör jobbet enklare för utvecklare. En stor fil är uppdelad i block av samma storlek och lagras på olika platser i klustret. När vi skapar kartminskningsuppgiften måste vi oroa oss för blockens placering. Vi ger en fullständig fil som inmatning och Hadoop-ramverket tar hand om behandlingen av olika datablock som finns på olika platser. Hive är en del av Hadoop Ecosystem och det är en abstraktion ovanpå Hadoop. Eftersom Map-Reduce-uppgifter skrivs i Java kunde SQL-utvecklare över hela världen inte dra fördel av Map Reduce. Så Hive introduceras för att lösa problemet. Vi kan skriva SQL-liknande frågor på Hive, vilket i sin tur utlöser kartan minskar jobb. Så på grund av Hive kan SQL-communityn också arbeta med Map Reduce Tasks.

12. Kompatibilitet

I Hadoop är HDFS lagringslagret och Map Reduce är bearbetningsmotorn. Men det finns ingen rigid regel att Map Reduce ska vara standard Processing Engine. Nya bearbetningsramar som Apache Spark och Apache Flink använder HDFS som ett lagringssystem. Även i Hive kan vi också ändra vår exekveringsmotor till Apache Tez eller Apache Spark enligt vårt krav. Apache HBase, som är NoSQL Columnar Database, använder HDFS för lagringslagret.

13. Stöd för olika filsystem

Hadoop är väldigt flexibel. Det kan innehålla olika dataformat som bilder, videor, filer etc. Det kan också behandla strukturerade och ostrukturerade data. Hadoop stöder olika filsystem som JSON, XML, Avro, Parkett etc.

Arbetar med Hadoop

Nedan visas punkterna som visar hur Hadoop fungerar:

1. Distribuerad lagring och parallellbehandling

Detta är drivprincipen för alla ramar för Hadoop Ecosystem inklusive Apache Spark. För att förstå hur Hadoop och Spark fungerar, bör vi först förstå vad som är "Distribuerad lagring och parallellbearbetning."

2. Distribuerad lagring

Hadoop lagrar inte data i en enda maskin, istället bryter den den enorma informationen i block med samma storlek som är 256 MB som standard och lagrar dessa block i olika noder i ett kluster (arbetarnoder). Den lagrar metadata för dessa block i huvudnoden. Detta sätt att lagra filen på distribuerade platser i ett kluster kallas Hadoop distribuerat filsystem - HDFS.

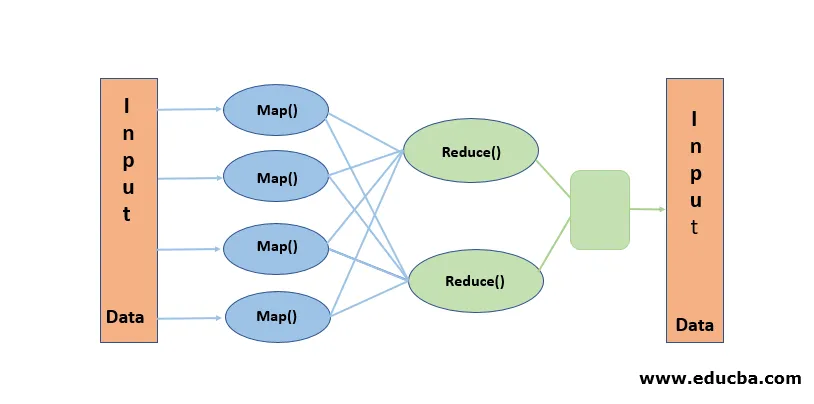

3. Parallell bearbetning

Det är ett Processing-paradigm, där bearbetningen sker samtidigt på blocken med data lagrade i HDFS. Parallell bearbetning fungerar på uppfattningen "Flytta koden, inte data". Data förblir stationära i HDFS men koden flyttas till data för bearbetning. Enkelt uttryckt, om vår fil är uppdelad i 100 block, skapas 100 kopior av jobbet och de reser över klustret till den plats där blocket finns och bearbetning på 100 block startas samtidigt (kartfas). Utdata från alla block samlas in och reduceras till slututgång (Minska fas). Map Reduce anses vara "Heart of Hadoop".

Slutsats-fördelar med Hadoop

Under denna dataålder banade Hadoop vägen för en annan inställning till utmaningar som Big Data ställde. När vi säger, Hadoop menar vi inte Hadoop ensam, det inkluderar Hadoop ekosystemverktyg som Apache Hive som ger SQL-liknande operationer ovanpå Hadoop, Apache Pig, Apache HBase för Columnar lagringsdatabas, Apache Spark för behandling i minnet och många Mer. Även om Hadoop har sina egna nackdelar är den mycket anpassningsbar och utvecklas ständigt med varje utgåva.

Rekommenderade artiklar

Detta är en guide till fördelarna med Hadoop. Här diskuterar vi vad som är Hadoop och de bästa fördelarna med Hadoop. Du kan också gå igenom våra andra relaterade artiklar för att lära dig mer-

- HADOOP-ramverk

- Vad är Hadoop Cluster?

- Vad är MapReduce i Hadoop?

- Hadoop-databas

- Vad är Hadoop? | Applikationer och funktioner