Introduktion till kärnmetoder

Kärnor eller kärnmetoder (även kallade Kernelfunktioner) är uppsättningar av olika typer av algoritmer som används för mönsteranalys. De används för att lösa ett icke-linjärt problem med en linjär klassificering. Kärnormetoder används i SVM (Support Vector Machines) som används i klassificerings- och regressionsproblem. SVM använder det som kallas ”Kernel Trick” där data transformeras och en optimal gräns hittas för möjliga utgångar.

Behovet av kärnmetoden och dess arbete

Innan vi börjar använda Kernel-metoderna är det viktigare att förstå stödvektormaskiner eller SVM: er eftersom kärnor implementeras i SVM-modeller. Så stödjar vektormaskiner är övervakade maskininlärningsalgoritmer som används i klassificerings- och regressionsproblem, till exempel att klassificera ett äpple till klassfrukt samtidigt som ett lejon klassificeras till klassdjuret.

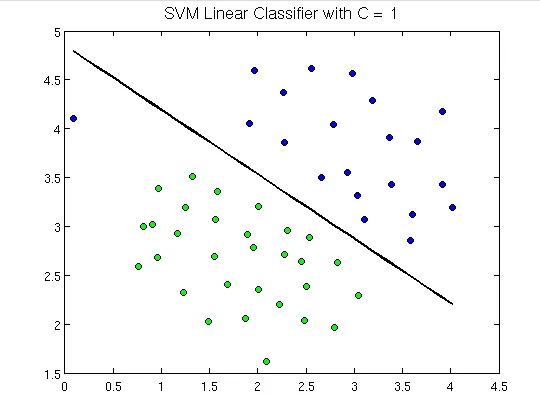

För att visa nedan är hur stödvektormaskiner ser ut:

Här kan vi se ett hyperplan som separerar gröna prickar från de blå. Ett hyperplan är en dimension mindre än det omgivande planet. I ovanstående figur har vi två dimensioner som representerar omgivningsutrymmet men den ensamma som delar upp eller klassificerar utrymmet är en dimension mindre än omgivningsutrymmet och kallas hyperplan.

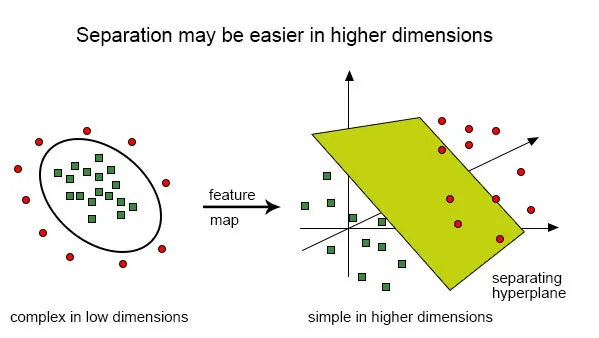

Men vad händer om vi har sådana inlägg:

Det är mycket svårt att lösa denna klassificering med hjälp av en linjär klassificering eftersom det inte finns någon bra linjär linje som ska kunna klassificera de röda och de gröna prickarna eftersom punkterna är slumpmässigt fördelade. Här kommer användningen av kärnfunktion som tar punkterna till högre dimensioner, löser problemet där borta och returnerar utdata. Tänk på detta på detta sätt, vi kan se att de gröna prickarna är inneslutna i någon omkretsområde medan den röda ligger utanför det, det kan också finnas andra scenarier där gröna prickar kan fördelas i ett trapesformat område.

Så vad vi gör är att konvertera det tvådimensionella planet som först klassificerades av endimensionellt hyperplan ("eller en rak linje") till det tredimensionella området och här kommer vår klassificering, dvs hyperplan, inte att vara en rak linje utan en två -dimensionellt plan som kommer att skära området.

För att få en matematisk förståelse av kärnan, låt oss förstå Lili Jiangs ekvation av kärnan som är:

K (x, y) = var,

K är kärnfunktionen,

X och Y är de dimensionella ingångarna,

f är kartan från n-dimensionellt till m-dimensionellt utrymme och,

är punktprodukten.

Illustration med hjälp av ett exempel.

Låt oss säga att vi har två punkter, x = (2, 3, 4) och y = (3, 4, 5)

Som vi har sett är K (x, y) =.

Låt oss först beräkna

f (x) = (x1x1, x1x2, x1x3, x2x1, x2x2, x2x3, x3x1, x3x2, x3x3)

f (y) = (y1y1, y1y2, y1y3, y2y1, y2y2, y2y3, y3y1, y3y2, y3y3)

så,

f (2, 3, 4) = (4, 6, 8, 6, 9, 12, 8, 12, 16) och

f (3, 4, 5) = (9, 12, 15, 12, 16, 20, 15, 20, 25)

så prickprodukten,

f (x). f (y) = f (2, 3, 4). f (3, 4, 5) =

(36 + 72 + 120 + 72 +144 + 240 + 120 + 240 + 400) =

1444

Och,

K (x, y) = (2 * 3 + 3 * 4 + 4 * 5) 2 = (6 + 12 + 20) 2 = 38 * 38 = 1444.

Detta som vi finner ut, f (x) .f (y) och K (x, y) ger oss samma resultat, men den tidigare metoden krävde en hel del beräkningar (på grund av att projicera 3 dimensioner till 9 dimensioner) medan man använder kärna, det var mycket lättare.

Typer av kärnor och metoder i SVM

Låt oss se några av kärnfunktionerna eller de typer som används i SVM:

1. Liner Kernel - Låt oss säga att vi har två vektorer med namnet x1 och Y1, då definieras den linjära kärnan av punktprodukten för dessa två vektorer:

K (x1, x2) = x1. x2

2. Polynomkärnan - En polynomkärna definieras av följande ekvation:

K (x1, x2) = (x1. X2 + 1) d,

Var,

d är graden av polynomet och x1 och x2 är vektorer

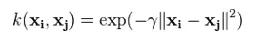

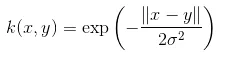

3. Gaussian Kernel - Denna kärna är ett exempel på en radiell basfunktionskärna. Nedan är ekvationen för detta:

Den givna sigmaen spelar en mycket viktig roll i utförandet av den gaussiska kärnan och bör varken överskattas eller inte underskattas, den bör noggrant anpassas efter problemet.

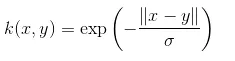

4. Exponential Kernel - Detta är i nära relation med den föregående kärnan, dvs. den gaussiska kärnan med den enda skillnaden är - kvadratet för normen tas bort.

Funktionen för den exponentiella funktionen är:

Detta är också en radiell baskärnfunktion.

5. Laplacian Kernel - Den här typen av kärnor är mindre benägna för förändringar och är helt lika med tidigare diskuterade exponentiella funktionskärnor, ekvationen för Laplacian kernel ges som:

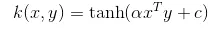

6. Hyperbolic eller Sigmoid Kernel - Den här kärnan används i neurala nätverksområden för maskininlärning. Aktiveringsfunktionen för sigmoidkärnan är den bipolära sigmoidfunktionen. Ekvationen för den hyperboliska kärnfunktionen är:

Denna kärna är mycket använd och populär bland supportvektorer.

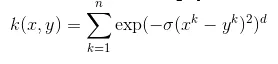

7. Anova radial basis kernel - Denna kärna är känd för att fungera mycket bra i flerdimensionella regressionsproblem precis som de gaussiska och laplaciska kärnorna. Detta hör också till kategorin radiell baskärna.

Ekvationen för Anova-kärnan är:

Det finns mycket fler typer av kärnmetoden och vi har diskuterat de mest använda kärnorna. Det beror rent på vilken typ av problem som kommer att avgöra vilken kärnfunktion som ska användas.

Slutsats

I det här avsnittet har vi sett definitionen av kärnan och hur den fungerar. Vi försökte förklara med hjälp av diagram om hur kärnor fungerar. Vi har sedan försökt att ge en enkel illustration med matematik om kärnfunktionen. I den sista delen har vi sett olika typer av kärnfunktioner som används allmänt idag.

Rekommenderade artiklar

Detta är en guide till kärnmetoder. Här diskuterar vi en introduktion, behov, det fungerar och typer av kärnmetoder med lämplig ekvation. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Data Mining Algoritms

- K- betyder klusteralgoritm

- Brute Force Algoritm

- Beslutsträdalgoritm

- Kärnmetoder i maskinlärande

- Beslutsträd i maskinlärande