Introduktion till kärnmetoder i maskininlärning

Den algoritm som används för mönsteranalys benämns Kernel Method in Machine Learning. I det allmänna mönstret görs analys för att hitta relationer i datasätt. Dessa relationer kan vara kluster, klassificering, huvudkomponenter, korrelation, etc. De flesta av dessa algoritmer som löser dessa uppgifter för att analysera mönstret, Behöver data i rå representant, för att uttryckligen omvandlas till en funktionsvektorrepresentation. Denna omvandling kan göras via en användarspecificerad funktionskarta. Så det kan tas att endast den användarspecificerade kärnan krävs av kärnmetoden.

Terminologin Kernal Method kommer från det faktum att de använder kärnfunktion, vilket gör att de kan utföra operationen i högdimensionellt, implicit funktionsutrymme utan att behöva beräkna koordinaterna för data i det utrymmet. Istället beräknar de helt enkelt den inre produkten mellan bilderna på alla datapar i funktionsutrymme.

Dessa typer av operationer är beräkningsmässigt billigare för det mesta jämfört med den exakta beräkningen av koordinaterna. Denna teknik benämns 'kärntrick'. Alla linjära modeller kan konverteras till en icke-linjär modell genom att tillämpa kärntrick på modellen.

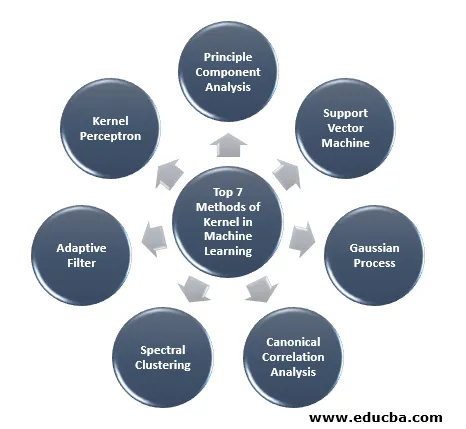

Kärnmetoden som finns tillgänglig i maskininlärning är principkomponentanalys (PCA), spektral klustering, supportvektomaskiner (SVM), kanonisk korrelationsanalys, kärnperceptron, gaussiska processer, åsregression, linjära anpassningsfilter och många andra. Låt oss ha en hög förståelse av några av dessa kärnmetoder.

Topp 7 metoder för kärnan i maskininlärning

Här är metoderna för kärnan i maskinlärande nämner nedan:

1. Analys av principkomponenter

Principal component analysis (PCA) är en teknik för att extrahera struktur från möjligen högdimensionella datamängder. Det utförs enkelt genom att använda iterativa algoritmer som uppskattar huvudkomponenter eller genom att lösa ett egenvärdesproblem. PCA är en ortogonal transformation av koordinatsystemet där vi beskriver våra data. Det nya koordinatsystemet erhålls genom projicering på dataens huvudaxlar. Ett litet antal huvudkomponenter räcker ofta för att redovisa det mesta av strukturen i uppgifterna. En av dess viktigaste tillämpningar är att utföra undersökande dataanalys för att göra en prediktiv modell. Det användes mest för att visualisera sambandet mellan populationer och genetiskt avstånd.

2. Support Vector Machine

SVM kan definieras som en klassificerare för att separera hyperplan där hyperplan är delområdet för en dimension mindre än omgivningsutrymmet. Dimensionen för detta matematiska utrymme definieras som det minsta antalet koordinater som krävs för att ange vilken punkt som helst medan det omgivande utrymmet är det utrymme som omger det matematiska objektet. Nu kan det matematiska objektet förstås som ett abstrakt objekt som inte finns någon gång eller plats men som finns som en typ av sak.

3. Gaussisk process

Gaussprocessen fick sitt namn efter Cark Friedrich Gauss eftersom den använder noteringen av Gaussisk distribution (normalfördelning). Det är en stokastisk process som innebär en samling slumpmässiga variabler indexerade av tid eller rum. I Gaussian Process har slumpmässiga variabler en multivariat normalfördelning, dvs alla de ändliga linjära kombinationerna av den är normalt fördelade. Gauss-processen använder egenskaperna som ärvts från en normalfördelning och är därför användbara vid statistisk modellering. Maskininlärningsalgoritm som involverar denna kärnmetod använder måttet på lat inlärning och likheten mellan poäng för att förutsäga värdet på osynliga poäng från träningsdata. Denna förutsägelse är inte bara uppskattningen utan osäkerheten vid den punkten.

4. Kanonisk korrelationsanalys

Kanonisk korrelationsanalys är ett sätt att dra slutsatser om information från kors-kovariansmatriser. Det är också känt som kanonisk variabelanalys. Anta att vi har två vektor X, Y av slumpmässig variabel säger två vektorer X = (X1, …, Xn) och vektor Y = (Y1, …, Ym), och variabeln har korrelation, då kommer CCA att beräkna en linjär kombination av X och Y som har den maximala korrelationen mellan varandra.

5. Spektral klustering

Vid tillämpning av bildsegmentering är spektralklustering känd som segmenteringsbaserad objektkategorisering. I spektralklustering utförs dimensionalitetsreduktion innan klustering i färre dimension, detta görs genom att använda egenvärdet för likhetsmatrisen för data. Det har sina rötter i grafteori, där detta tillvägagångssätt används för att identifiera grupper av noder i en graf som är baserad på kanterna som förbinder dem. Denna metod är tillräckligt flexibel och gör att vi också kan klustera data från icke-graf.

6. Anpassningsfilter

Det adaptiva filtret använder ett linjärt filter som innefattar en överföringsfunktion, som styrs av variabla parametrar och metoderna, som kommer att användas för att justera dessa parametrar enligt optimeringsalgoritmen. Komplexiteten i denna optimeringsalgoritm är anledningen till att allt adaptivt filter är ett digitalt filter. Ett adaptivt filter behövs i de applikationer där det inte finns någon information i förväg om den önskade behandlingsoperationen eller om de förändras.

Kostnadsfunktionen används i det adaptiva filtret med sluten slinga, eftersom det är nödvändigt för att filtret ska fungera optimalt. Den bestämmer hur man ändrar filteröverföringsfunktionen för att minska kostnaden för nästa iteration. En av de vanligaste funktionerna är medelkvadratfelet för felsignalen.

7. Kernel Perceptron

När det gäller maskininlärning är kärnan perceptron en typ av den populära perceptroninlärningsalgoritmen som kan lära sig kärnmaskiner, till exempel icke-linjära klassificeringsapparater som använder en kärnfunktion för att beräkna likheten mellan de prover som är osynliga till träningsprover. Denna algoritm uppfanns 1964 vilket gör den till den första kärnklassificeringselevern.

De flesta av de diskuterade kärnalgoritmerna är baserade på konvex optimering eller egenproblem och är statistiskt välgrundade. Deras statistiska egenskaper analyseras med hjälp av den statistiska inlärningsteorin.

Prata om applikationsområdena för kärnmetoder, det är mångfaldigt och inkluderar geostatistik, kriging, invers avståndsvägning, 3D-rekonstruktion, bioinformatik, kemoinformatik, informationsextraktion och handskriftigenkänning.

Slutsats

Jag har sammanfattat några av terminologierna och typerna av kärnmetoder i Machine Learning. På grund av brist på utrymme är den här artikeln inte alls omfattande och är bara avsedd att ge dig en förståelse för vad kärnmetoden är och en kort sammanfattning av deras typer. Om du täcker den här artikeln kommer du dock att göra det första steget inom maskininlärning.

Rekommenderade artiklar

Detta är en guide till Kernel Method in Machine Learning. Här diskuterar vi de sju typerna av kärnmetoder i maskininlärning. Du kan också titta på följande artikel.

- Monolitisk kärna

- Clustering in Machine Learning

- Data Science Machine Learning

- Oövervakad maskininlärning

- PHP-filter | Hur validerar man användarinmatning med olika filter?

- Komplett guide till maskinlärande livscykel