Hur installerar Hive?

Apache Hadoop är en samling av ramverket som möjliggör behandling av big data distribuerade över klustret. I enlighet med Apache Hive är ett datalagerprogramvaruprojekt byggt ovanpå Apache Hadoop för att tillhandahålla datafråga och analys. Apache hive ger SQL-liknande gränssnitt för att fråga och bearbeta en stor mängd data som kallas HQL (Hive frågespråk). Apache-kupan körs ovanpå Hadoop-ekosystemet och data lagrade i form av fil betyder Hadoop distribuerat filsystem (HDFS). Apache Hive tillhandahåller ett bra gränssnitt för användaren att komma åt och utföra en operation på data i form av en tabell. Det ger bra optimeringsteknik för att göra prestanda bättre. Det är väldigt utmanande att göra frågan snabbare med big data och tro mig, det spelar någon roll i en produktionsmiljö.

I backend konverterar kompilator HQL-frågan till kartminskningsjobb och skickas sedan till Hadoop-ramverket för avrättningar.

Skillnaden mellan Hive och SQL

Apache Hive liknar väldigt mycket med SQL men som vi vet hive kör på toppen av Hadoop ekosystem och internt konvertera jobb till MR (Map Reduce jobb) gör det någon skillnad mellan Hive och SQL.

Hive skulle inte vara det bästa tillvägagångssättet för de applikationer där mycket snabb respons krävs och det är mycket viktigt att förstå att Hive är bättre lämpad för batchbehandling över mycket stora uppsättningar av immutable data och vi bör notera att Hive är en vanlig RDBMS och till sist men inte minst är apachehive schema på läsmedel (medan du sätter in data i bikuptabellen kommer det inte att bry sig om datatypsmatchning men vid läsning av data kommer det att visa nollvärde om datatypen inte matchar den specifika kolumnens datatyp).

Tidigare krav för att installera Hive

Som jag sa tidigare är det väldigt viktigt att förstå Apache bikupor ovanpå Hadoop Ecosystem och Hadoop bör vara igång med alla demoner.

Några av de grundläggande Hadoop-demonerna är följande:

- Namn nod

- Datanod

- Resurschef

- Noderhanterare

För att kontrollera Hadoop-versionen nedan är kommandot:

Skriv → Hadoop-version i kommandotolken, det ger dig versionen av Hadoop.

För att kontrollera utlösaren av Hadoop-klusterrapporten nedan:

Skriv → Hadoop dfsadmin - Rapportera i kommandotolken, det ger dig hela klusterrapporten om din server körs.

Om Hadoop inte är installerat på din maskin och ber dig om att följa apache-instruktionen för att installera Hadoop på ditt system.

Jag hoppas att java redan har installerats på ditt system. för att kontrollera Java-versionen, se nedan skärmdump.

Steg för att installera Hive på Ubuntu

Nedan följer stegen för att installera Hive på Ubuntu:

Steg 1 : Hive-tjära som vi kan ladda ner genom att använda kommandot nedan i terminalen som vi också kan ladda ner direkt från terminalen.

Kommando: vi får http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Steg 2 : Extrahera tarfilen med hjälp av kommandot nedan i terminalen. Vi kan extrahera tjäran ovan nedladdade tjärafiken direkt.

Kommando: tar -xzf apache-hive-2.1.0-bin.tar.gz

Jag föreslår att du verifierar med ls- kommandot om extraherad bikupfil.

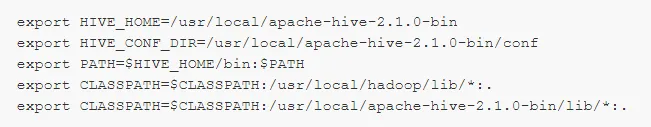

Steg 3: Redigera " .bashrc " -filen för att uppdatera miljövariablerna för användaren.

Kommando: sudo .bashrc

Lägg till följande i slutet av filen:

# Ställ in HIVE_HOME

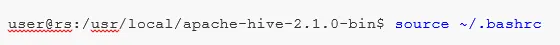

Kör kommandot nedan för att slutföra ändringsarbetet i den aktuella terminalen.

Kommando: källa .bashrc

Steg 5 : Vi måste skapa Hive-kataloger inom HDFS-platsen och detta katalog "lager", det kommer att vara platsen för att lagra metadata-relaterad information om bikuptabellen och data relaterade till Hive.

Kommando :

- hdfs dfs -mkdir -p / user / hive / warehouse

- hdfs dfs -mkdir / tmp

Steg 6 : För att ställa in läs- och skrivbehörighet för hive-tabell kör kommandot nedan.

Kommando:

I kommandot nedan tillhandahåller skrivtillstånd till användargruppen:

- hdfs dfs -chmod g + w / användare / bikupa / lager

- hdfs dfs -chmod g + w / tmp

Konfigurera Hive: Det är mycket viktigt att peka på installera hive för att konfigurera med Hadoop. Vi måste redigera hive-env.sh, en fil som är placerad i katalogen $ HIVE_HOME / conf. Följande kommandon omdirigerar till mappen Hive conf och kopierar mallfilen:

Steg 7 : Ställ in en Hadoop- väg i hive-env.sh

Redigera filen hive-env.sh genom att lägga till följande rad:

Nu med denna process är vi nästan klara och hiveinstallationerna har slutförts framgångsrikt är det viktigt att konfigurera Metastore med den externa databasservern och som standard använder Apache Hive framework Derby-databasen. Genom att använda kommandot nedan Initiera Derby-databasen.

Kommando: bin / schematool -initSchema -dbType derby

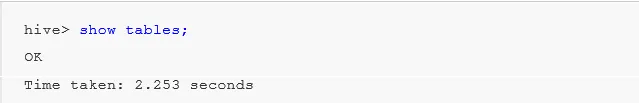

Steg 8 : Starta Hive .

Kommando: bikupa (typ bikupan i terminalen inom den andra bikupeterminalen öppnas.)

Arbeta med Hive: Nu kommer vi att se några av operationerna i bikupan för att se hur många tabeller vi har i standarddatabasanvändning se nedan skärmdumpar i nedanstående skärmdumpar. Det visar inga tabeller betyder att vi inte har några tabeller i standarddatabasen .

För att skapa en tabell i bikupan är det mycket viktigt att hänvisa till den obligatoriska databasen, annars skapas alla tabeller under standarddatabasen.

Viktiga kommandon i Hive

1: visa databaser (det visar alla databaser som har skapats till dess).

2: skapa databasen om det inte finns mydb (det här kommandot skapar en databas med namnet " mydb" om " mydb" inte finns och om " mydb redan finns kommer det inte att ge något fel")

3: använd databasen när vi måste använda några DDl-kommandon i den specifika databasen, vi bör använda kommandot "använd databas" i vårt fall vi redan har skapat "mydb" showkommando skulle användas mydb.

Viktigt Hive DDL-kommando

CREATE, DROP, TRUNCATE, SHOW, DESCRIBE .

- Skapa : - Skapa ett uttalande som används för att skapa en databas eller skapa en tabell i bikupan.

Exempel: hive> skapa databas Företag; (databas skapa)

Hive> använd Företag;

Hive> skapa tabellmedarbetare (id int, namn String, lön String); (detta skapar tabellmedarbetare under databasföretag eftersom vi redan har kört kommandot Använd databas.)

- Beskriv ger information om schemat i tabellen.

Hive> beskriv anställd; (detta ger schemat detaljer i anställdstabellen i detaljer)

- TRUNCATE tar bort tabellens data.

Hive> avkortade anställd på bordet;

Vi kan också installera Hive i ett fönster men för bästa praxis föredrar jag Ubuntu att använda, det kommer att ge en bättre bild av produktionsmiljön och dina data kommer att öka i framtiden kommer det att vara lätt att hantera.

Rekommenderade artiklar

Detta har varit en guide till Install Hive. Här har vi diskuterat de olika stegen för att installera Hive, DDL-kommando etc. Du kan också titta på följande artiklar för att lära dig mer:

- Hur man installerar SQL Server

- Hur man installerar MATLAB

- Hive-kommandon och funktion

- Grundläggande hiveintervjufrågor

- Hive Arkitektur | WorkFlow

- Använda ORDER BY-funktion i Hive

- Hiveinstallation