Skillnaden mellan Hadoop och SQL

De enorma data som genereras varje sekund via sociala medier som Facebook, Twitter, Instagram har banat vägen för utvecklingen av Hadoop / Big Data Ecosystem. Termen "3V" som refererar till Volym, hastighet och veracitet definierar vikten av Hadoop för att hantera strömningsdata. I dag genereras data från flera källor som behövs för att integreras för olika ändamål som rapportering, dataanalys och forskning och för centraliserad lagring av data. När vi gör det uppstår många problem med traditionella tillvägagångssätt som rymd, tillgång, integritet, struktur och bandbredd. För att hantera alla dessa problem tillhandahåller Hadoop ett ramverk som gör det möjligt att bearbeta data med enorm storlek, ge enkel åtkomst, hög tillgänglighet och ladda data dynamiskt. Det har ett distribuerat filsystemram (HDFS) för lagring av data och inbyggd frågeprocessor kallad ”Map Reduce” för analys och bearbetning av data lagrade i HDFS.

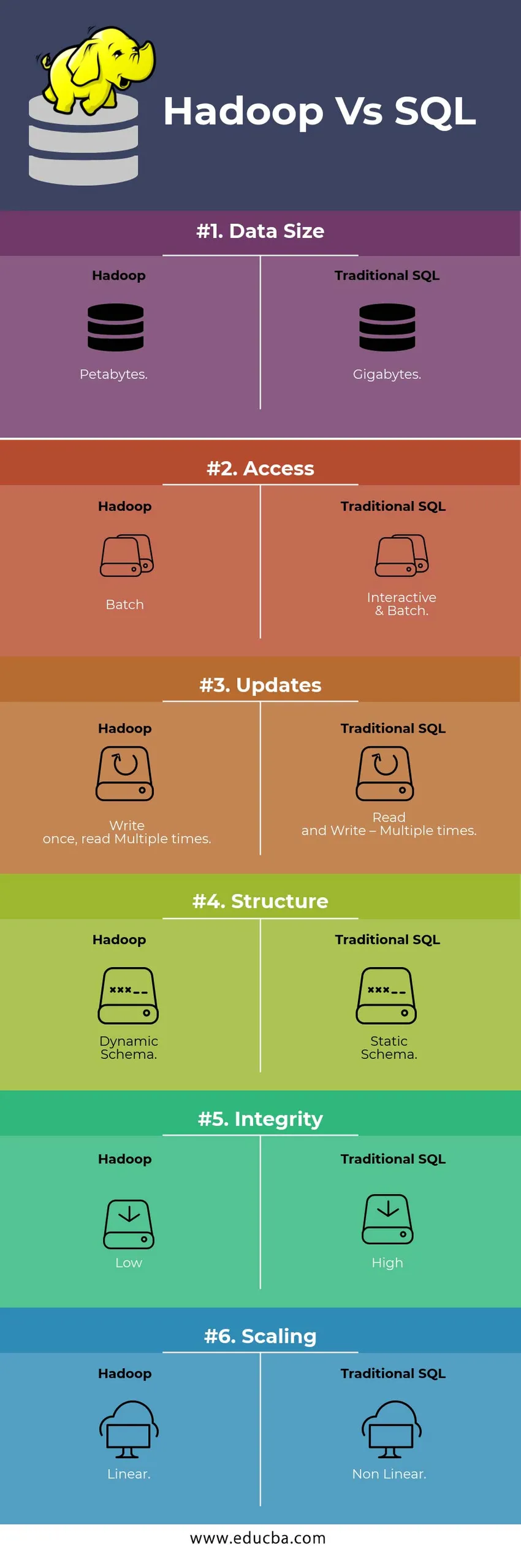

HEAD TO HEAD Jämförelse mellan Hadoop Vs SQL

Nedan visas topp 6-skillnaden mellan Hadoop Vs SQL

Viktiga skillnader mellan Hadoop Vs SQL

Nedan är skillnaden mellan Hadoop och SQL är följande

- Schema om SKRIFTLÄS VAR LÄS

I en traditionell databas följer det vanligtvis under databelastning / migrering från en databas till en annan schema på Writ-metoden. Detta gör datalastprocessen för att bli upphetsad / avbruten och resulterar i avvisande av poster på grund av en skillnad i strukturen i käll- och måltabellerna. Medan i Hadoop-systemet lagras all data i HDFS och data är centraliserade.

Hadoop-ramverket används huvudsakligen för Data Analytics-processen. Således stöder det alla tre kategorierna av data, dvs. strukturerade, semistrukturerade och ostrukturerade data och det möjliggör schema vid läsning.

- Strukturerade data har ett bestämt format. g .: XML-fil.

- Semi Structures-data är lösare; Det kan ha / inte ha ett schema. g .: Kalkylblad

- Ostrukturerad data har inte en specifik struktur eller ett schema. Exempel: Vanlig text eller bild.

Hadoop arbetar effektivt med ostrukturerad data eftersom det har förmågan att tolka uppgifterna under behandlingstiden.

| Närma sig | Fördel | Dis Advantage |

| Schema på skriv | · Fördefinierade strukturer

· Snabbare läsning. Exempel: traditionell RDBMS. | Långsam datalast

Hög latens |

| Schema på Läs | · Dynamisk struktur

· Snabbskrivning och läsning. Till exempel: Hadoop | Snabb datalast

Låg latens |

Tabell : Schema på WRITE VS Schema på LÄS.

- SKALABILITET & KOSTNADER

Hadoop Framework är utformat för att bearbeta en stor mängd data. Varje gång datornas storlek ökar, kan ett antal ytterligare resurser som datanoder läggas till i klustret mycket enkelt än den traditionella närmandet av statisk minnesallokering. Tid och budget är relativt mycket mindre för att implementera dem och Hadoop tillhandahåller också datalokalitet där informationen görs tillgänglig i den nod som utförde jobbet.

- FELTOLERANS

I den traditionella RDBMS, när data går förlorad på grund av korruption eller nätverksproblem, tar det mer tid, kostnad och resurs att få tillbaka den förlorade informationen. Men Hadoop har en mekanism där uppgifterna har minst tre nivåer av replikeringsfaktor för data som lagras i HDFS. Om en av datanoderna som håller data blir misslyckad kan data enkelt dras från andra datanoder med hög tillgänglighet av data. Därför gör informationen lätt tillgänglig för användaren oavsett fel.

- FUNKTIONELL PROGRAMMERING

Hadoop stöder att skriva funktionell programmering på språk som java, scala och python. För alla applikationer som kräver ytterligare funktioner kan implementeras genom att registrera UDF – Användardefinierade funktioner i HDFS. I RDBMS finns det ingen möjlighet att skriva UDF och detta ökar komplexiteten i att skriva SQL. Dessutom kan data som lagras i HDFS nås av alla ekosystem i Hadoop som Hive, Pig, Sqoop och HBase. Så om UDF är skriven kan den användas av vilken som helst av ovannämnda applikationer. Det ökar systemets prestanda och supportbarhet.

- OPTIMERING

Hadoop lagrar data i HDFS och Process även om Map Reduce med enorma optimeringstekniker. De mest populära teknikerna som används för att hantera data använder partitionering och bucketing av lagrade data. Partitionering är en metod för lagring av data i HDFS genom att dela upp data baserat på kolumnen som nämns för partitionering. När informationen injiceras eller laddas in i HDFS, identifierar den partitionskolumnen och skjuter data in i den berörda partitionskatalogen. Så frågan hämtar resultatuppsättningen genom att direkt hämta data från den partitionerade katalogen. Detta minskar hela tabellskanningen, förbättrar responstiden och undviker latens.

En annan metod kallas Bucketing of the data. Detta gör det möjligt för analytiker att enkelt distribuera data mellan datanoderna. Alla noder kommer att ha ett lika stort antal distribuerade data. Spännkolonnen väljs på ett sådant sätt att den har det minsta antalet kardinalitet.

Dessa tillvägagångssätt är inte tillgängliga i traditionell metod för SQL.

- DATA TYP

I en traditionell metod är datatypen som stöds mycket begränsad. Det stöder endast strukturerade data. Så att rensa och formatera schemat för själva data kommer att ta mer tid. Men Hadoop stöder komplex datatyp som Array, Struct och Map. Detta uppmuntrar till att använda de olika typerna av en datasats som ska användas för datalast. För Ex: XML-data kan laddas genom att definiera data med XML-element som innehåller komplex datatyp.

- DATAKOMPRIMERING

Det finns mycket mindre inbyggda komprimeringstekniker tillgängliga för det traditionella databassystemet. Men för Hadoop-ramverket finns det många komprimeringstekniker som gzib, bzip2, LZO och snappy. Standardkomprimeringsläget är LZ4. Till och med tabellerna kan komprimeras med hjälp av komprimeringstekniker som Parquet, ORC. Komprimeringstekniker hjälper till att få tabellerna att uppta mycket mindre utrymme öka kapaciteten och snabbare körning av frågan.

Hadoop mot SQL-jämförelsetabell

| egenskaper | Traditionell SQL | Hadoop |

| Datastorlek | gigabyte | petabyte |

| Tillgång | Interaktiv & batch | Omgång |

| uppdateringar | Läs och skriv - flera gånger | Skriv en gång, läs flera gånger |

| Strukturera | Statiskt schema | Dynamiskt schema |

| Integritet | Hög | Låg |

| skalning | Icke-linjära | Linjär |

Tabell : Jämförelse mellan traditionell Hadoop och SQL Framework.

Slutsats - Hadoop mot SQL

Sammantaget går Hadoop före den traditionella SQL när det gäller kostnader, tid, prestanda, tillförlitlighet, supportbarhet och tillgänglighet av data för den mycket stora användargruppen. För att effektivt hantera den enorma mängd data som genereras varje dag, hjälper Hadoop-ramverket till att snabbt fånga in, lagra, bearbeta, filtrera och slutligen lagra det på en central plats.

Rekommenderad artikel

- Hadoop vs Hive - Ta reda på de bästa skillnaderna

- Lär dig de 10 användbara skillnaderna mellan Hadoop vs Redshift

- HADOOP vs RDBMS | Vet de 12 användbara skillnaderna

- Apache Hadoop vs Apache Spark | Topp 10 jämförelser du måste känna till!

- Hadoop vs Spark: Funktioner