Översikt över förlustfunktioner i maskininlärning

Precis som lärare guidar oss, oavsett om vi presterar bra eller inte i våra akademiker, gör förlustfunktioner samma arbete. Det är en metod för att utvärdera hur väl vår algoritm modellerar data. Förlustfunktioner är den viktigaste källan till utvärdering i modern maskinlärning. När du ändrar din algoritm för att förbättra din modell kommer förlustfunktionsvärdet att berätta om du gör ett framsteg eller inte. Vårt primära mål borde vara att minska förlustfunktionen genom optimering. I den här artikeln kommer vi att diskutera hur förlustfunktioner fungerar och olika typer av förlustfunktioner.

Hur fungerar förlustfunktioner?

Ordet "Förlust" anger straffet för att inte ha uppnått den förväntade produktionen. Om avvikelsen i det förutspådda värdet än förväntat värde av vår modell är stor, ger förlustfunktionen det högre antalet som output och om avvikelsen är liten och mycket närmare det förväntade värdet, matar den ut mindre antal.

Här är ett exempel när vi försöker förutsäga husförsäljningspriset i tunnelbanestäder.

| förutspått

Försäljningspris (In lakh) | Faktisk

Försäljningspris (In lakh) | Avvikelse (förlust) |

| Bangalore: 45 | 0 (Alla förutsägelser är korrekta) | |

| Pune: 35 | ||

| Chennai: 40 | ||

| Bangalore: 40 | Bangalore: 45 | 5 lakh för Bangalore, 2 lakh för Chennai |

| Pune: 35 | Pune: 35 | |

| Chennai: 38 | Chennai: 40 | |

| Bangalore: 43 | 2 lakh för Bangalore, 5 lakh för, Pune2 lakh för Chennai, | |

| Pune: 30 | ||

| Chennai: 45 |

Det är viktigt att notera att mängden avvikelse inte spelar någon roll, det som är viktigt här, är om det värde som förutses av vår modell är rätt eller fel. Förlustfunktioner är olika baserade på ditt problem som maskininlärning tillämpas på. Kostnadsfunktionen är en annan term som används omväxlande för förlustfunktionen, men den har en något annan betydelse. En förlustfunktion är för ett enda träningsexempel medan kostnadsfunktion är den genomsnittliga förlusten över hela tågdatasättet.

Typer av förlustfunktioner i maskininlärning

Nedan visas de olika typerna av förlustfunktioner i maskininlärning som är följande:

1) Regressionsförlustfunktioner:

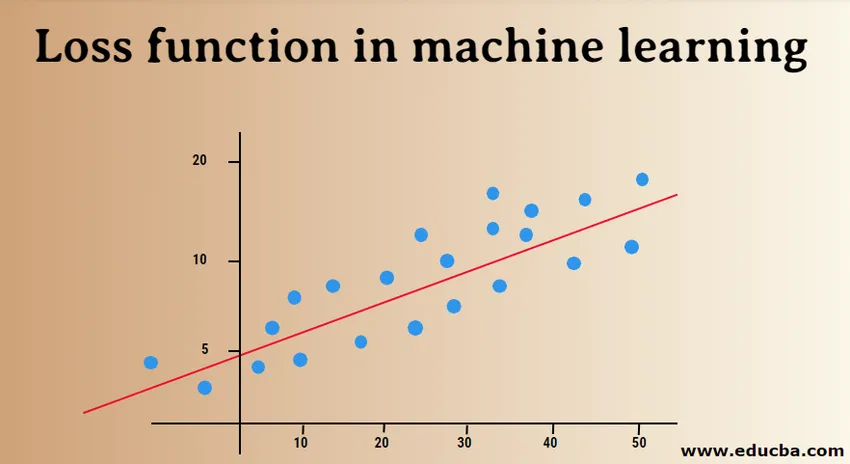

Linjär regression är ett grundläggande begrepp för denna funktion. Regressionsförlustfunktioner upprättar en linjär relation mellan en beroende variabel (Y) och oberoende variabel (X), därför försöker vi passa den bästa linjen i rymden på dessa variabler.

Y = X0 + X1 + X2 + X3 + X4 …. + Xn

X = Oberoende variabler

Y = Beroende variabel

- Genomsnittligt kvadratfelförlust:

MSE (L2-fel) mäter den genomsnittliga kvadratiska skillnaden mellan de faktiska och förutspådda värdena av modellen. Utgången är ett enda nummer associerat med en uppsättning värden. Vårt mål är att minska MSE för att förbättra modellens noggrannhet.

Betrakta den linjära ekvationen, y = mx + c, vi kan härleda MSE som:

MSE = 1 / N ∑i = 1 till n (y (i) - (mx (i) + b)) 2

Här är N det totala antalet datapunkter, 1 / N ∑i = 1 till n är medelvärde och y (i) är det verkliga värdet och mx (i) + b dess förutspådda värde.

- Medelkvadrat logaritmisk felförlust (MSLE):

MSLE mäter förhållandet mellan verkligt och förutsagt värde. Det introducerar en asymmetri i felkurvan. MSLE bryr sig bara om procentuella skillnader faktiska och förutspådda värden. Det kan vara ett bra val som förlustfunktion, när vi vill förutsäga husförsäljningspriser, bageris försäljningspriser och uppgifterna är kontinuerliga.

Här kan förlusten beräknas som medelvärdet av observerade data för de kvadratiska skillnaderna mellan de logtransformerade faktiska och förutspådda värdena, som kan anges som:

L = 1nnΣi = 1 (log (y (i) en) -log (y (i) en)) 2

- Genomsnittligt absolut fel (MAE):

MAE beräknar summan av absoluta skillnader mellan faktiska och förutspådda variabler. Det betyder att den mäter den genomsnittliga storleken på fel i en uppsättning förutspådda värden. Att använda medelkvadratfelet är lättare att lösa, men att använda det absoluta felet är mer robust för utdelare. Outliers är de värden som avviker extremt från andra observerade datapunkter.

MAE kan beräknas som:

L = 1nnΣi = 1||y (i) - y (i) ||

2) Bina klassificeringsförlustfunktioner:

Dessa förlustfunktioner görs för att mäta prestandan i klassificeringsmodellen. I detta tilldelas datapunkter en av etiketterna, dvs antingen 0 eller 1. Vidare kan de klassificeras som:

- Binär korsantropi

Det är en standardförlustfunktion för binära klassificeringsproblem. Kors entropiförlust beräknar prestandan för en klassificeringsmodell som ger en utmatning med ett sannolikhetsvärde mellan 0 och 1. Kors entropiförlust ökar när det förutsagda sannolikhetsvärdet avviker från den faktiska etiketten.

- Ledförlust

Gångjärnförlust kan användas som ett alternativ till korsentropi, som ursprungligen utvecklades för att användas med en stödvektormaskinalgoritm. Gångjärnförlust fungerar bäst med klassificeringsproblem eftersom målvärdena är i uppsättningen (-1, 1). Det gör det möjligt att tilldela fler fel när det finns skillnad i tecken mellan faktiska och förutspådda värden. Följaktligen resulterar i bättre prestanda än korsentropi.

- Kvadratiskt ledförlust

En förlängning av gångjärnförlusten, som helt enkelt beräknar kvadratet för gångjärnsförlustpoäng. Det minskar felfunktionen och gör det numeriskt lättare att arbeta med. Den hittar klassificeringsgränsen som anger den maximala marginalen mellan datapunkterna för olika klasser. Kvadratiskt gångjärnsförlust passar perfekt för JA ELLER INGEN typ av beslutsproblem, där sannolikhetsavvikelse inte är oroet.

3) Multi-class klassificeringsförlustfunktioner:

Flerklassklassificering är de prediktiva modellerna där datapunkterna tilldelas mer än två klasser. Varje klass tilldelas ett unikt värde från 0 till (Number_of_classes - 1). Det rekommenderas starkt för problem med bild- eller textklassificering, där enstaka papper kan ha flera ämnen.

- Flerklassig korsantropi

I detta fall ligger målvärdena i uppsättningen 0 till n dvs. (0, 1, 2, 3 … n). Den beräknar en poäng som tar en genomsnittlig skillnad mellan faktiska och förutspådda sannolikhetsvärden och poängen minimeras för att uppnå bästa möjliga noggrannhet. Multi-class cross-entropy är standardförlustfunktionen för textklassificeringsproblem.

- Sparse Multi-class Cross-Entropy

En het kodningsprocess gör flerklasskors entropi svårt att hantera ett stort antal datapunkter. Gles tvär entropi löser detta problem genom att utföra beräkningen av fel utan att använda en het kodning.

- Kullback Leibler Divergensförlust

KL divergensförlust beräknar skillnaden mellan sannolikhetsfördelning och baslinjefördelning och finner ut hur mycket information som går förlorad i termer av bitar. Utgången är ett icke-negativt värde som anger hur nära två sannolikhetsfördelningar är. För att beskriva KL-avvikelsen när det gäller sannolikhetsvy används sannolikhetsgraden.

I den här artikeln förstod vi inledningsvis hur förlustfunktioner fungerar och sedan fortsatte vi med att utforska en omfattande lista över förlustfunktioner med använda exempelfall. Men att förstå det praktiskt är mer fördelaktigt, så försök att läsa mer och implementera det. Det kommer att klargöra dina tvivel noggrant.

Rekommenderade artiklar

Detta är en guide till förlustfunktioner i maskininlärning. Här diskuterar vi hur fungerar förlustfunktioner och typerna av förlustfunktioner i maskininlärning. Du kan också titta på följande artiklar för att lära dig mer -

- Maskininlärningsmetoder

- Introduktion till maskininlärning

- Big Data Technologies

- Big Data Analytics-programvara

- Lär dig Catogories of Hyperparameter

- Maskinlärande livscykel | Topp 8 etapper