Introduktion till Hadoop fs kommandon

I den här artikeln kommer vi att gå igenom filhanterande kommandon för HADOOP, som används för att hantera filerna genom konsolen.

Du kommer att behöva ett Linux-system och den senaste Hadoop-versionen. För att skriva ut Hadoop-versionen, för att veta vem utgåvan byggdes, kontrollsumma-värde behöver vi bara utföra kommandot nedan efter inloggning på Hadoop-plattformen.

Kommando: Hadoop-version

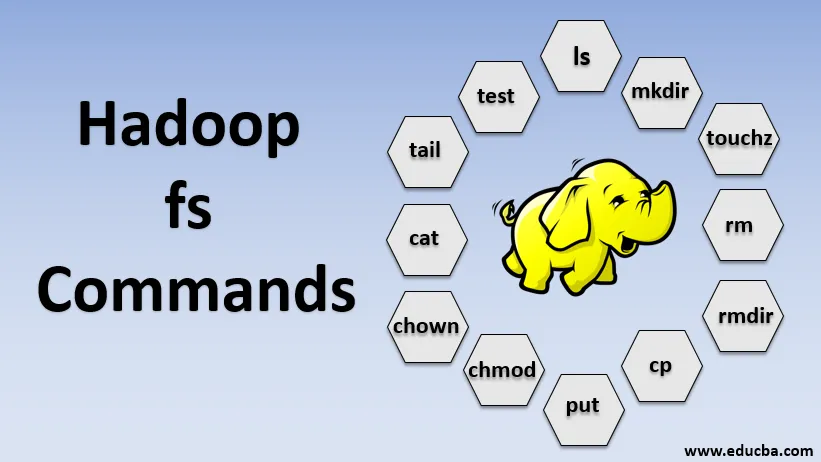

Hadoop fs kommandon

Låt oss nu lära dig hur du använder HADOOP fs-kommandon.

Vi börjar med grunderna. Skriv bara dessa kommandon i PUTTY eller vilken konsol du är bekväm med.

1. hadoop fs -ls

För en katalog returnerar den listan över filer och kataloger medan den för en fil returnerar statistiken för filen.

hadoop fs -lsr: detta är för rekursivt att lista kataloger och filer under specifika mappar.

- Exempel : hadoop fs -ls / eller hadoop fs -lsr

- -d: Detta används för att lista katalogerna som vanliga filer.

- -h: Detta används för att formatera storleken på filer på ett mänskligt läsbart sätt än bara antalet byte.

- -R: Detta används för att rekursivt lista innehållet i kataloger.

2. hadoop fs -mkdir

Detta kommando tar vägen som ett argument och skapar kataloger i hdfs.

- Exempel : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -ouchouch

Det skapar en tom fil och använder inget utrymme

- Exempel: hadoop fs -ouchouch URI

4. hadoop fs -rm

Radera filer som anges som argument. Vi måste ange alternativet -r för att radera hela katalogen. Om alternativet -skipTrash anges kommer det att hoppa över papperskorgen och filen kommer att raderas omedelbart.

- Exempel : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Det tar bort filer och behörigheter för kataloger och underkataloger. I princip är det den utvidgade versionen av Hadoop fs-rm.

6. hadoop fs-cp

Den kopierar filen från en plats till en annan

- Exempel : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Den kopierar filen från edgenode till HDFS.

8. hadoop fs-utgång

Den kopierar filen från edgenode till HDFS, den liknar det föregående kommandot men sätter också läser inmatning från standardinmatning stdin och skriver till HDFS

- Exempel : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Flaggan bevarar åtkomst, modifieringstid, ägande och läge.

hadoop fs -put -f: Detta kommando skriver över destinationen om filen redan finns före kopian.

9. hadoop fs -moveFromLocal

Det liknar kopia från lokalt förutom att källfilen raderas från lokal edgenode efter att den har kopierats till HDFS

- Exempel : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Den kopierar filen från HDFS till edgenode.

- Exempel : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Detta kommando hjälper oss att ändra åtkomst till en fil eller katalog

- Exempel : hadoop fs -chmod (-R) (sökväg)

12. hadoop fs-chown

Detta kommando hjälper oss att ändra äganderätten till en fil eller katalog

- Exempel : hadoop fs-chown (-R) (ÄGARE) (:( GROUP)) PATH

13. hadoop fs-katt

Den skriver ut innehållet i en HDFS-fil på terminalen

- Exempel : hadoop fs -cat /user/data/abc.csv

14. hadoop fs-tail

Den visar sista KB av HDFS-filen till stdout

- Exempel : hadoop fs-tail / in / xyzfile

15. hadoop fs-test

Detta kommando används för HDFS-filtestoperationer, det returnerar 0 om det är sant.

- - e: kontrollerar om filen finns.

- -z: kontrollerar om filen är noll längd

- -d / -f: kontrollerar om sökvägen är katalog / fil

Här diskuterar vi ett exempel i detalj

- Exempel : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Visar storlekar på filer och kataloger som finns i den givna katalogen eller längden på en fil om det är en fil

17. hadoop fs -df

Det visar ledigt utrymme

18. hadoop fs-checksum

Returnerar kontrollsumman för en fil

19. hadoop fs -getfacl

Den visar åtkomstkontrollistan (ACL: er) för den aktuella filen eller katalogen

20. hadoop fs -antal

Det räknar antalet kataloger, filer och byte under sökvägen som matchar det angivna filmönstret.

21. hadoop fs -setrep

Ändrar replikationsfaktorn för en fil. Och om sökvägen är en katalog ändrar kommandot replikeringsfaktorn för alla filer under katalogen.

- Exempel : hadoop fs -setrep -R / user / datahub: det används för att acceptera bakåtfunktionen och har ingen effekt.

hadoop fs - setrep -w / user / datahub : väntar på att replikationen är klar

22. hadoop fs -getmerge

Den sammanfogar HDFS-filer i källan till den lokala destinationsfilen

- Exempel : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Lägger till en enda källa eller flera källor från det lokala filsystemet till destinationen.

- Exempel : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Det skriver ut statistiken om filen eller katalogen.

- Exempel : hadoop fs -stat (format)

Slutsats - Hadoop fs kommandon

Så vi har gått igenom nästan alla kommandon som är nödvändiga för filhantering och visa data inuti filerna. Du kan ändra dina filer och ta in data i Hadoop-plattformen nu.

Rekommenderade artiklar

Detta är en guide till Hadoop fs kommandon. Här diskuterar vi introduktionen till Hadoop fs-kommandon tillsammans med dess exempel i detalj. Du kan också titta på följande artiklar för att lära dig mer-

- Installera Hadoop

- Hadoop Tools

- Hadoop Arkitektur

- Hadoop-komponenter

- Hadoop fs kommandon