Skillnad mellan Små data och Big Data

Små data, är ingenting annat än de data som är tillräckligt små för mänskliga i en volym och även för formatering, som gör dem tillgängliga, informativa och handlingsbara. Den traditionella databehandlingen kan inte hantera stora eller komplexa data, dessa data benämns Big Data. När datavolymen växer utöver en viss gräns räcker traditionella system och metoder inte för att bearbeta data eller omvandla data till ett användbart format. Det är därför data vanligtvis kategoriseras i två - Small Data vs Big Data

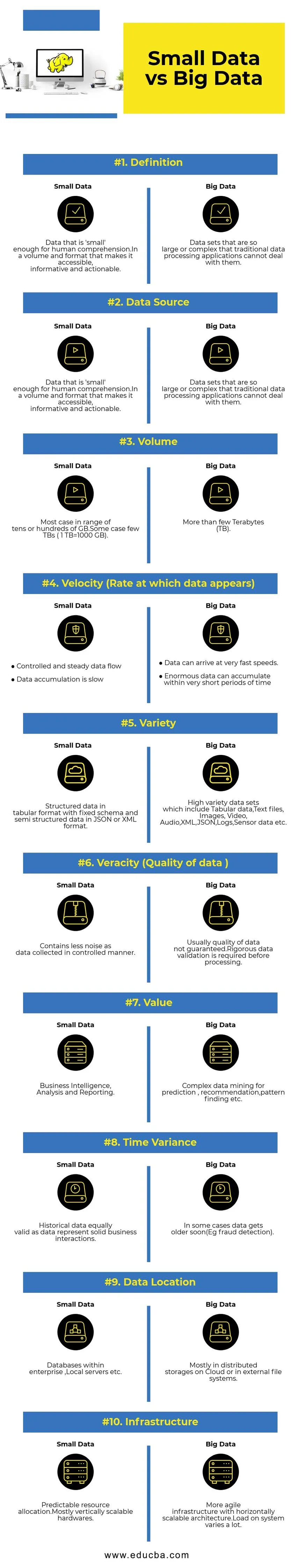

Jämförelse mellan huvuddata och små data jämfört med Big Data (Infographics)

Nedan visas de 10 bästa skillnaderna mellan Small Data och Big Data

Viktiga skillnader mellan Small Data vs Big Data

- Datainsamling - Vanligtvis är Small Data en del av OLTP-system och samlas in på ett mer kontrollerat sätt och sedan infogas i cacheskiktet eller databasen. Databaser har läst repliker för att stödja omedelbara analysfrågor om det behövs. Big Data-insamlingspipeline kommer att ha köer som AWS Kinesis eller Google Pub / Sub för att balansera data med hög hastighet. Nedströms kommer att ha strömningsledningar för realtidsanalyser och batchjobb för kalldatabehandling.

- Databehandling - Eftersom de flesta små data som genereras genom transaktionssystemet kommer analyser ovanpå att vara batchorienterade större delen av tiden. I vissa sällsynta fall körs analysfrågor direkt ovanpå transaktionssystem. Big Data-miljöer kommer att ha både batch- och strömbehandlingsrörledningar. En ström används för realtidsanalyser som upptäckt av kreditkortsbedrägerier eller förutsägelse av aktiekurs. Batchbehandling som används för att implementera komplex affärslogik med data och avancerade algoritmer.

- Skalbarhet - Små datasystem skalar normalt vertikalt. Vertikal skalning ökar systemkapaciteten genom att lägga till fler resurser till samma maskin. Vertikal skalning är kostsam men mindre komplex att hantera. Big Data-system beror mest på horisontellt skalbar arkitektur som ger mer smidighet till en lägre kostnad. Förhindrande virtuella maskiner tillgängliga i molnet gör horisontellt skalbara system ännu billigare.

- Datamodellering - Små data som genereras från transaktionssystem kommer att vara i normaliserad form.ETL (Extract Transform Load) datapipelinjer omvandlar dem till stjärn- eller snöflingaschema i ett datalager. Här schema verkställs alltid när du skriver data som är relativt enkelt eftersom data är mer strukturerade. Som nämnts ovan utgör tabelldata bara en bråkdel av Big Data. Här replikeras data mycket mer av olika skäl som överlämnande av fel eller på grund av någon begränsning av den underliggande databasmotorn (till exempel stöder en del databas bara ett sekundärt index per datasats). Ett schema verkställs inte när man skriver. Istället valideras ett schema när du läser data.

- Storage & Computation Coupling - I traditionella databaser som mestadels hanterar Small Data, är lagring och databehandling tätt kopplade. Insättning och hämtning av data till och från databasen är endast möjlig via det givna gränssnittet. Data kan inte läggas direkt i databasfilsystemet, eller befintlig data kan inte fråges med andra DB-motorer. Egentligen hjälper denna arkitektur till stor del att säkerställa dataintegritet. Big Data-system har mycket lös koppling mellan lagring och dator. Vanligtvis lagras data i ett distribuerat datalagringssystem som HDFS, AWS S3 eller Google GCS och beräknar motorn till frågeställningar eller gör ETL vald vid ett senare tillfälle. Exempelvis kan interaktiva frågor köras med Presto (Link) och ETL med hjälp av Apache Hive på samma data.

- Data Science - Maskininlärningsalgoritmer kräver inmatningsdata i ett välstrukturerat och korrekt kodat format, och det mesta av tiden kommer inmatningsdata från både transaktionssystem som ett datalager och Big Data-lagring som en datasjö. Maskininlärningsalgoritmer som bara körs på Small Data kommer att vara enkla eftersom dataförberedelsesteget är smalt. Att förbereda och berika data i Big Data-miljön tar mycket mer tid. Big Data ger många alternativ för experiment i datavetenskap på grund av den stora volymen och mängden data.

- Datasäkerhet - Säkerhetspraxis för små data som finns på företagets datalager eller transaktionssystem som tillhandahålls av motsvarande databasleverantörer som kan inkludera användarrättigheter, datakryptering, hash etc. Att säkra Big Data-system är mycket mer komplicerat och utmanande. Bästa praxis för säkerhet inkluderar kryptering av data vid vila och transitering, isolera klusternätverk, starka regler för åtkomstkontroll etc.

Jämförelse-tabell mot små data jämfört med Big Data

| Grund för jämförelse | Små data | Big Data |

| Definition | Data som är "små" nog för mänsklig förståelse. I en volym och ett format som gör det tillgängligt, informativt och handlingsbart | Datauppsättningar som är så stora eller komplexa att traditionella databehandlingsapplikationer inte kan hantera dem |

| Datakälla | ● Data från traditionella företagssystem som ○ Enterprise resursplanering Management Kundrelationshantering (CRM) ● Finansiella data som huvudbokdata ● Betalningstransaktionsdata från webbplatsen | ● Köp data från försäljningsstället ● Clickstream-data från webbplatser ● GPS-strömningsdata - Mobilitetsdata skickas till en server ● Sociala medier - facebook, twitter |

| Volym | De flesta fall inom tio eller hundratals GB. Några fall få TB (1 TB = 1000 GB) | Mer än ett fåtal Terabyte (TB) |

| Hastighet (Rate vid vilken data visas) | ● Kontrollerat och stadigt dataflöde ● Datainsamlingen är långsam | ● Data kan komma fram till mycket snabba hastigheter. ● Enorm data kan samlas inom mycket korta tidsperioder |

| Mängd | Strukturerade data i tabellformat med fast schema och semistrukturerade data i JSON- eller XML-format | Datauppsättningar med hög variation som inkluderar tabelldata, textfiler, bilder, video, ljud, XML, JSON, loggar, sensordata etc. |

| Veracity (kvalitet på data) | Innehåller mindre brus som data som samlas in på ett kontrollerat sätt. | Vanligtvis är kvaliteten på data inte garanterad. Noggrann datavalidering krävs innan behandlingen. |

| Värde | Affärsintelligens, analys och rapportering | Komplex data mining för förutsägelse, rekommendation, mönsterupptäckning etc. |

| Tidsvarians | Historiska data lika giltiga som data representerar solida affärsinteraktioner | I vissa fall blir data snart äldre (t.ex. bedrägeriupptäckt). |

| Data Location | Databaser inom ett företag, lokala servrar etc. | Oftast i distribuerade lagrar på Cloud eller i externa filsystem. |

| Infrastruktur | Förutsägbar resursallokering. Mest vertikalt skalbar hårdvara | Mer smidig infrastruktur med en horisontellt skalbar arkitektur. Belastningen på systemet varierar mycket. |

Slutsats - Small Data vs Big Data

Det ultimata målet för dataanalys för att få aktuell insikt för att stödja beslutsfattande. Att kategorisera data i små och stora hjälper till att ta itu med utmaningar när det gäller att analysera data från varje värld separat med rätt verktyg. Linjen mellan två kategorier varierar med framväxande avancerade databehandlingssystem vilket gör även stordataförfrågan mycket snabbare och mindre komplex.

Rekommenderade artiklar:

Detta har varit en guide till Small Data vs Big Data, deras betydelse, jämförelse mellan huvud och huvud, viktiga skillnader, jämförelsetabell och slutsats. den här artikeln innehåller alla viktiga skillnader mellan Small Data och Big Data. Du kan också titta på följande artiklar för att lära dig mer -

- Big Data vs Data Science - Hur skiljer de sig?

- Big Data: Viktigt för sammanflytning av teknik- och affärsanalys

- Topp 5 Big Data-trender som företag kommer att behöva behärska

- 16 intressanta tips för att förvandla Big Data till Big Success