Introduktion till Autoencoders

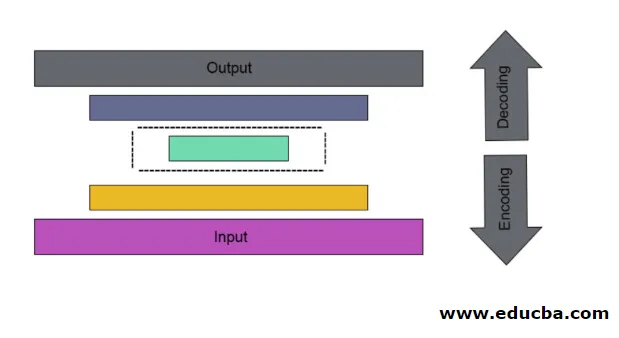

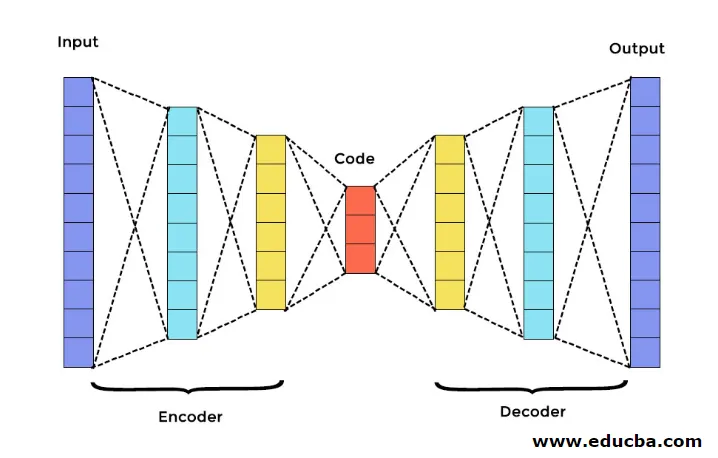

Det är fallet med konstgjord neuralt nät som används för att upptäcka effektiv datakodning på ett obevakat sätt. Målet med Autoencoder används för att lära sig presentation för en grupp av data, särskilt för avstängning av dimensionalitet. Autoencoders har en unik funktion där dess ingång är lika med sin utgång genom att bilda framföringsnätverk. Autoencoder förvandlar ingången till en komprimerad data för att bilda en lågdimensionell kod och återföra sedan ingången igen för att bilda önskad utgång. Den komprimerade ingångskoden kallas också latent rymdrepresentation. Kort sagt är huvudmålet att minska snedvridningen mellan kretsarna.

Det finns tre huvudkomponenter i Autoencoder. De är kodare, avkodare och kod. Kodaren och avkodaren är helt anslutna för att bilda ett framåtriktat nät. Koden fungerar som ett enda lager som fungerar som per egen dimension. För att utveckla en Autoencoder måste du ställa in en hyperparameter som du måste ställa in antalet noder i kärnlagret. På ett mer detaljerat sätt är utgångsnätverket för avkodaren en spegelbild av ingångsgivaren. Avkodaren producerar den önskade utgången endast med hjälp av kodskiktet.

Se till att kodaren och avkodaren har samma dimensionella värden. Den viktiga parametern för att ställa in autokodare är kodstorlek, antal lager och antal noder i varje lager.

Kodstorlek definieras av den totala mängden noder som finns i mellanlagret. För att få en effektiv komprimering rekommenderas det lilla storleken på ett mellanlager. Antalet lager i autokodare kan vara djupt eller grunt som du vill. Antalet noder i autokodare bör vara detsamma i både kodare och avkodare. Skiktet av avkodare och kodare måste vara symmetriskt.

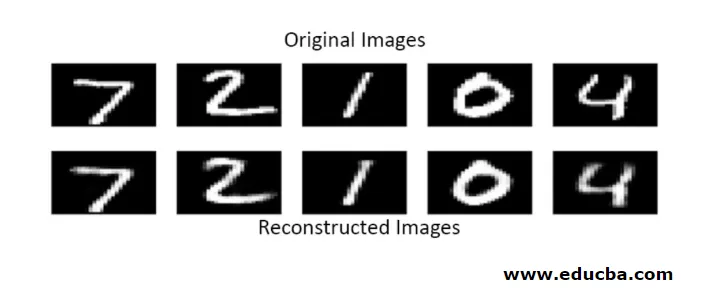

I staplad autokodare har du ett osynligt lager i både kodare och avkodare. Den består av handskrivna bilder med en storlek 28 * 28. Nu kan du utveckla autoencoder med 128 noder i det osynliga lagret med 32 som kodstorlek. För att lägga till många antal lager använder du den här funktionen

model.add(Dense(16, activation='relu'))

model.add(Dense(8, activation='relu'))

för konvertering,

layer_1 = Dense(16, activation='relu')(input)

layer_2 = Dense(8, activation='relu')(layer_1)

Nu läggs utgången från detta lager till som ingång till nästa lager. detta är det kallbara lagret i denna täta metod. Avkodaren utför denna funktion. Den använder sigmoid-metoden för att erhålla utmatning mellan 0 till 1. Eftersom ingången ligger mellan 0 till 1 område

Rekonstruktion av inmatning av en Autoencoder i denna metod görs genom förutsägelse. Det individuella bildtestet utförs och utgången är inte exakt lika inmatad men liknar ingången. För att övervinna dessa svårigheter kan du effektivisera autokodaren genom att lägga till många lager och lägga till flera noder i lager. Men gör det mer kraftfullt resulterar det i en kopia av data som liknar ingången. Men detta är inte det förväntade resultatet.

Arkitektur av Autoencoder

I denna staplade arkitektur har kodskiktet ett litet dimensionellt värde än inmatningsinformation, i vilket det sägs vara under komplett autokodare.

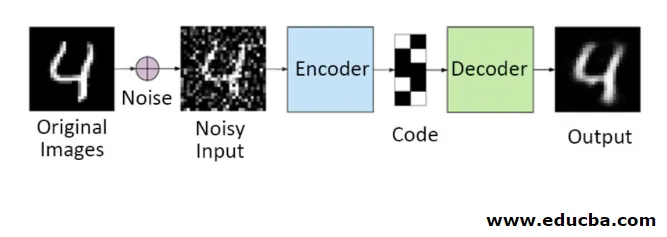

1. Denoising Autoencoders

På den här metoden kan du inte kopiera insignalen till utsignalen för att få det perfekta resultatet. Eftersom här ingångssignalen innehåller brus som måste subtraheras innan resultatet blir det underliggande data som behövs. Denna process kallas denoising autoencoder. Den första raden innehåller originalbilder. För att göra dem bullriga insignaler läggs vissa bullriga data till. Nu kan du designa autokodaren för att få en brusfri utgång enligt följande

autoencoder.fit(x_train, x_train)

En modifierad Autoencoder är som följer,

autoencoder.fit(x_train_noisy, x_train)

Därför kan du enkelt få brusfri utgång.

Convolution autoencoder används för att hantera komplexa signaler och får också ett bättre resultat än den normala processen

2. Sparsamma autokodare

För att använda autokodare effektivt kan du följa två steg.

Ställ in en liten kodstorlek och den andra denoising autoencoder.

Sedan är en annan effektiv metod normalisering. För att tillämpa denna reglering måste du reglera sparsitetsbegränsningar. För att aktivera vissa delar av noder i skiktet lägg till några extra termer till förlustfunktionen som driver autoencodern för att göra varje ingång som kombinerade mindre noder och det gör att kodaren hittar några unika strukturer i den givna datan. Det är också tillämpligt för ett stort antal data eftersom bara en del av noderna är aktiverade.

Sparsitetsbegränsningsvärdet är närmare noll

För att generera ett kodlager,

code = Dense(code_size, activation='relu')(input_img)

För att lägga till normaliseringsvärde,

code = Dense(code_size, activation='relu', activity_regularizer=l1(10e-6))(input_img)

I denna modell är bara 0, 01 den slutliga förlusten också på grund av periodiseringsperioden.

I denna glesa modell är ett gäng kodvärden sant för det förväntade resultatet. Men det har ganska låga variansvärden.

Regulariserade autokodare har unika egenskaper som robusthet mot saknade insatsvaror, gles representation och närmaste värde för derivat i presentationer. För att använda effektivt ska du hålla minsta kodstorlek och grunt kodare och avkodare. De upptäcker en hög kapacitet på ingångar och behöver inte någon extra reglerande term för att kodningen ska vara effektiv. De tränas för att ge maximal effekt snarare än att kopiera och klistra in.

3. Variational Autoencoder

Det används i komplexa fall och det finns chansen att distribuera inmatningsdata. Denna variativa autokodare använder en samplingsmetod för att få dess effektiva resultat. Det följer samma arkitektur som reglerade autokodare

Slutsats

Därför används autokodare för att lära sig verkliga data och bilder, involverade i binära och multiklassklassificeringar. Den enkla processen för att minska dimensionen. Den appliceras i en begränsad Boltzmann-maskin och spelar en viktig roll i den. Det används också i den biokemiska industrin för att upptäcka den oåpnade delen av lärandet och används för att identifiera mönstret för intelligent beteende. Varje komponent i maskininlärning har en självorganiserad karaktär, Autoencoder är en av det som är framgångsrikt lärande inom konstgjord intelligens

Rekommenderade artiklar

Detta är en guide till Autoencoders. Här diskuterar vi huvudkomponenterna i Autoencoder som är en kodare, avkodare och kod samt arkitekturen för Autoencoder. Du kan också titta på följande artiklar för att lära dig mer -

- Big Data Arkitektur

- Kodning kontra avkodning

- Maskininlärningsarkitektur

- Big Data Technologies