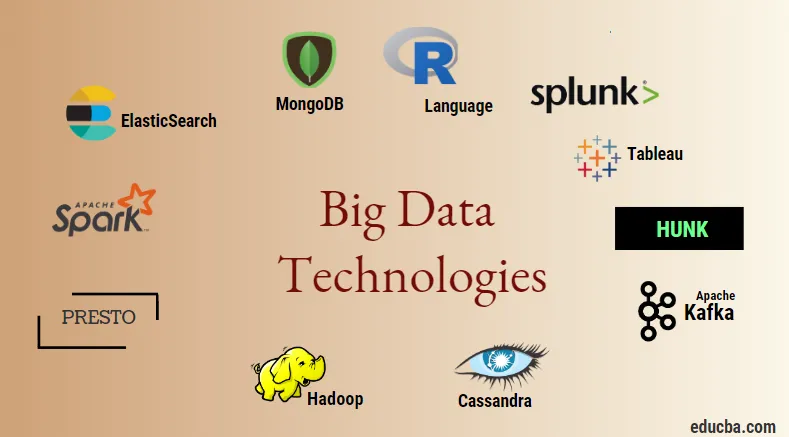

Introduktion till Big Data Technologies

Big datateknologi och Hadoop är ett stort surrord som det kan låta. Eftersom det har skett en enorm ökning av data- och informationsdomänen från alla branscher och domäner, blir det mycket viktigt att etablera och införa en effektiv teknik som tar hand om alla behoven och kraven hos klienter och stora branscher som ansvarar för dataproduktion . Tidigare hanterades uppgifterna av vanliga programmeringsspråk och enkla strukturerade frågespråk men nu verkar dessa system och verktyg inte göra mycket i fall av big data. Big datateknologi definieras som tekniken och ett mjukvaruverktyg som är utformat för analys, bearbetning och extraktion av informationen från en stor uppsättning extremt komplex struktur och stora datamängder vilket är mycket svårt för de traditionella systemen att hantera. Big data-teknik används för att hantera både realtids- och batchrelaterade data. Maskininlärning har blivit en mycket kritisk komponent i vardagen och varje bransch och därför blir hantering av data genom big data mycket viktig.

Typer av Big Data Technologies

Innan vi börjar med listan över teknologier, låt oss först se den breda klassificeringen av alla dessa tekniker. De kan huvudsakligen klassificeras i fyra domäner.

- Datalagring

- Analytics

- Data mining

- visualisering

Låt oss först täcka alla tekniker som faller under lagringsparaplyet.

1. Hadoop : När det gäller big data är Hadoop den första tekniken som kommer in. Detta är baserat på kartoreducerande arkitektur och hjälper till vid bearbetning av batchrelaterade jobb och processbatchinformation. Den var utformad för att lagra och bearbeta data i en distribuerad databehandlingsmiljö tillsammans med varuhårdvara och en enkel exekveringsmodell för programmering. Det kan användas för att lagra och analysera data som finns i olika olika maskiner med hög lagring, hastighet och låga kostnader. Detta utgör en av de viktigaste kärnkomponenterna i big data-teknik som utvecklades av Apache-programvarustiftningen år 2011 och är skriven i Java.

1. Hadoop : När det gäller big data är Hadoop den första tekniken som kommer in. Detta är baserat på kartoreducerande arkitektur och hjälper till vid bearbetning av batchrelaterade jobb och processbatchinformation. Den var utformad för att lagra och bearbeta data i en distribuerad databehandlingsmiljö tillsammans med varuhårdvara och en enkel exekveringsmodell för programmering. Det kan användas för att lagra och analysera data som finns i olika olika maskiner med hög lagring, hastighet och låga kostnader. Detta utgör en av de viktigaste kärnkomponenterna i big data-teknik som utvecklades av Apache-programvarustiftningen år 2011 och är skriven i Java.

2. MongoDB : En annan mycket väsentlig och viktig del av stordatateknologi när det gäller lagring är MongoDB NoSQL-databasen. Det är en NoSQL-databas som betyder att relationella egenskaper och andra RDBMS-relaterade egenskaper inte gäller den. Det skiljer sig från traditionella RDBMS-databaser som använder sig av strukturerat frågespråk. Den använder schemadokument och strukturen för datalagring är också annorlunda och därför hjälper de att hålla en stor mängd data. Det är ett dokumentorienterat design- och databasprogram över flera plattformar som använder JSON-liknande dokument tillsammans med schema. Detta blir ett mycket användbart fall av operativa datalagrar i de flesta finansinstitut och därmed arbetar för att ersätta de traditionella stordatorerna. MongoDB hanterar flexibilitet och även ett brett utbud av datatyper i stora volymer och bland distribuerade arkitekturer.

2. MongoDB : En annan mycket väsentlig och viktig del av stordatateknologi när det gäller lagring är MongoDB NoSQL-databasen. Det är en NoSQL-databas som betyder att relationella egenskaper och andra RDBMS-relaterade egenskaper inte gäller den. Det skiljer sig från traditionella RDBMS-databaser som använder sig av strukturerat frågespråk. Den använder schemadokument och strukturen för datalagring är också annorlunda och därför hjälper de att hålla en stor mängd data. Det är ett dokumentorienterat design- och databasprogram över flera plattformar som använder JSON-liknande dokument tillsammans med schema. Detta blir ett mycket användbart fall av operativa datalagrar i de flesta finansinstitut och därmed arbetar för att ersätta de traditionella stordatorerna. MongoDB hanterar flexibilitet och även ett brett utbud av datatyper i stora volymer och bland distribuerade arkitekturer.

3. Hunk : Det är användbart för att få tillgång till data via fjärr-Hadoop-kluster genom att använda virtuella index och använder också Splunk-sökbehandlingsspråk som kan användas för analys av data. Pinnen kan användas för att rapportera och visualisera enorma mängder data från Hadoop- och NoSQL-databaser och källor. Det utvecklades av teamet Splunk år 2013 som skrevs i Java.

3. Hunk : Det är användbart för att få tillgång till data via fjärr-Hadoop-kluster genom att använda virtuella index och använder också Splunk-sökbehandlingsspråk som kan användas för analys av data. Pinnen kan användas för att rapportera och visualisera enorma mängder data från Hadoop- och NoSQL-databaser och källor. Det utvecklades av teamet Splunk år 2013 som skrevs i Java.

4. Cassandra : Cassandra utgör ett toppval bland listan över populära NoSQL-databaser, som är en gratis och en öppen källkodsdatabas, som distribueras och har en bred kolumnlagring och effektivt kan hantera data på stora varukluster, dvs den används för att ger hög tillgänglighet tillsammans med ingen enda felpunkt. Bland listan med huvudfunktioner ingår sådana som distribuerad natur, skalbarhet, feltolerant mekanism, MapReduce-stöd, inställbar konsistens, egenskap för frågespråk, stöder replikering av flera datacenter och eventuell konsistens.

4. Cassandra : Cassandra utgör ett toppval bland listan över populära NoSQL-databaser, som är en gratis och en öppen källkodsdatabas, som distribueras och har en bred kolumnlagring och effektivt kan hantera data på stora varukluster, dvs den används för att ger hög tillgänglighet tillsammans med ingen enda felpunkt. Bland listan med huvudfunktioner ingår sådana som distribuerad natur, skalbarhet, feltolerant mekanism, MapReduce-stöd, inställbar konsistens, egenskap för frågespråk, stöder replikering av flera datacenter och eventuell konsistens.

Nästa låter oss prata om de olika områdena big data-teknik, dvs. Data Mining.

5. Presto : Det är en populär open source och en SQL-baserad distribuerad fråga Engine som används för att köra interaktiva frågor mot datakällorna i varje skala och storleken sträcker sig från Gigabyte till Petabytes. Med sin hjälp kan vi fråga data i Cassandra, Hive, egna datalagrar och relationsdatabaslagringssystem. Detta är en java-baserad sökmotor som utvecklades av Apache-stiftelsen under 2013. Några uppsättningar av företag som utnyttjar Presto-verktyget väl är Netflix, Airbnb, Checkr, Repro och Facebook.

5. Presto : Det är en populär open source och en SQL-baserad distribuerad fråga Engine som används för att köra interaktiva frågor mot datakällorna i varje skala och storleken sträcker sig från Gigabyte till Petabytes. Med sin hjälp kan vi fråga data i Cassandra, Hive, egna datalagrar och relationsdatabaslagringssystem. Detta är en java-baserad sökmotor som utvecklades av Apache-stiftelsen under 2013. Några uppsättningar av företag som utnyttjar Presto-verktyget väl är Netflix, Airbnb, Checkr, Repro och Facebook.

6. ElasticSearch : Detta är ett mycket viktigt verktyg idag när det gäller sökning. Detta utgör en väsentlig komponent i ELK-stacken, dvs den elastiska sökningen, Logstash och Kibana. ElasticSearch är en Lucene-biblioteksbaserad sökmotor som liknar Solr och används för att tillhandahålla en rent distribuerad sökmotor i fulltext som är kapabel med flera hyresgäster. Den har en lista över schemafria JSON-dokument och ett HTTP-webbgränssnitt. Det är skrivet på språket JAVA och är utvecklat av Elastic company i företaget 2012. Namnen på några få företag som använder elasticsearch är: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture, etc.

6. ElasticSearch : Detta är ett mycket viktigt verktyg idag när det gäller sökning. Detta utgör en väsentlig komponent i ELK-stacken, dvs den elastiska sökningen, Logstash och Kibana. ElasticSearch är en Lucene-biblioteksbaserad sökmotor som liknar Solr och används för att tillhandahålla en rent distribuerad sökmotor i fulltext som är kapabel med flera hyresgäster. Den har en lista över schemafria JSON-dokument och ett HTTP-webbgränssnitt. Det är skrivet på språket JAVA och är utvecklat av Elastic company i företaget 2012. Namnen på några få företag som använder elasticsearch är: LinkedIn, StackOverflow, Netflix, facebook, google, Accenture, etc.

Låt oss nu läsa om alla de stora datateknologier som ingår i dataanalys:

7. Apache Kafka : Känd för sin publicera-prenumeration eller pub-sub som den är populärt känd som, är ett direktmeddelanden, asynkron meddelandemäklarsystem som används för att ta in och utföra databehandling på realtidströmningsdata. Det ger också en bestämmelse om lagringsperioden och uppgifterna kan kanaliseras med hjälp av en producent-konsumentmekanism. Det är en av de mest populära streaming-plattformarna som liknar företagets meddelandesystem eller en meddelandekö. Kafka har lanserat många förbättringar hittills och en viktig typ är den av Kafka confluent som tillhandahåller en ytterligare nivå av egenskaper till Kafka såsom Schema-registret, Ktables, KSql, etc. Det utvecklades av Apache Software community under 2011 och är skriven i Java. De företag som använder denna teknik inkluderar Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

7. Apache Kafka : Känd för sin publicera-prenumeration eller pub-sub som den är populärt känd som, är ett direktmeddelanden, asynkron meddelandemäklarsystem som används för att ta in och utföra databehandling på realtidströmningsdata. Det ger också en bestämmelse om lagringsperioden och uppgifterna kan kanaliseras med hjälp av en producent-konsumentmekanism. Det är en av de mest populära streaming-plattformarna som liknar företagets meddelandesystem eller en meddelandekö. Kafka har lanserat många förbättringar hittills och en viktig typ är den av Kafka confluent som tillhandahåller en ytterligare nivå av egenskaper till Kafka såsom Schema-registret, Ktables, KSql, etc. Det utvecklades av Apache Software community under 2011 och är skriven i Java. De företag som använder denna teknik inkluderar Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

8. Splunk : Splunk används för att fånga, korrelera och indexera strömningsdata i realtid från ett sökbart arkiv där det kan generera rapporter, grafer, instrumentpaneler, varningar och datavisualiseringar. Det används också för säkerhet, efterlevnad och applikationshantering och även för webbanalys, för att generera affärsinsikter och affärsanalys. Det utvecklades av Splunk i Python, XML, Ajax.

8. Splunk : Splunk används för att fånga, korrelera och indexera strömningsdata i realtid från ett sökbart arkiv där det kan generera rapporter, grafer, instrumentpaneler, varningar och datavisualiseringar. Det används också för säkerhet, efterlevnad och applikationshantering och även för webbanalys, för att generera affärsinsikter och affärsanalys. Det utvecklades av Splunk i Python, XML, Ajax.

9. Apache Spark : Nu kommer den mest kritiska och den mest efterlängtade tekniken inom området Big Data-teknologier, dvs Apache Spark. Det är möjligen bland de som är högst efterfrågade idag och använder Java, Scala eller Python för dess behandling. Detta används för att bearbeta och hantera realtidsströmningsdata genom att använda Spark Streaming som använder batchning och fönsterfunktioner för att göra det. Spark SQL används för att skapa dataramar, datasätt ovanpå RDD: er och därigenom tillhandahålla en god smak av transformationer och åtgärder som utgör en integrerad del av Apache Spark Core. Andra komponenter som Spark Mllib, R och graphX är också användbara när det gäller analys och maskininlärning och datavetenskap. Beräkningstekniken i minnet är det som gör den annorlunda än andra verktyg och komponenter och stöder en mängd olika applikationer. Det utvecklades främst av Apache Software Foundation på Java-språk.

9. Apache Spark : Nu kommer den mest kritiska och den mest efterlängtade tekniken inom området Big Data-teknologier, dvs Apache Spark. Det är möjligen bland de som är högst efterfrågade idag och använder Java, Scala eller Python för dess behandling. Detta används för att bearbeta och hantera realtidsströmningsdata genom att använda Spark Streaming som använder batchning och fönsterfunktioner för att göra det. Spark SQL används för att skapa dataramar, datasätt ovanpå RDD: er och därigenom tillhandahålla en god smak av transformationer och åtgärder som utgör en integrerad del av Apache Spark Core. Andra komponenter som Spark Mllib, R och graphX är också användbara när det gäller analys och maskininlärning och datavetenskap. Beräkningstekniken i minnet är det som gör den annorlunda än andra verktyg och komponenter och stöder en mängd olika applikationer. Det utvecklades främst av Apache Software Foundation på Java-språk.

10. R-språk : R är ett programmeringsspråk och en fri mjukvarumiljö som används för statistisk databehandling och även för grafik på ett av de viktigaste språken i R. Detta är ett av de mest populära språket bland datavetare, datavetare och datalärare för att utveckla statistisk mjukvara och främst inom dataanalys.

10. R-språk : R är ett programmeringsspråk och en fri mjukvarumiljö som används för statistisk databehandling och även för grafik på ett av de viktigaste språken i R. Detta är ett av de mest populära språket bland datavetare, datavetare och datalärare för att utveckla statistisk mjukvara och främst inom dataanalys.

Låt oss nu diskutera teknologier relaterade till datavisualisering.

11. Tableau: Det är det snabbaste och kraftfullast växande datavisualiseringsverktyget som används inom affärsinformationens domän. Dataanalys är en mycket snabb maskin som är möjlig med hjälp av Tableau och visualiseringar skapas i form av kalkylblad och instrumentpaneler. Det är utvecklat av tablåföretaget 2013 och är skriven i Python, C ++, Java och C. Företag som använder sig av Tableau är: QlikQ, Oracle Hyperion, Cognos, etc.

11. Tableau: Det är det snabbaste och kraftfullast växande datavisualiseringsverktyget som används inom affärsinformationens domän. Dataanalys är en mycket snabb maskin som är möjlig med hjälp av Tableau och visualiseringar skapas i form av kalkylblad och instrumentpaneler. Det är utvecklat av tablåföretaget 2013 och är skriven i Python, C ++, Java och C. Företag som använder sig av Tableau är: QlikQ, Oracle Hyperion, Cognos, etc.

12. Plotly : Plotly används främst för att göra grafer och tillhörande komponenter snabbare och effektivare. Den har en mer rik uppsättning bibliotek och API: er som MATLAB, Python, R, Arduino, Julia, etc. Detta kan användas interaktivt i Jupyter anteckningsbok och Pycharm och kan användas för att utforma interaktiva grafer. Det utvecklades första gången 2012 och skrivs i javascript. De få företag som använder Plotly är paladins, bitbank etc.

12. Plotly : Plotly används främst för att göra grafer och tillhörande komponenter snabbare och effektivare. Den har en mer rik uppsättning bibliotek och API: er som MATLAB, Python, R, Arduino, Julia, etc. Detta kan användas interaktivt i Jupyter anteckningsbok och Pycharm och kan användas för att utforma interaktiva grafer. Det utvecklades första gången 2012 och skrivs i javascript. De få företag som använder Plotly är paladins, bitbank etc.

Slutsats

I det här inlägget har vi studerat de bästa big data-teknologierna som används i stort idag. Hoppas att du gillade det. Fortsätt följa oss för fler inlägg som dessa.

Rekommenderade artiklar

Detta är en guide till Big Data Technologies. Här har vi diskuterat en introduktion och typer av Big Data Technologies. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Vad är Splunk Tool?

- R vs Python

- Vad är Matlab?

- Vad är MongoDB?

- Steg att följa i Mainframe Testing

- Typer av sammanfogningar i Spark SQL (exempel)

- Lär dig de olika typerna av Kafka-verktyg