Översikt över linjär regressionsmodellering

När du börjar lära dig om maskininlärningsalgoritmer börjar du lära dig om olika sätt för ML-algoritmer, dvs övervakat, oövervakat, halvövervakat och förstärkt inlärning. I den här artikeln kommer vi att ta itu med övervakad inlärning och en av de grundläggande men ändå kraftfulla algoritmerna: Linear Regression.

Därför är övervakad inlärning lärandet där vi utbildar maskinen för att förstå förhållandet mellan ingångs- och utgångsvärden som tillhandahålls i träningsdatauppsättningen och sedan använda samma modell för att förutsäga utgångsvärdena för testdatauppsättningen. Så, i grund och botten, om vi har den utgång eller märkning som redan finns i vår utbildningsdatauppsättning och vi är säkra på att den levererade utgången är vettig som motsvarar ingången, använder vi Supervised Learning. Övervakade inlärningsalgoritmer klassificeras i regression och klassificering.

Regressionsalgoritmer används när du märker att utgången är en kontinuerlig variabel medan klassificeringsalgoritmer används när utgången är uppdelad i avsnitt som Pass / Fail, Good / Average / Bad, etc. Vi har olika algoritmer för att utföra regression eller klassificering åtgärder med linjär regressionsalgoritm som basalgoritm i regression.

Kommer till denna regression, innan jag går in i algoritmen, låt mig ställa basen för dig. I skolan hoppas jag att du kommer ihåg linjen ekvation koncept. Låt mig ge en kort information om det. Du fick två poäng på XY-plan, dvs säga (x1, y1) och (x2, y2), där y1 är utgången från x1 och y2 är utgången från x2, då är linjekvationen som passerar genom punkterna (y- y1) = m (x-x1) där m är linjens lutning. Efter att du har hittat linjekvationen, om du får ett poängsäg (x3, y3), skulle du lätt kunna förutsäga om punkten ligger på linjen eller punktens avstånd från linjen. Detta var den grundläggande regressionen som jag hade gjort i skolan utan att ens inse att detta skulle ha så stor betydelse för maskininlärning. Vad vi i allmänhet gör i detta är, försök att identifiera ekvationslinjen eller kurvan som kan passa inmatningen och utgången från tågdatauppsättningen korrekt och använd sedan samma ekvation för att förutsäga utgångsvärdet för testdatauppsättningen. Detta skulle resultera i ett kontinuerligt önskat värde.

Definition av linjär regression

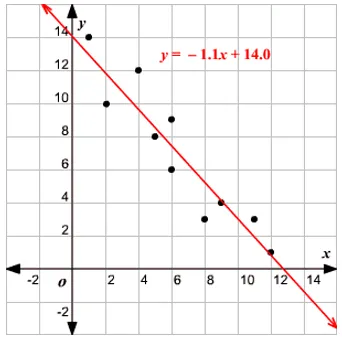

Linjär regression har faktiskt funnits mycket länge (cirka 200 år). Det är en linjär modell, dvs den antar ett linjärt förhållande mellan ingångsvariablerna (x) och en enda utgångsvariabel (y). Y här beräknas av den linjära kombinationen av inmatningsvariablerna.

Vi har två typer av linjär regression

Enkel linjär regression

När det finns en enda inmatningsvariabel, dvs. linjeekvationen är c

betraktas som y = mx + c, då är det Simple Linear Regression.

Multipel linjär regression

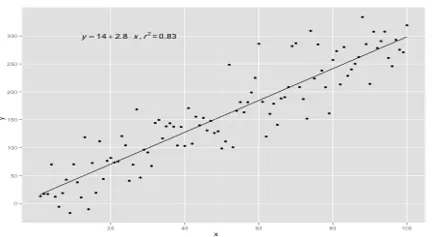

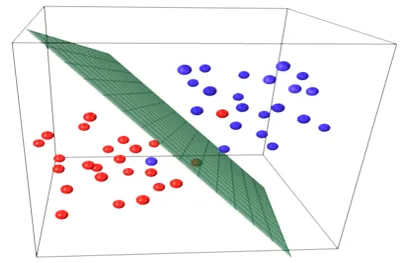

När det finns flera inmatningsvariabler, dvs linjeekvationen betraktas som y = ax 1 + bx 2 + … nx n, då är det Multiple Linear Regression. Olika tekniker används för att förbereda eller träna regressionsekvationen från data och den vanligaste bland dem kallas Ordinary Least Squares. Modellen byggd med den nämnda metoden kallas Ordinarie Minsta kvadrater Linjär Regression eller bara Least Squares Regression. Modellen används när ingångsvärdena och utgångsvärdet som ska bestämmas är numeriska värden. När det bara finns en ingång och en utgång, är den bildade ekvationen en linjeekvation, dvs.

y = B0x+B1

där koefficienterna för linjen ska bestämmas med hjälp av statistiska metoder.

Enkla linjära regressionsmodeller är mycket sällsynta i ML eftersom vi i allmänhet kommer att ha olika inputfaktorer för att bestämma resultatet. När det finns flera ingångsvärden och ett utgångsvärde, är den bildade ekvationen den för ett plan eller ett hyperplan.

y = ax 1 +bx 2 +…nx n

Grundidén i regressionsmodellen är att få en linjeekvation som bäst passar uppgifterna. Den bästa passningslinjen är den där det totala förutsägelsefelet för alla datapunkter som betraktas som litet som möjligt. Felet är avståndet mellan punkten på planet till regressionslinjen.

Exempel

Låt oss börja med ett exempel på enkel linjär regression.

Förhållandet mellan personens höjd och vikt är direkt proportionellt. En studie har utförts på volontärerna för att bestämma personens höjd och idealvikt och värdena har registrerats. Detta kommer att betraktas som vår utbildningsuppsättning. Med hjälp av träningsdata beräknas en regressionslinjeekvation som ger ett minimifel. Denna linjära ekvation används sedan för att göra förutsägelser om nya data. Det vill säga, om vi ger personens höjd, bör motsvarande vikt förutsägas av den modell som utvecklats av oss med ett minimum- eller nollfel.

Y(pred) = b0 + b1*x

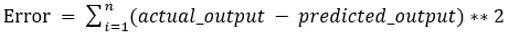

Värdena b0 och b1 måste väljas så att de minimerar felet. Om summan av kvadratfelet tas som ett mätvärde för att utvärdera modellen, är målet att få en linje som bäst minskar felet.

Vi kvadrerar felet så att positiva och negativa värden inte avbryter varandra. För modell med en prediktor:

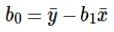

Beräkning av avlyssning (b0) i radekvationen görs av:

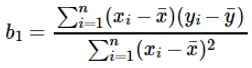

Beräkning av koefficienten för ingångsvärdet x görs av:

Förstå koefficienten b 1 :

- Om b 1 > 0, är x (ingång) och y (utgång) direkt proportionella. Det är en ökning i x kommer att öka y såsom höjd ökar, vikt ökar.

- Om b 1 <0, är x (prediktor) och y (mål) omvänt proportionell. Det är en ökning av x kommer att minska y såsom hastigheten för ett fordonsökning, tiden tar minskar.

Förstå koefficienten b 0 :

- B 0 tar upp restvärdet för modellen och ser till att förutsägelsen inte är partisk. Om vi inte har B 0- termen tvingas radekvationen (y = B 1 x) att passera genom ursprung, dvs de ingångs- och utgångsvärden som läggs in i modellen resulterar i 0. Men detta kommer aldrig att vara fallet, om vi har 0 i ingången, kommer B 0 att vara medelvärdet av alla förutsagda värden när x = 0. Att ställa in alla prediktorvärden till 0 för x = 0 kommer att leda till dataförlust och är ofta omöjligt.

Förutom koefficienterna som nämns ovan kan denna modell också beräknas med hjälp av normala ekvationer. Jag kommer att diskutera ytterligare användningen av normala ekvationer och utforma en enkel / multilinär regressionsmodell i min kommande artikel.

Rekommenderade artiklar

Detta är en guide till linjär regressionsmodellering. Här diskuterar vi definitionen, typer av linjär regression som inkluderar enkel och multipel linjär regression tillsammans med några exempel. Du kan också titta på följande artiklar för att lära dig mer–

- Linjär regression i R

- Linjär regression i Excel

- Förutsägbar modellering

- Hur man skapar GLM i R?

- Jämförelse av linjär regression vs logistisk regression