Vad är Apache Hadoop Ecosystem?

Apache Hadoop Ecosystem är ett ramverk eller en öppen källkodsdataplattform som tilldelats för att spara och undersöka de enorma datasamlingarna ostrukturerade. Över hela världen finns det massor av data som drivs från många digitala plattformar med den ledande innovativa tekniken för big data. Dessutom var Apache Hadoop den första som fick denna ström av innovation.

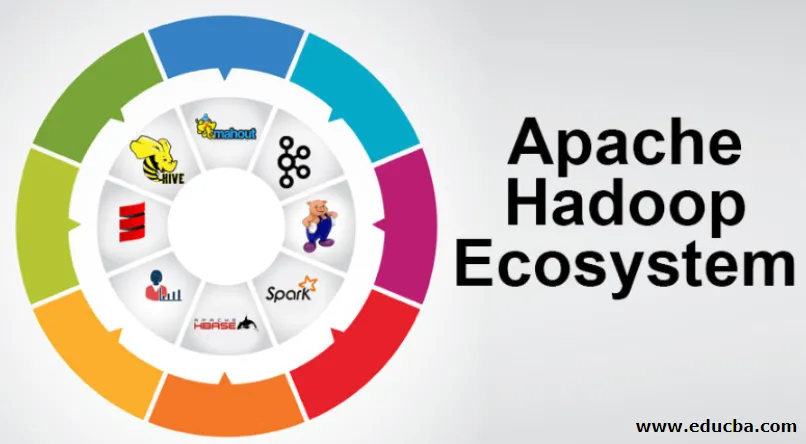

Vad består av Hadoop Data-arkitektur / ekosystem?

Hadoop Ecosystem är inte ett programmeringsspråk eller en tjänst, det är ett ramverk eller plattform som tar hand om big data-frågor. Du kan identifiera den som en svit som omsluter olika tjänster som lagring, intagning, underhåll och analys i den. Undersök sedan och få en kortfattad tanke om hur tjänsterna exklusivt fungerar och i samarbete. Apache Hadoop-arkitekturen består av olika innovationer och Hadoop-element genom vilka även de komplicerade informationsproblemen kan lösas effektivt.

Följande är en bild av varje del: -

1) Namenode: Det styr informationsprocessen

2) Datanode: Den komponerar informationen till lokal lagring. Att spara all information på en enkel plats föreslås inte kontinuerligt, eftersom det kan orsaka förlust av information i händelse av driftsstörningar.

3) Uppgiftsspårare: De får uppgifter som tilldelas slavnoden

4) Karta: Det tar information från en ström och varje rad hanteras uppdelad för att dela den i olika fält

5) Minska: Här samlas eller kopplas de fält som förvärvats genom Map samman

Apache Hadoop Ecosystem - steg för steg

Varje del av Hadoop-ekosystemet, som specifika aspekter är uppenbara. Det övergripande perspektivet på Hadoop-strukturen erbjuder anmärkningsvärd kvalitet till Hadoop Distribuerade filsystem (HDFS), Hadoop YARN, Hadoop MapReduce och Hadoop MapReduce från Hadosos ekosystem. Hadoop ger till och med varje Java-bibliotek, betydande Java-poster, reflektion på operativnivå, fördelar och skript för att driva Hadoop. Hadoop YARN är en metod för affärsöversikt och resurshantering. I Hadoop-konfiguration ger HDFS hög kapacitet till applikationsinformation och Hadoop MapReduce ger YARN-baserad parallell förberedelse av omfattande datasortiment.

Översikt över Apache Hadoop Ecosystem

Det är ett grundläggande ämne att förstå innan du börjar arbeta med Hadoop Ecosystem. Nedan är de väsentliga komponenterna:

- HDFS: Detta är den centrala delen av Hadoop Ecosystem och det kan spara en enorm mängd ostrukturerad, strukturerad och semistrukturerad information.

- Garn: Det liknar tanken i Hadoop-ekosystemet och all hantering sker direkt här, vilket kan innehålla tillgångsallokering, schemaläggningsjobb och förberedelse av åtgärder.

- MapReduce: Det är en blandning av två processer, beskrivna som Map and Reduce och består av essenser som förbereder delar som komponerar enorma informationssamlingar med parallella och spridda algoritmer i Hadoop-ekosystemet.

- Apache Pig: Det är ett språk i proceduren som används för parallella hanteringsapplikationer för att behandla stora informationssamlingar i Hadoop-skick och detta språk är ett alternativ för Java-programmering.

- HBase: Det är en öppen källkod och en icke-associerad eller NoSQL-databas. Det stärker alla informationstyper kan alltså hantera alla typer av information inom ett Hadoop-ramverk.

- Mahout, Spark MLib: Mahout används för maskininlärning och ger natur att skapa applikationer för maskininlärning.

- Zookeeper: För att ta itu med grupperna kan man använda Zookeeper, det kallas annars koordinationsherren, vilket kan ge pålitliga, snabba och sorterade operativa administrationer för Hadoop-grupparna.

- Oozie: Apache Oozie arbetar schemaläggning och fungerar som en varning och klocktjänster i Hadoop ekosystem.

- Ambari: Det är ett åtagande från Apache Software Foundation och det kan utföra Hadoop-ekosystemet gradvis flexibelt.

Hadoop YARN:

Tänk på YARN som ditt Hadoop ekosystem. Det spelar upp hela din bearbetning genom att tilldela tillgångar och planeringsuppgifter.

Det har två anmärkningsvärda segment som är ResourceManager och NodeManager.

- ResourceManager: - Det är återigen en viktig nod i driftsavdelningen. Det får de förberedande förfrågningarna och därefter överförs förfrågningarna till respektive NodeManagers, där den äkta hanteringen sker.

- NodeManagers: - Dessa installeras på varje DataNode. Det ansvarar för utförandet av en uppgift på varje DataNode.

Hur fungerar Apache Hadoop?

- Det är avsett att gå upp från enskilda servrar till en enorm mängd maskiner, var och en ger lokal beräkning och kapacitet. Istället för att bero på utrustningen för att förmedla hög tillgänglighet är själva biblioteket avsett att skilja och hantera besvikelser i applikationslagret, så att förmedla en överlägset tillgänglig tjänst över ett gäng datorer, som alla kan vara benägna till besvikelser.

- Se emellertid vidare, och det är betydligt ökande charm på jobbet. Hadoop är helt modulärt, vilket innebär att du kan byta ut nästan alla dess segment för ett alternativt programverktyg. Det gör arkitekturen fantastiskt anpassningsbar, lika kraftfull och effektiv.

Apache Hadoop Spark:

- Apache Spark är ett system för informationsanalys i realtid i en spridd datorinställning. Det implementerar beräkningar i minnet för att bygga hastigheten på informationshantering.

- Det är snabbare att hantera omfattande information eftersom den använder beräkningar i minnet och olika förbättringar. Längs dessa linjer kräver det hög bearbetningskraft.

Hur fungerar Apache Pig?

- Apache Pig är ett fördelaktigt system Yahoo utvecklades för att undersöka stora informationspositioner effektivt och smidigt. Det ger vissa toppnivåer informationsströmsspråk Pig Latin som är förbättrad, utdragbar och enkel att använda.

- Den exceptionella komponenten i grisprogram där deras sammansättning är tillgänglig för betydande parallellisering vilket gör det enkelt att ta hand om betydande informationssamlingar.

Pig Use Case:

- Den enskildas privata vårdinformation är privat och borde inte lämnas ut för andra människor. Dessa uppgifter borde döljas för att upprätthålla sekretess men ändå är informationen om medicintjänster enorm till den punkten att erkännande och uteslutande av individuell hälsoinformation är nödvändig. Apache Pig kan användas under sådana förhållanden för att identifiera hälsodata.

Slutsats:

- Det anges att stiga upp från bara en server till en enorm mängd maskiner, som alla ger beräkning och kapacitet i närheten. Se dock längre, och det finns mycket mer förtrollning på jobbet.

- Hadoop är helt modulärt, vilket innebär att du praktiskt taget kan byta ut någon av dess delar för ett alternativt programverktyg. Det gör strukturen fantastiskt anpassningsbar, lika kraftfull och effektiv.

Rekommenderade artiklar

Detta har varit en guide till Apache Hadoop Ecosystem. Här har vi diskuterat vad som är Apache Hadoop Ecosystem? översikt över Hadoop-arkitekturen och funktionen i Hadoop-ekosystemet. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Hadoop ekosystemkomponenter

- Hur man installerar Apache

- Apache Spark Training

- Karriär i Hadoop