Skillnaden mellan regression vs klassificering

I den här artikeln Regression vs Classification, låt oss diskutera de viktigaste skillnaderna mellan Regression och Classification. Maskininlärning är i stort sett indelad i två typer, de är övervakad maskininlärning och oövervakad maskinlärning. Vid övervakad maskininlärning har vi ett känt utgångsvärde i datauppsättningen och vi tränar modellen baserat på dessa och använder den för att förutsäga medan vi i oövervakad maskininlärning inte har en känd uppsättning utgångsvärden. I förväg för att skilja mellan klassificering och regression, låt oss förstå vad betyder denna terminologi i maskininlärning. Regression är en algoritm i övervakad maskininlärning som kan tränas för att förutsäga verkliga antal utgångar. Klassificering är en algoritm i övervakad maskininlärning som utbildas för att identifiera kategorier och förutsäga i vilken kategori de faller för nya värden.

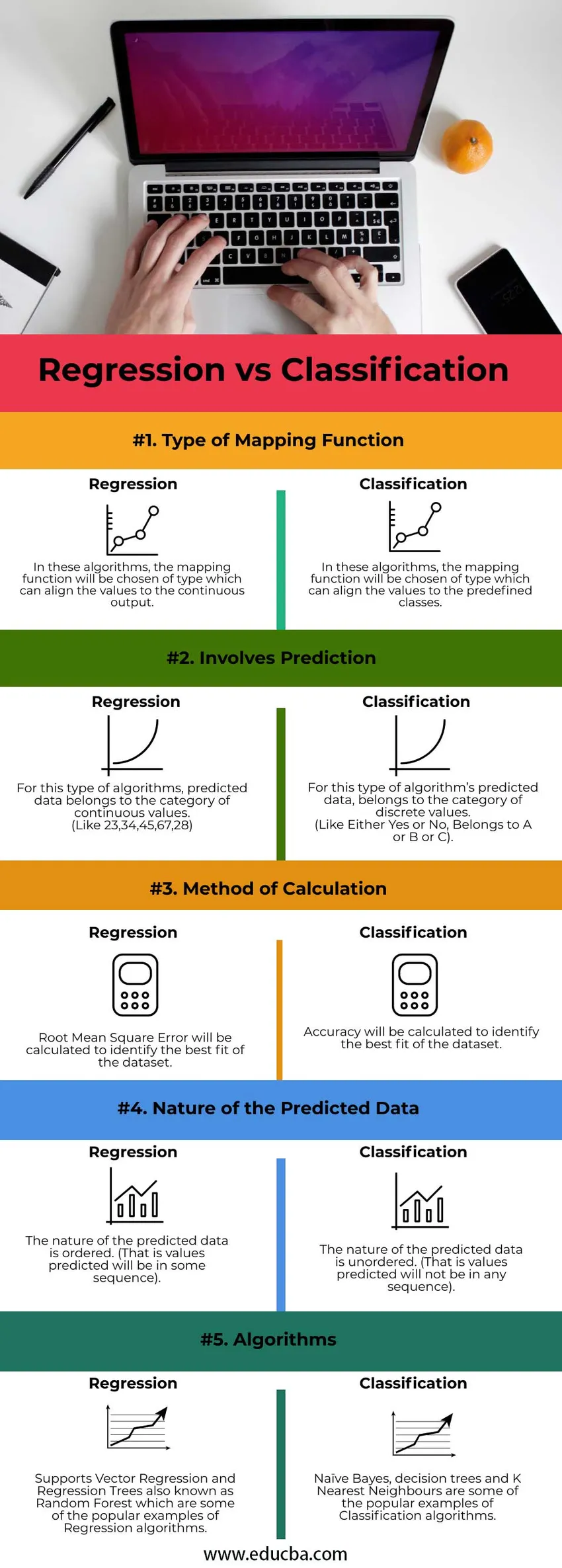

Jämförelse mellan huvud och huvud mellan regression vs klassificering (infographics)

Nedan visas topp 5-jämförelsen mellan regression vs klassificering :

Viktiga skillnader mellan regression vs klassificering

Låt oss diskutera några viktiga skillnader mellan regression vs klassificering i följande punkter:

- Klassificering handlar om att förutsäga en etikett eller kategori. Klassificeringsalgoritm klassificerar den erforderliga datauppsättningen i en av två eller flera etiketter, en algoritm som behandlar två klasser eller kategorier kallas en binär klassificerare och om det finns fler än två klasser kan den kallas som flerklassklassificeringsalgoritm.

- Regression handlar om att hitta en optimal funktion för att identifiera data för kontinuerliga verkliga värden och göra förutsägelser om den mängden. Regression med flera variabler som input eller funktioner för att träna algoritmen är känt som ett multivariat regressionsproblem. Om ingångsvärdena i regressionsproblemet är beroende eller ordnade efter tid, kallas det tidsserieprognosproblem.

- Klassificeringsmodellen kommer dock också att förutsäga ett kontinuerligt värde som är sannolikheten för att hända händelsen som tillhör den respektive utgångsklassen. Här representerar sannolikheten för händelse sannolikheten för ett givet exempel som tillhör en specifik klass. Det förutsagda sannolikhetsvärdet kan konverteras till ett klassvärde genom att välja den klassetikett som har den högsta sannolikheten.

- Låt oss förstå detta bättre genom att se ett exempel, anta att vi utbildar modellen för att förutsäga om en person har cancer eller inte baserat på vissa funktioner. Om vi får sannolikheten för att en person har cancer som 0, 8 och inte har cancer som 0, 2 kan vi omvandla 0, 8-sannolikheten till en klassetikett som har cancer eftersom den har högst sannolikhet.

- Som nämnts ovan i klassificeringen för att se hur bra klassificeringsmodellen presterar beräknar vi noggrannhet. Låt oss se hur beräkningen utförs, noggrannhet i klassificeringen kan utföras genom att ta förhållandet mellan korrekta förutsägelser och totala förutsägelser multiplicerat med 100. Om det finns 50 förutsägelser gjorda och 10 av dem är korrekta och 40 är felaktiga kommer noggrannheten att vara 20 %.

Noggrannhet = (Antal korrekta förutsägelser / Totalt antal förutsägelser) * (100)

- Noggrannhet = (10/50) * (100)

- Noggrannhet = 20%

- Som nämnts ovan i regression är det att beräkna hur bra regressionsmodellen presterar det mest populära sättet att beräkna root mean square error (RMSE). Låt oss se hur beräkningen kommer att utföras.

Det förutsagda värdet för regressionsmodellen är 4, 9 medan det verkliga värdet är 5, 3.

Det förutsagda värdet för regressionsmodellen är 2, 3 medan det verkliga värdet är 2, 1.

Det förutsagda värdet för regressionsmodellen är 3, 4 medan det verkliga värdet är 2, 9.

Nu betyder Root att kvadratfel kan beräknas med formeln.

Kvadratfel är (5, 3-4, 9) 2 = 0, 16, (2, 1-2, 3) 2 = 0, 04, (2, 9-3, 4) 2 = 0, 25

Medel av felet kvadrat = 0, 45 / 3 = 0, 15

Rotmedelvärde kvadratfel = kvadratrot av 0, 15 = 0, 38

Det är RMSE = 0, 38. Det finns många andra metoder för att beräkna modellens effektivitet men RMSE är den mest använda eftersom RMSE erbjuder felscore i samma enheter som det förutsagda värdet.

Exempel:

De flesta tekniker för datavetare har svårt att välja en regression och klassificering i början av sin karriär. För att göra det enkelt låt oss se hur klassificeringsproblemen ser ut och hur regressionsproblemen ser ut,

Klassificering

- Förutse om det kommer att regna eller inte imorgon.

- Att förutsäga en person bör köpa så bra eller inte för att tjäna vinst.

- Förutsäga om en person har en sjukdom eller inte.

Om du märker för varje situation här kan det finnas antingen ett Ja eller Nej som ett utskattat värde.

regression

- Förutsäga priset på mark.

- Förutse priset på lager.

Om du märker för varje situation här har de flesta numeriskt värde som förutsagd utgång.

Jämförelsetabell över regression vs klassificering

Tabellen nedan sammanfattar jämförelserna mellan regression vs klassificering :

| Parameter | regression |

Klassificering |

| Typ av kartläggningsfunktion | I dessa algoritmer kommer mappningsfunktionen att väljas av typen som kan anpassa värdena till den kontinuerliga utgången. | I dessa algoritmer kommer mappningsfunktionen att väljas av typen som kan anpassa värdena till de fördefinierade klasserna. |

| Involverar förutsägelse | För denna typ av algoritmer tillhör förutsagda data kategorin kontinuerliga värden.

(Gilla 23, 34, 45, 67, 28) | För denna typ av algoritmens förutsagda data tillhör kategorin diskreta värden.

(Som antingen ja eller nej, tillhör A eller B eller C). |

| Beräkningsmetod | Root Mean Square-fel kommer att beräknas för att identifiera datorns bästa anpassning. | Noggrannhet kommer att beräknas för att identifiera datasättets bästa anpassning. |

| Typ av förutsagda data | Arten av de förutsagda uppgifterna beställs. (Det är värden som förutspås kommer att vara i någon sekvens). | Arten av de förutsagda uppgifterna är oordnade. (Det är värden som förutses kommer inte att vara i någon sekvens). |

| algoritmer | Stöder vektorregression och regressionsträd kallas också Random Forest, som är några av de populära exemplen på algoritmer för regression. | Naiva Bayes, beslutsträd och K närmaste grannar är några av de populära exemplen på klassificeringsalgoritmer. |

Slutsats

Dessa är några av de viktigaste skillnaderna mellan klassificering och regression. I vissa fall kan de kontinuerliga utgångsvärden som förutses i regression grupperas i etiketter och ändras till klassificeringsmodeller. Så vi måste tydligt förstå vilken man ska välja utifrån situationen och vad vi vill att den förutsagda produktionen ska vara.

Rekommenderade artiklar

Detta är en guide till den största skillnaden mellan regression vs klassificering. Här diskuterar vi också de viktigaste skillnaderna i regression mot klassificering med infografik och jämförelsetabell. Du kan också titta på följande artiklar för att lära dig mer -

- Topp 7 typer av chiffer

- Vad är StringBuilder i C # med fördelar

- StringBuffer vs StringBuilder | Topp 4 jämförelse

- Toppskillnader - Jira vs Github

- Vad är regressionsanalys?

- Multivariat regression

- Klassificeringsalgoritmer

- Skapa beslutsträd med fördelar