Vad är gris?

Pig är en öppen källkodsmotor, som är en del av Hadoop ekosystemteknologier. Gris är bra på att arbeta med data som ligger utanför traditionella databaser eller datalager. Det här kan hantera saknade, ofullständiga eller inkonsekventa data, som inte har något schema. Grisen har sitt eget språk för att uttrycka datamanipulationer, som är svin-latin.

Förstå gris

Pig är en teknik som låter dig skriva en hög nivå, men extremt granulära skript, som gör att du kan arbeta med data där schemat är antingen okänt eller inkonsekvent. Pig är en öppen källkodsteknologi som går ovanpå Hadoop och är en del av det extremt livliga och populära Hadoop-ekosystemet.

Gris fungerar bra med ostrukturerad och ofullständig data, så du behöver inte ha den traditionella layouten för regler och kolumner för allt.

Det är väl definierat, och det kan direkt fungera på filer i HDFS (Hadoop Distribuerat filsystem).

Pig kommer att vara din valbara teknik när du vill hämta data från källan till ett datalager.

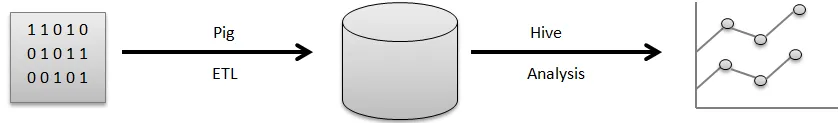

Till exempel en visuell pipeline av hur data vanligtvis flyter innan du kan använda dem för att generera de fina diagram som du använder för att fatta affärsbeslut.

Rå data kommer från en mängd olika källor, som sensorer, mobiltelefoner osv. Du kommer sedan att använda Pig för att utföra en ETL-operation. ETL står för extrahera, transformera och ladda, när dessa operationer har utförts lagras de rensade uppgifterna i en annan databas. Ett exempel på en sådan databas är HDFS, som är en del av Hadoop. Hive är ett datalager som körs ovanpå ett filsystem som detta. Hive är vad du skulle använda för analys, för att generera rapporterna och för att extrahera insikter.

ETL är ett mycket viktigt steg i databehandlingen för att få rena uppgifter rensade och i rätt form att lagras i en databas. Extrakt avser driften av att dra ostrukturerad, inkonsekvent data med saknat fält och värden från den ursprungliga källan. Transform står för den serie av operationer som du kommer att använda på data för att rensa upp den eller få den.

Förberäkning av användbar sammanlagd information, bearbetning av fält för att matcha ett visst format, allt detta är en del av datorengöring av transformfältet.

Slutligen utför Pig lastoperationen där dessa rena data lagras i en databas där de kan analyseras ytterligare. Ett exempel på en standardoperation som Pig utför är att rensa upp loggfiler.

Förklara svinarkitektur

Det finns många svindelar i arkitekturen, föredrar:

- Parser : Parser hanterar såväl Pig Scripts som, kontrollerar att syntax av skriptet, skriver typkontroll och olika assorterade kontroller. Dessutom kan deras resultat vara en DAG (Directed Acyclic Graph) som vanligtvis betyder Pig Latin-påståenden tillsammans med logiska operatörer.

Dessutom kommer de logiska operatörerna med skriptet att visas som noderna såväl som dataflöden kommer att visas sedan kanter genom DAG.

- Optimizer: Senare överskrids den logiska planen (DAG) vanligtvis mot den logiska optimeringen. Den utför de logiska optimeringarna ytterligare inklusive projektion och främjar låg

- Kompilator: Kompilatorn kompilerar också den förbättrade logiska planen i en grupp MapReduce-verk.

- Exekveringsmotor: I slutändan kommer alla MapReduce-arbeten att publiceras till Hadoop inom en sorterad sekvens. Så småningom genererar detta de erforderliga resultaten även om dessa MapReduce-arbeten kommer att utföras med Hadoop.

- MapReduce: MapReduce designades ursprungligen i Google som ett sätt att bearbeta webbsidor för att driva Googles sökning. MapReduce distribuerar datorer över flera maskiner i klustret. MapReduce tar fördelar av den inneboende parallellen i databehandlingen. Moderna system, som sensorer, eller till och med Facebook-statusuppdateringar genererar miljoner poster med rå data.

En aktivitet med denna nivå kan förberedas i två faser:

- Karta

- Minska

Du bestämmer vilken logik du vill implementera inom dessa faser för att bearbeta dina data.

- HDFS (Hadoop Distribuerat filsystem): Hadoop möjliggör en explosion av datalagring och analys i en skala i obegränsad kapacitet. Utvecklare använder en applikation som Pig, Hive, HBase och Spark för att hämta data från HDFS.

Funktioner

Apache Pig kommer med olika funktioner:

- Simplicity of Programming: Pig Latin är jämförbar med SQL och därför är det ganska enkelt för utvecklare att skapa ett Pig-script. Om du har förståelse för SQL-språk är det oerhört enkelt att lära sig svin-latin språk eftersom det är precis som SQL-språk.

- Rik uppsättning operatörer: Pig innehåller en mängd rika uppsättningar av operatörer för att kunna utföra procedurer precis som join, filer, sortering och mycket mer.

- Optimeringsmöjligheter: Prestandan med uppgiften i Apache Pig kan direkt förbättras av själva uppgiften; därför måste utvecklarna bara koncentrera sig på semantiken i detta språk.

- Utökningsbarhet: Använda tillgängliga operatörer kan användare helt enkelt utveckla sina funktioner för att läsa, bearbeta och skriva data.

- Användardefinierade funktioner (UDF: er): Genom att använda tjänster som tillhandahålls av Pig för att skapa UDF: er, kunde vi producera användardefinierade funktioner på antalet utvecklingsspråk inklusive Java samt, påkalla eller bädda in dem alla i grisskript.

Vad är svin användbart för?

Det används för att undersöka och utföra ansvar inklusive ad-hoc-hantering. Apache Pig kan användas avsedd för:

Analys med enorma råa datainsamlingar föredrar databehandling för att få sökwebbplatser. Såsom Yahoo gynnar Google Apache Pig för att utvärdera data som samlas in via Google såväl som Yahoo-sökmotorer. Hantera stora datasamlingar precis som webbposter, strömmande onlineinformation och så vidare. Till och med Facebooks statusuppdateringar genererar miljoner poster med rå data.

Hur hjälper den här tekniken dig att växa i din karriär?

Många organisationer implementerar Apache Pig otroligt snabbt. Detta innebär att yrken inom gris- och svinkarriär ökar dagligen. Det har gjorts stora framsteg i utvecklingen av Apache Hadoop under de senaste åren. Hadoop-element precis som Hive, Pig, HDFS, HBase, MapReduce, och så vidare.

Även om Hadoop-erbjudandena kom in i deras andra decennium vid denna tid ännu har exploderat i erkännande genom de tidigare tre till fyra åren. Ett stort antal mjukvaruföretag tillämpar Hadoop-kluster otroligt vanligt. Detta kan definitivt vara den bästa delen av big data. De riktade experterna kan förvandlas till erfarna med denna utmärkta teknik.

Slutsats

Apache Pig Expertise är ett stort krav på marknaden och kan fortsätta att vara för utökat. Genom att helt enkelt förstå koncepten såväl som att få erfarenhet av de bästa Apache Pig in Hadoop-färdigheterna kan experterna engagera sig i sitt Apache Pig-yrke perfekt.

Rekommenderad artikel

Detta har varit en guide till Vad är gris? Här diskuterade vi begreppen, definitionen och arkitekturen med funktionerna i Pig. Du kan också gå igenom våra andra föreslagna artiklar för att lära dig mer -

- Hur man installerar Apache

- Apache PIG intervjufrågor

- Vad är ASP.Net Web Services?

- Vad är Blockchain Technology?