Introduktion till klassificeringsalgoritmer

Den här artikeln om klassificeringsalgoritmer ger en översikt över olika klassificeringsmetoder som vanligtvis används i teknik för gruvdrift med olika principer. Klassificering är en teknik som kategoriserar data i ett tydligt antal klasser och i sin tur tilldelas etikett till varje klass. Huvudmålet för klassificeringen är att identifiera klassen för att lansera nya data genom att analysera utbildningen genom att se riktiga gränser. På ett allmänt sätt kallas förutsägelse av målklassen och ovanstående process klassificering.

Till exempel registrerar sjukhusledningen patientens namn, adress, ålder, tidigare historia för patientens hälsa för att diagnostisera dem, detta hjälper till att klassificera patienterna. De kan karakteriseras i två faser: en inlärningsfas och en utvärderingsfas. Inlärningsfasmodellerna tillvägagångsbasen ger en träningsdata medan utvärderingsfasen förutsäger resultatet för den givna informationen. Vi kunde hitta deras applikationer i e-post spam, banklånsprognos, taligenkänning, sentimentanalys. Tekniken inkluderar matematisk funktion f med ingång X och utgång Y.

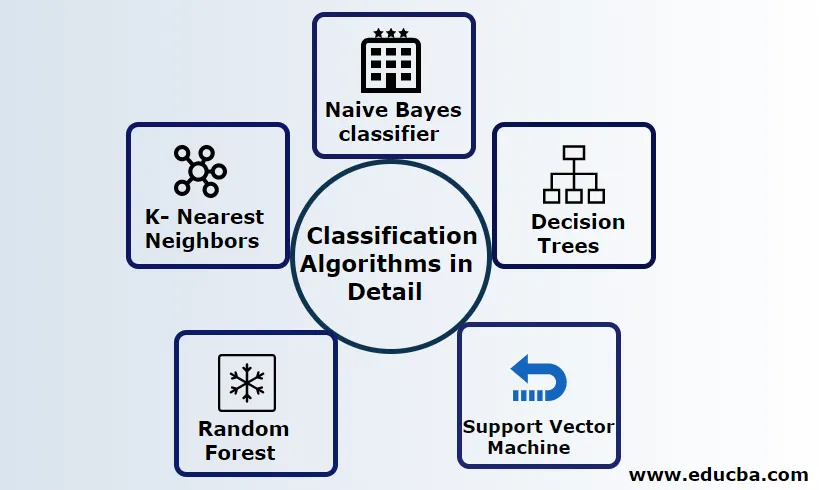

Förklara klassificeringsalgoritmer i detalj

Klassificering kan utföras på både strukturerad och ostrukturerad data. Klassificering kan kategoriseras i

- Naive Bayes klassificerare

- Beslutsträd

- Support Vector Machine

- Slumpmässig skog

- K- Närmaste grannar

1) Naive Bayes klassificerare

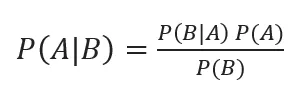

Det är en Bayes teorem-baserade algoritm, en av de statistiska klassificeringarna och kräver få mängder träningsdata för att uppskatta parametrarna även kända som probabilistiska klassificerare. Det anses vara den snabbaste klassificeringen, mycket skalbar och hanterar både diskret och kontinuerlig data. Denna algoritm användes för att göra en förutsägelse i realtid. Det finns olika typer av naiv klassificering, multinomiala naivbukar, Bernoulli naivbukar, gaussiska naiva.

Bayesisk klassificering med bakre sannolikheter ges av

Där A, B är händelser, P (A | B) - Posteriella sannolikheter.

Om två värden är oberoende av varandra då,

P (A, B) = P (A) P (B)

Naïve Bayes kan byggas med pythonbiblioteket. Naives prediktorer är oberoende, även om de används i rekommendationssystem. De används i många realtidsapplikationer och väl medvetet används i dokumentklassificering.

fördelar:

Fördelarna är att de kräver mycket mindre beräkningskraft, antas i flera klass förutsägelseproblem, fungerar exakt på stora datasätt.

Nackdel:

Den största nackdelen med denna klassificerare är att de kommer att tilldela noll sannolikhet. Och de har funktioner med är oberoende av varandra.

2) Beslutsträd

Det är en modell från ovan och ner med strukturen i flödesschemat som hanterar högdimensionella data. Resultaten förutsägs baserat på den givna inmatningsvariabeln. Beslutsträd som består av följande element: En rot, många noder, grenar, löv. Rotnoden gör partitionen baserat på attributvärdet för klassen, den interna noden tar ett attribut för ytterligare klassificering, grenarna fattar en beslutsregel att dela noderna i bladnoder, slutligen ger bladnoderna oss det slutliga resultatet. Tidens komplexitet för beslutsträdet beror på antalet poster, attribut för träningsdata. Om beslutsträdet är för långt är det svårt att få önskade resultat.

Fördel: De används för prediktiv analys för att lösa problemen och används i dagliga aktiviteter för att välja mål baserat på beslutsanalys. Skapar automatiskt en modell baserad på källdata. Bäst för att hantera saknade värden.

Nackdel: Trädets storlek är okontrollerbar tills det har några stoppkriterier. På grund av deras hierarkiska struktur är trädet instabilt.

3) Support Vector Machine

Denna algoritm spelar en viktig roll i klassificeringsproblem och mest populärt en maskininlärning övervakade algoritmer. Det är ett viktigt verktyg som används av forskaren och datavetaren. Denna SVM är mycket enkel och processen är att hitta ett hyperplan i en N-dimensionell rymddatapunkt. Hyperplan är beslutsgränser som klassificerar datapunkterna. All denna vektor faller närmare hyperplanet, maximera marginalen för klassificeraren. Om marginalen är maximal är det lägsta generaliseringsfelet. Deras implementering kan göras med kärnan med python med vissa träningsdatasätt. SVM: s huvudmål är att träna ett objekt i en viss klassificering. SVM är inte begränsat till att bli en linjär klassificering. SVM föredras mer än någon klassificeringsmodell på grund av deras kärnfunktion som förbättrar beräkningseffektiviteten.

Fördel: De är mycket att föredra för sin mindre beräkningskraft och effektiva noggrannhet. Effektiv i högdimensionellt utrymme, god minneseffektivitet.

Nackdel: Begränsningar i hastighet, kärna och storlek

4) Slumpmässig skog

Det är en kraftfull maskininlärningsalgoritm baserad på Ensembles inlärningsmetod. Den grundläggande byggstenen i slumpmässig skog är beslutsträdet som används för att bygga prediktiva modeller. Arbetsdemonstrationen inkluderar att skapa en skog av slumpmässiga beslutsträd och beskärningsprocessen utförs genom att ställa in stoppskalor för att ge ett bättre resultat. Slumpmässig skog implementeras med en teknik som kallas bagging för beslutsfattande. Denna säckning förhindrar övermontering av data genom att minska förspänningen på liknande sätt som denna slumpmässiga kan uppnå bättre noggrannhet. En slutlig förutsägelse tas av ett genomsnitt av många beslutsträd, dvs ofta förutsägelser. Den slumpmässiga skogen innehåller många användningsfall som aktiemarknadsförutsägelser, bedrägeriupptäckt, nyhetsförutsägelser.

fördelar:

- Kräver inte någon stor bearbetning för att bearbeta datasätten och en mycket enkel modell att bygga. Ger större noggrannhet hjälper till att lösa förutsägelsesproblem.

- Fungerar bra för att hantera saknade värden och upptäcker automatiskt en outlier.

Nackdel:

- Kräver hög beräkningskostnad och högt minne.

- Kräver mycket mer tidsperiod.

5) K- närmaste grannar

Här kommer vi att diskutera K-NN-algoritmen med övervakad inlärning för CART. De använder sig av K-positivt litet heltal; ett objekt tilldelas klassen baserat på grannarna eller så säger vi att tilldela en grupp genom att i vilken grupp grannen ligger. Detta väljs av avståndsmått Euklidiskt avstånd och en brute kraft. Värdet på K kan hittas med hjälp av inställningsprocessen. KNN föredrar inte att lära sig någon modell för att träna ett nytt datasätt och använda normalisering för att omskalera data.

Fördel: Ger effektiva resultat om träningsdata är enorma.

Nackdel: Den största frågan är att om variabeln är liten fungerar den bra. För det andra att välja K-faktor medan du klassificerar.

Slutsats

Sammanfattningsvis har vi gått igenom kapaciteten hos olika klassificeringsalgoritmer fungerar fortfarande som ett kraftfullt verktyg inom funktionshantering, bildklassificering som spelar en stor resurs för maskininlärning. Klassificeringsalgoritmer är kraftfulla algoritmer som löser hårda problem.

Rekommenderade artiklar

Detta är en guide till klassificeringsalgoritmer i maskininlärning. Här diskuterar vi att klassificeringen kan utföras på både strukturerad och ostrukturerad data. Du kan också gå igenom våra andra föreslagna artiklar -

- Routingalgoritmer

- Clustering algoritm

- Data Mining Process

- Maskininlärningsalgoritmer

- Mest använda tekniker för lärande av ensemble

- C ++ algoritm | Exempel på C ++ -algoritm